diff --git a/.DS_Store b/.DS_Store

index 7845dcc..26408da 100644

Binary files a/.DS_Store and b/.DS_Store differ

diff --git a/.gitignore b/.gitignore

index a1a86bf..e400f0c 100644

--- a/.gitignore

+++ b/.gitignore

@@ -134,3 +134,5 @@ dist

.yarn/build-state.yml

.yarn/install-state.gz

.pnp.*

+

+.pipeline

\ No newline at end of file

diff --git a/.vitepress/contributors.ts b/.vitepress/contributors.ts

index a818f12..f3c6941 100644

--- a/.vitepress/contributors.ts

+++ b/.vitepress/contributors.ts

@@ -58,7 +58,7 @@ interface Contributor {

export const contributors = [

{

- name: '锦恢',

+ name: 'LSTM-Kirigaya (锦恢)',

nameAliases: ['LSTM-Kirigaya', 'Kirigaya'],

mapByEmailAliases: ['1193466151@qq.com'],

links: [{ type: '', link: 'https://www.zhihu.com/people/can-meng-zhong-de-che-xian' }]

diff --git a/ja/plugin-tutorial/concept.md b/ja/plugin-tutorial/concept.md

index 894a056..ac9c31c 100644

--- a/ja/plugin-tutorial/concept.md

+++ b/ja/plugin-tutorial/concept.md

@@ -1,32 +1,30 @@

-# MCP 基础概念

+# MCP 基本概念

-## 前言

+## はじめに

+[[what-is-mcp|前回の記事]]では、MCPの定義と基本的な組織構造について簡単に紹介しました。開発者として最も注目すべきは、自社の業務とシナリオに基づいて必要なMCPサーバーをカスタマイズ開発する方法です。これにより、任意のMCPクライアントに直接接続して、カスタマイズされたインタラクション能力を大規模モデルに提供できます。

+MCPサーバーの開発方法を説明する前に、いくつかの基本概念を明確にしておく必要があると思います。

-在 [[what-is-mcp|之前的文章]] 中,我们简单介绍了 MCP 的定义和它的基本组织结构。作为开发者,我们最需要关注的其实是如何根据我们自己的业务和场景定制化地开发我们需要的 MCP 服务器,这样直接接入任何一个 MCP 客户端后,我们都可以给大模型以我们定制出的交互能力。

+## Resources、Prompts、Tools

-在正式开始教大家如何开发自己的 MCP 服务器之前,我想,或许有必要讲清楚几个基本概念。

+[MCPクライアントプロトコル](https://modelcontextprotocol.io/clients)では、MCPプロトコルの3つの重要な能力カテゴリについて説明されています:

-## Resources, Prompts 和 Tools

+- Resouces:ローカルリソースをカスタマイズしてリクエスト・アクセスする機能。ファイルシステム、データベース、現在のコードエディタ内のファイルなど、ウェブアプリでは通常アクセスできない**静的リソース**を指します。追加のresourcesは大規模モデルに送信されるコンテキストを豊富にし、AIからより正確な回答を得られます。

+- Prompts:特定のシナリオでAIが採用可能なプロンプトをカスタマイズします。例えば、AIに特定のフォーマットで内容を返させる必要がある場合、カスタムプロンプトを提供できます。

+- Tools:AIが使用できるツールで、関数である必要があります。ホテルの予約、ウェブページの開閉、照明のオンオフなどのカプセル化された関数がtoolとなります。大規模モデルはfunction callingの方法でこれらのtoolsを使用します。Toolsにより、AIが直接コンピュータを操作したり、現実世界とインタラクションしたりできるようになります。

-在 [MCP 客户端协议](https://modelcontextprotocol.io/clients) 中,讲到了 MCP 协议中三个非常重要的能力类别:

+フロントエンド・バックエンド開発経験のある方は、Resoucesを「大規模モデルに付与する追加の読み取り専用権限」、Toolsを「大規模モデルに付与する追加の読み書き権限」と考えることができます。

-- Resouces :定制化地请求和访问本地的资源,可以是文件系统、数据库、当前代码编辑器中的文件等等原本网页端的app 无法访问到的 **静态资源**。额外的 resources 会丰富发送给大模型的上下文,使得 AI 给我们更加精准的回答。

-- Prompts :定制化一些场景下可供 AI 进行采纳的 prompt,比如如果需要 AI 定制化地返回某些格式化内容时,可以提供自定义的 prompts。

-- Tools :可供 AI 使用的工具,它必须是一个函数,比如预定酒店、打开网页、关闭台灯这些封装好的函数就可以是一个 tool,大模型会通过 function calling 的方式来使用这些 tools。 Tools 将会允许 AI 直接操作我们的电脑,甚至和现实世界发生交互。

+MCPクライアント(Claude Desktop、5ireなど)は既に上記のフロントエンドロジックを実装しています。具体的にどのようなリソースやツールを提供するかは、開発者の想像力次第です。つまり、多彩なMCP Serverを開発することで、大規模モデルにより興味深い作業を行わせることができます。

-各位拥有前后端开发经验的朋友们,可以将 Resouces 看成是「额外给予大模型的只读权限」,把 Tools 看成是「额外给予大模型的读写权限」。

+ただし、現在ほぼすべての大規模モデルはopenaiプロトコルをアクセスポイントとして採用している点に注意が必要です。openaiプロトコルとは何でしょうか?

-MCP 客户端(比如 Claude Desktop,5ire 等)已经实现好了上述的前端部分逻辑。而具体提供什么资源,具体提供什么工具,则需要各位玩家充分想象了,也就是我们需要开发丰富多彩的 MCP Server 来允许大模型做出更多有意思的工作。

+## openaiプロトコル

-不过需要说明的一点是,目前几乎所有大模型采用了 openai 协议作为我们访问大模型的接入点。什么叫 openai 协议呢?

+PythonやTypeScriptでアプリを開発する際、通常はopenaiという名前のライブラリをインストールし、使用するモデルベンダー、モデルのベースURL、使用するモデルタイプを入力して大規模モデルに直接アクセスします。各モデルプロバイダーもこのライブラリとプロトコルをサポートする必要があります。

-## openai 协议

-

-当我们使用 python 或者 typescript 开发 app 时,往往会安装一个名为 openai 的库,里面填入你需要使用的模型厂商、模型的基础 url、使用的模型类别来直接访问大模型。而各个大模型提供商也必须支持这个库,这套协议。

-

-比如我们在 python 中访问 deepseek 的服务就可以这么做:

+例えばPythonでdeepseekのサービスにアクセスする場合、次のようにできます:

```python

from openai import OpenAI

@@ -45,7 +43,7 @@ response = client.chat.completions.create(

print(response.choices[0].message.content)

```

-如果你点进这个 create 函数去看,你会发现 openai 协议需要大模型厂家支持的 feature 是非常非常多的:

+このcreate関数の中身を見ると、openaiプロトコルが大規模モデルプロバイダーに要求する機能が非常に多いことがわかります:

```python

@overload

@@ -83,8 +81,8 @@ print(response.choices[0].message.content)

top_p: Optional[float] | NotGiven = NOT_GIVEN,

user: str | NotGiven = NOT_GIVEN,

web_search_options: completion_create_params.WebSearchOptions | NotGiven = NOT_GIVEN,

- # Use the following arguments if you need to pass additional parameters to the API that aren't available via kwargs.

- # The extra values given here take precedence over values defined on the client or passed to this method.

+ # 以下の引数は、kwargsを介して利用できない追加のAPIパラメータを渡す必要がある場合に使用します。

+ # ここで指定された追加の値は、クライアントで定義された値やこのメソッドに渡された値よりも優先されます。

extra_headers: Headers | None = None,

extra_query: Query | None = None,

extra_body: Body | None = None,

@@ -92,13 +90,13 @@ print(response.choices[0].message.content)

) -> ChatCompletion:

```

-从上面的签名中,你应该可以看到几个很熟悉的参数,比如 `temperature`, `top_p`,很多的大模型使用软件中,有的会给你暴露这个参数进行调节。比如在 5ire 中,内容随机度就是 `temperature` 这个参数的图形化显示。

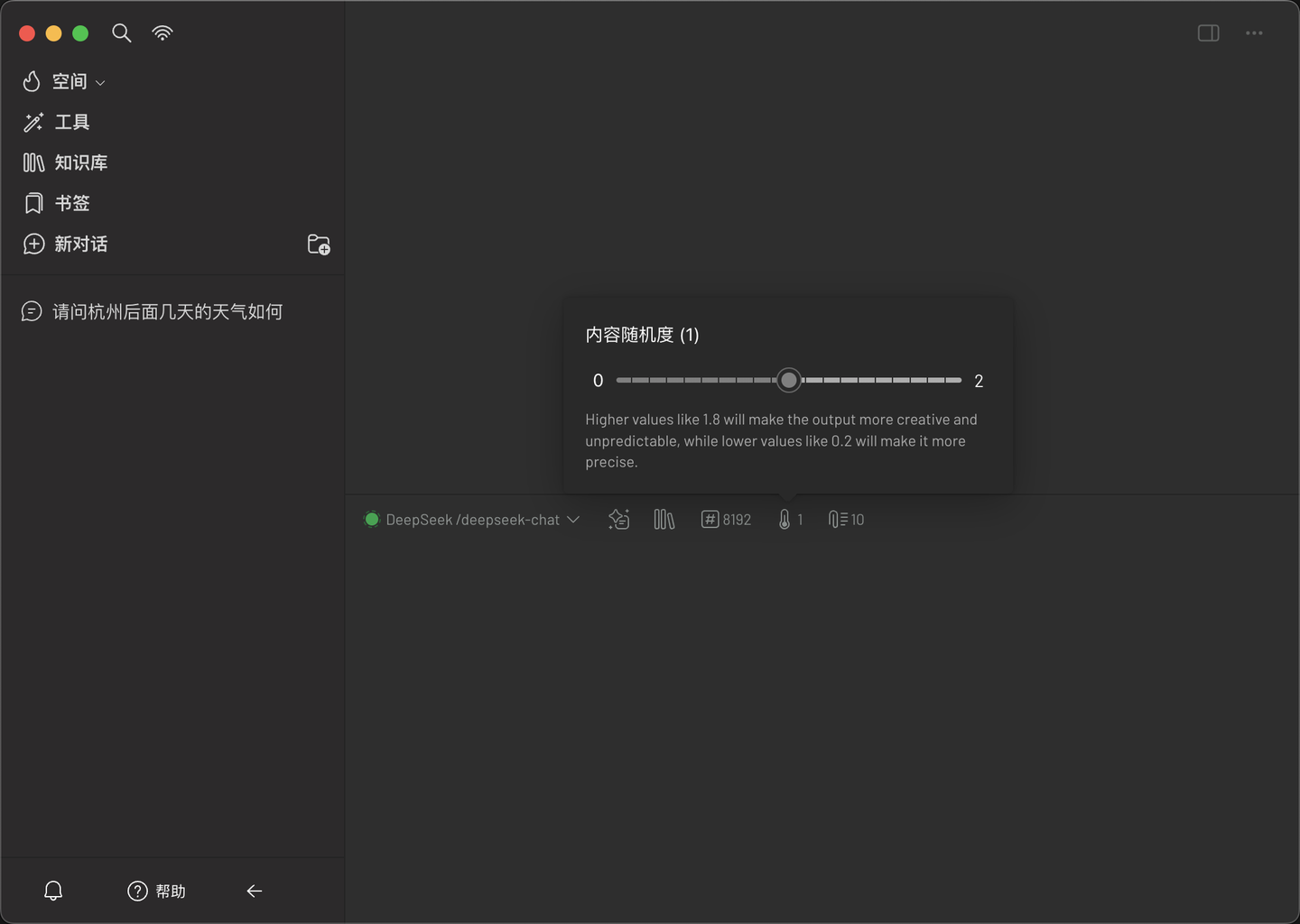

+上記のシグネチャから、`temperature`や`top_p`など、いくつか見覚えのあるパラメータが確認できます。多くの大規模モデル使用ソフトウェアでは、このパラメータを調整できるようになっています。例えば5ireでは、コンテンツのランダム性は`temperature`パラメータのグラフィカル表示です。

-其实如你所见,一次普普通通调用涉及到的可调控参数是非常之多的。而在所有参数中,你可以注意到一个参数叫做 `tools`:

+実際、ご覧の通り、普通の呼び出しに関わる調整可能なパラメータは非常に多岐にわたります。すべてのパラメータの中で、`tools`というパラメータに注目してください:

```python

@overload

@@ -109,14 +107,14 @@ print(response.choices[0].message.content)

model: Union[str, ChatModel],

audio: Optional[ChatCompletionAudioParam] | NotGiven = NOT_GIVEN,

- # 看这里

+ # ここを見て

tools: Iterable[ChatCompletionToolParam] | NotGiven = NOT_GIVEN,

) -> ChatCompletion:

```

-## tool_calls 字段

+## tool_callsフィールド

-在上面的 openai 协议中,有一个名为 tools 的参数。 tools 就是要求大模型厂商必须支持 function calling 这个特性,也就是我们提供一部分工具的描述(和 MCP 协议完全兼容的),在 tools 不为空的情况下,chat 函数返回的值中会包含一个特殊的字段 `tool_calls`,我们可以运行下面的我写好的让大模型调用可以查询天气的代码:

+上記のopenaiプロトコルには、toolsというパラメータがあります。toolsは、大規模モデルプロバイダーがfunction callingという特性をサポートする必要があることを意味します(MCPプロトコルと完全互換)。toolsが空でない場合、chat関数の戻り値には特別なフィールド`tool_calls`が含まれます。以下は、私が作成した天気を問い合わせるコードです:

```python

from openai import OpenAI

@@ -126,19 +124,19 @@ client = OpenAI(

base_url="https://api.deepseek.com"

)

-# 定义 tools(函数/工具列表)

+# tools(関数/ツールリスト)を定義

tools = [

{

"type": "function",

"function": {

"name": "get_current_weather",

- "description": "获取给定地点的天气",

+ "description": "指定された場所の天気を取得",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

- "description": "城市,比如杭州,北京,上海",

+ "description": "都市、例えば杭州、北京、上海",

}

},

"required": ["location"],

@@ -150,18 +148,18 @@ tools = [

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

- {"role": "system", "content": "你是一个很有用的 AI"},

- {"role": "user", "content": "今天杭州的天气是什么?"},

+ {"role": "system", "content": "あなたは役立つAIです"},

+ {"role": "user", "content": "今日の杭州の天気は?"},

],

- tools=tools, # 传入 tools 参数

- tool_choice="auto", # 可选:控制是否强制调用某个工具

+ tools=tools, # toolsパラメータを渡す

+ tool_choice="auto", # オプション:特定のツールの呼び出しを強制するかどうかを制御

stream=False,

)

print(response.choices[0].message)

```

-运行上述代码,它的返回如下:

+上記のコードを実行すると、次のような戻り値が得られます:

```python

ChatCompletionMessage(

@@ -185,48 +183,44 @@ ChatCompletionMessage(

)

```

-可以看到上面的 `tool_calls` 给出了大模型想要如何去使用我们给出的工具。需要说明的一点是,收到上下文的限制,目前一个问题能够让大模型调取的工具上限一般不会超过 100 个,这个和大模型厂商的上下文大小有关系。奥,对了,友情提示,当你使用 MCP 客户端在使用大模型解决问题时,同一时间激活的 MCP Server 越多,消耗的 token 越多哦 :D

+上記の`tool_calls`から、大規模モデルが提供されたツールをどのように使用したいかがわかります。注意点として、コンテキストの制限により、現在1つの質問で大規模モデルが呼び出せるツールの上限は通常100個を超えません。これは大規模モデルプロバイダーのコンテキストサイズに関係します。あ、そうそう、友情提示ですが、MCPクライアントで大規模モデルを使用して問題を解決する際、同時にアクティブなMCP Serverが多いほど、消費されるtokenも多くなりますよ :D

-而目前 openai 的协议中,tools 是只支持函数类的调用。而函数类的调用往往是可以模拟出 Resources 的效果的。比如取资源,你可以描述为一个 tool。因此在正常情况下,如果大家要开发 MCP Server,最好只开发 Tools,另外两个 feature 还暂时没有得到广泛支持。

+現在のopenaiプロトコルでは、toolsは関数クラスの呼び出しのみをサポートしています。関数クラスの呼び出しは、Resourcesの効果をシミュレートできる場合があります。例えばリソースを取得する場合、それをtoolとして記述できます。したがって、通常の場合、MCP Serverを開発する際は、Toolsのみを開発するのが最善です。他の2つの機能はまだ広くサポートされていません。

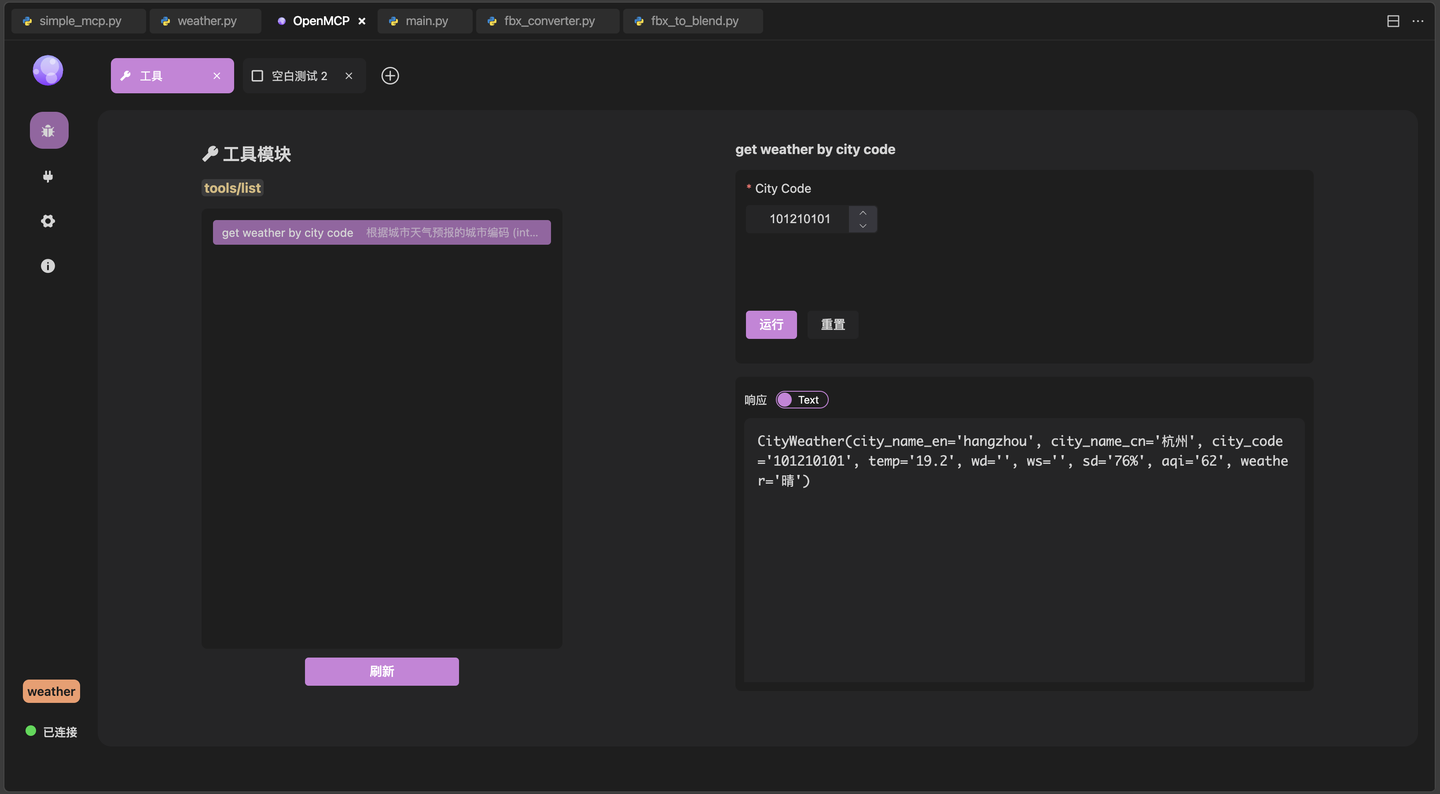

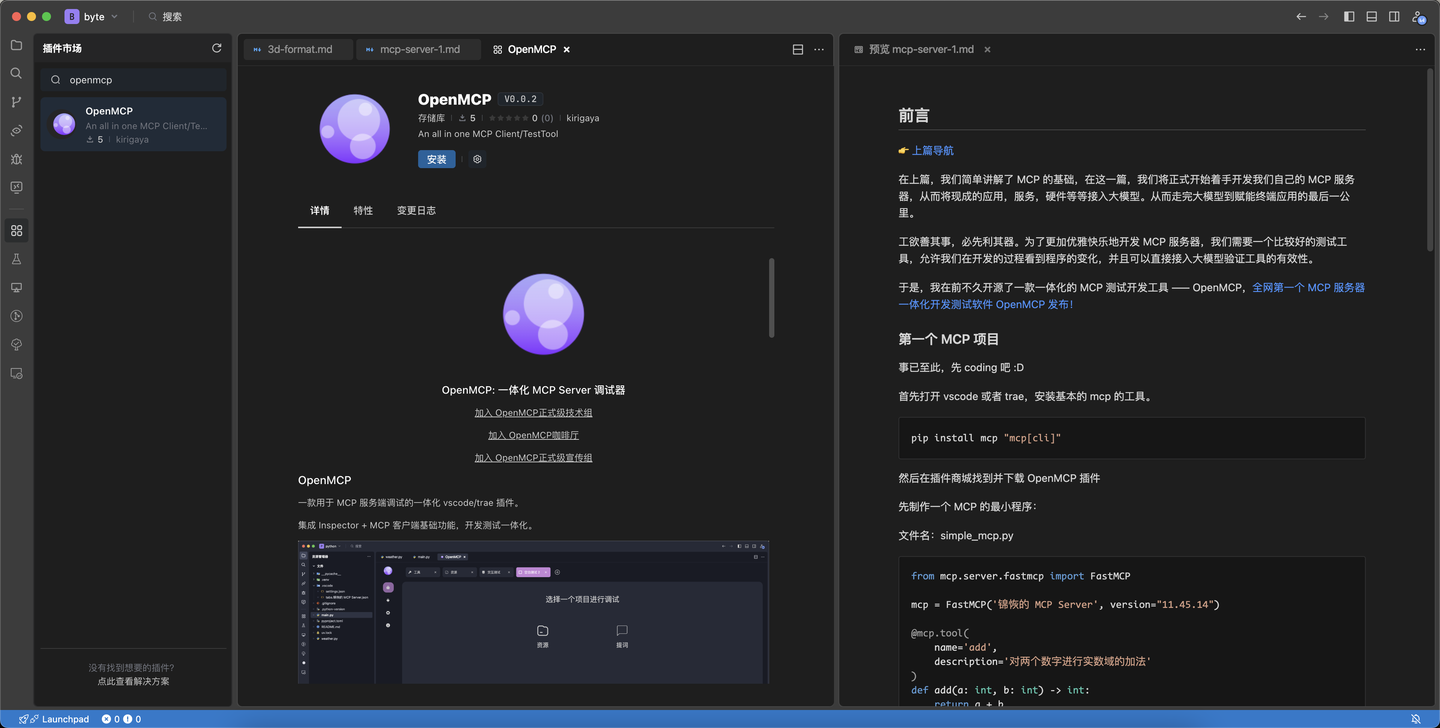

+## Inspectorを使用したデバッグ

-

-## 使用 Inspector 进行调试

-

-Claude 原生提供的 MCP 协议可以通过官方提供的 Inspector 进行调试,对于 [[first-mcp|你的第一个 MCP]] 中的例子,可以如下进行调试,在命令行输入如下命令启动 Inspector:

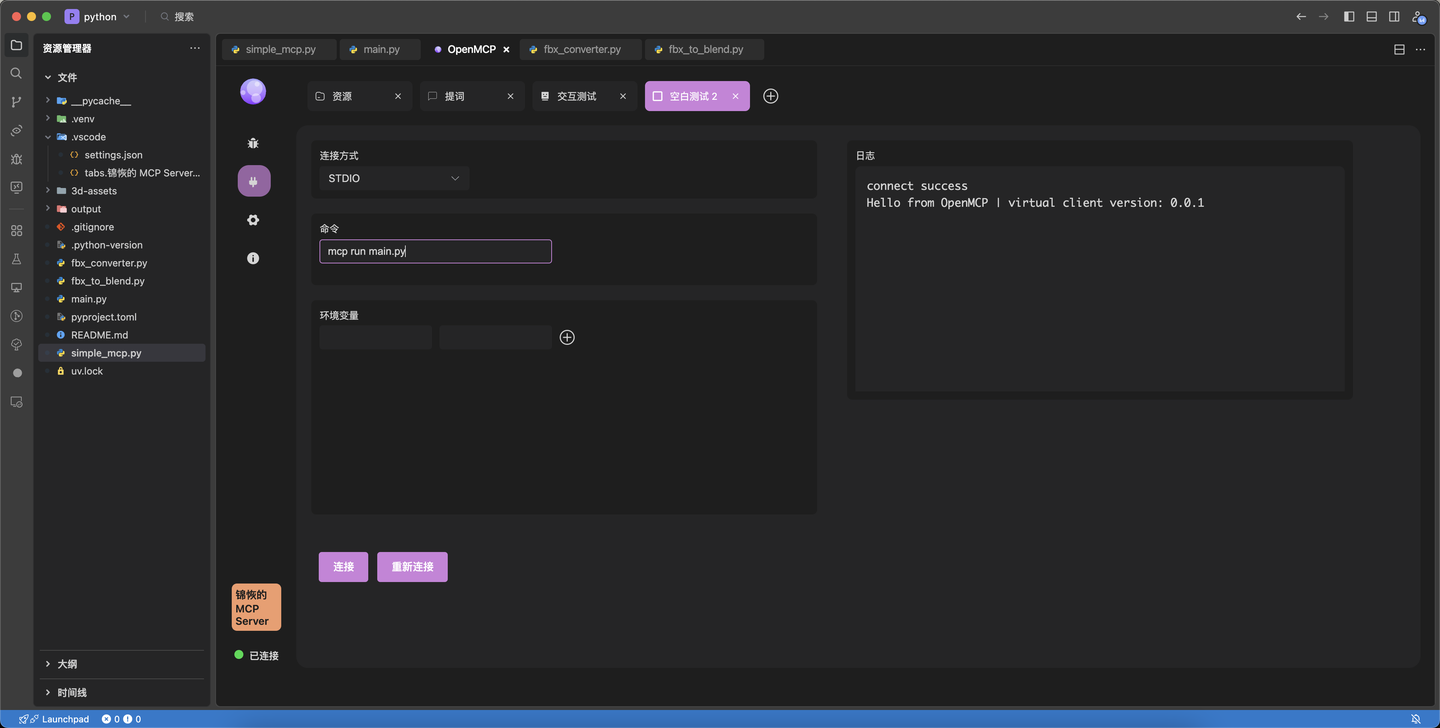

+Claudeがネイティブで提供するMCPプロトコルは、公式が提供するInspectorでデバッグできます。[[first-mcp|最初のMCP]]の例では、次のようにデバッグできます。コマンドラインで次のコマンドを入力してInspectorを起動します:

```bash

mcp dev main.py

```

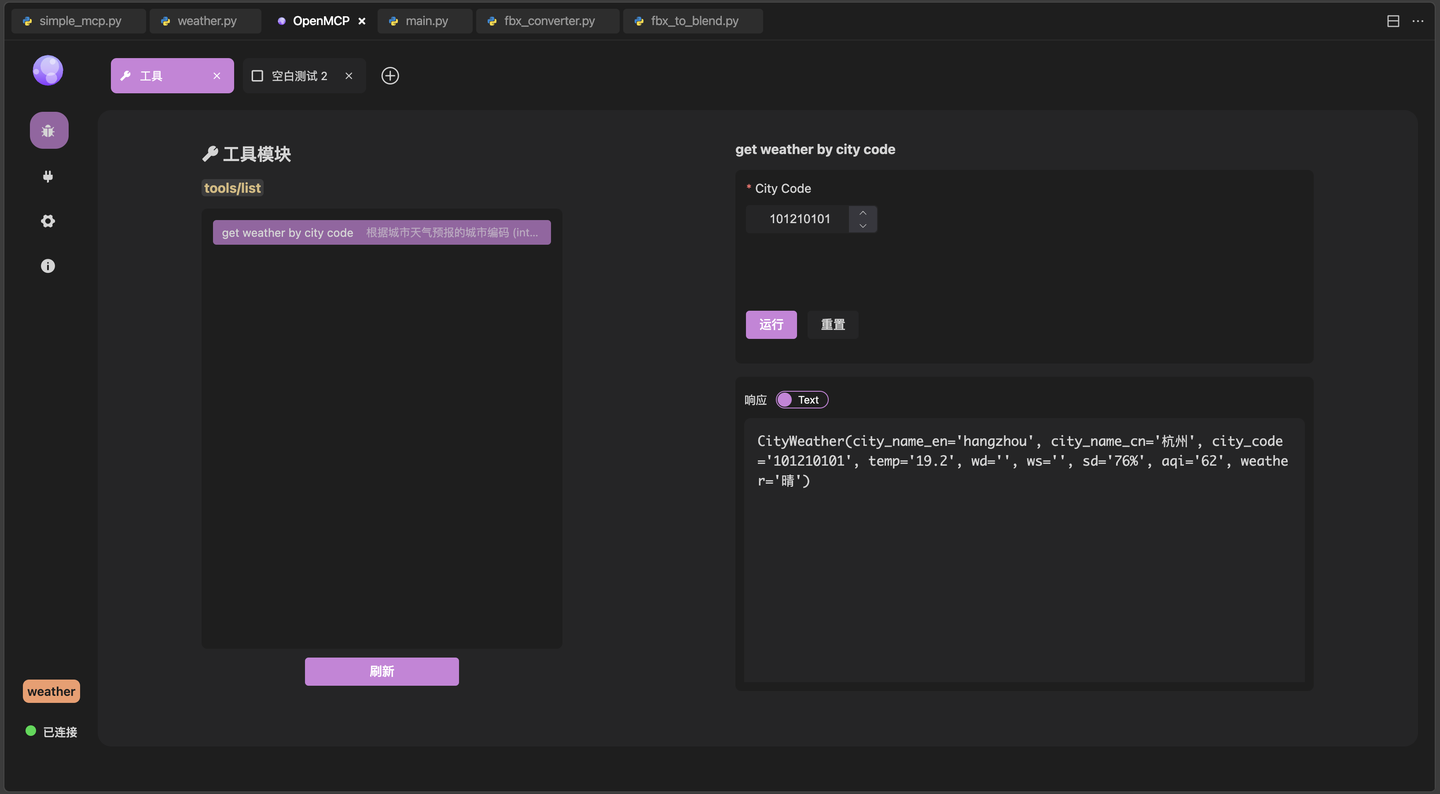

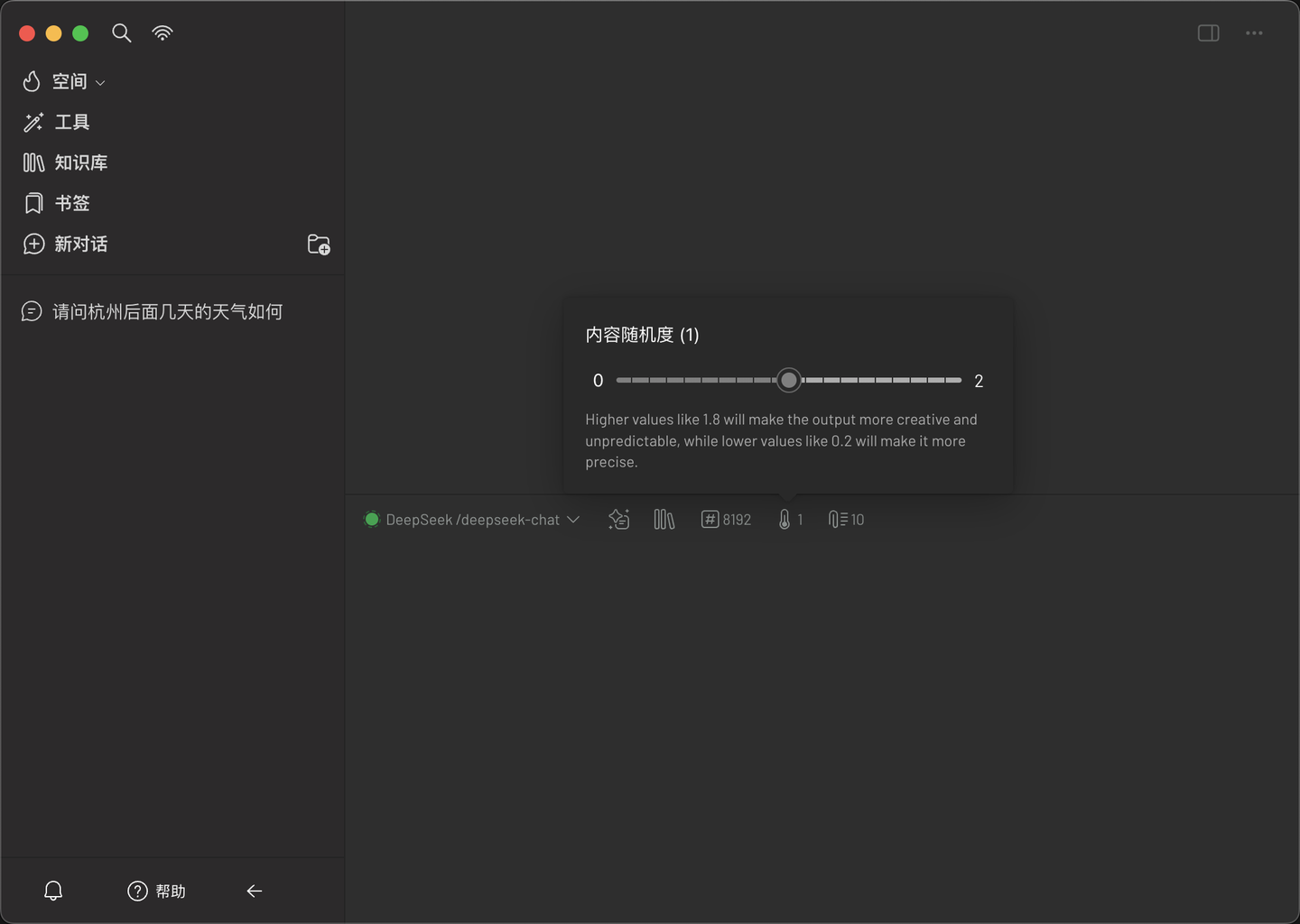

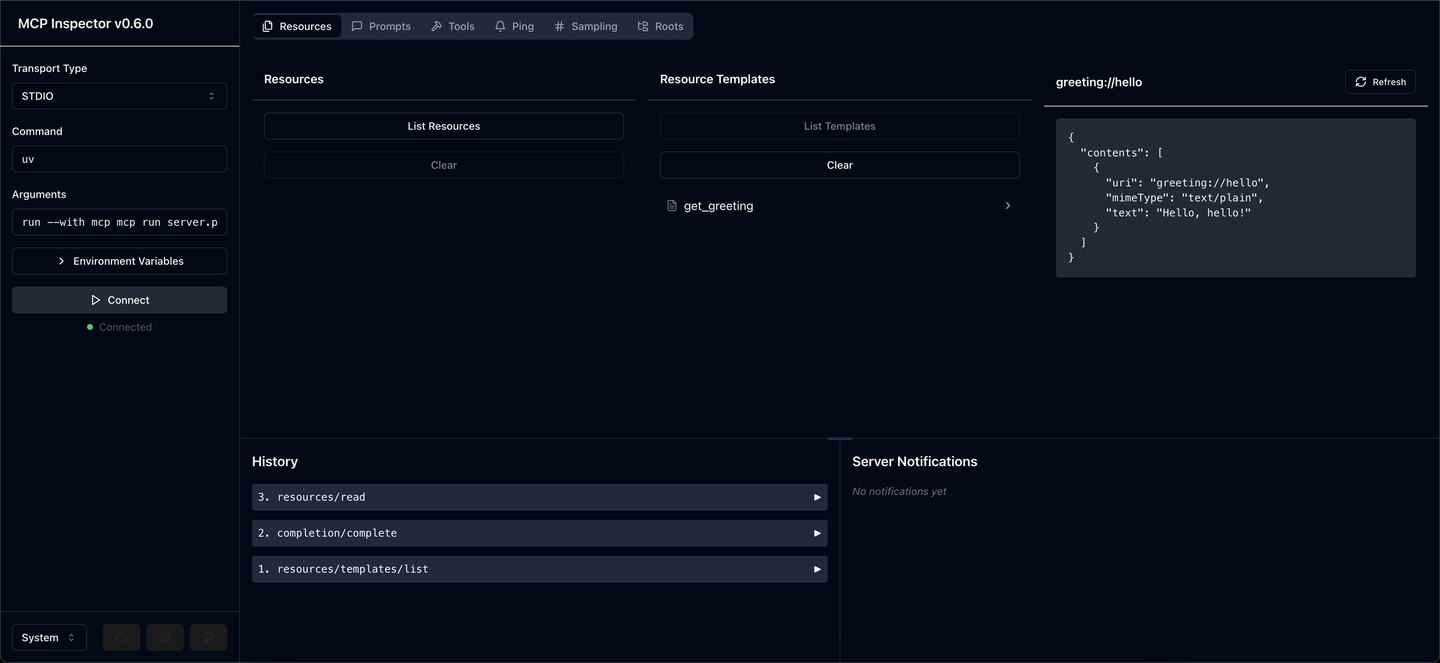

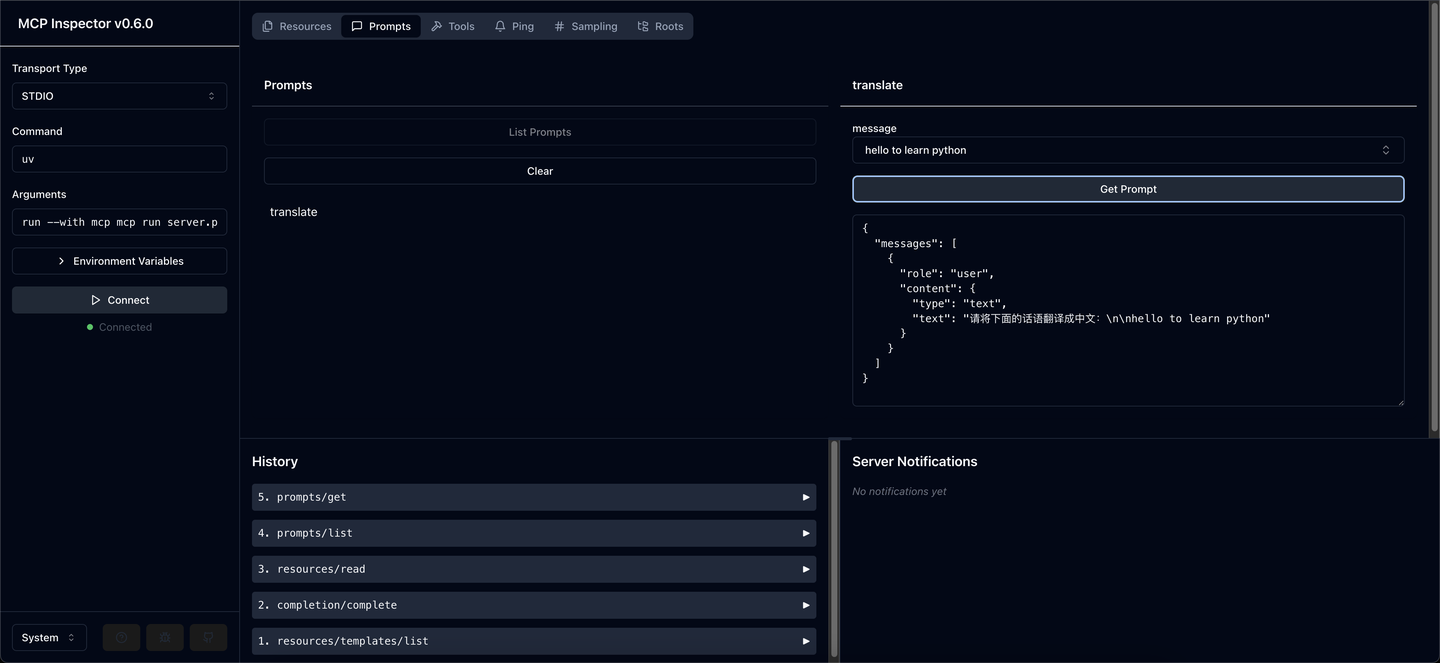

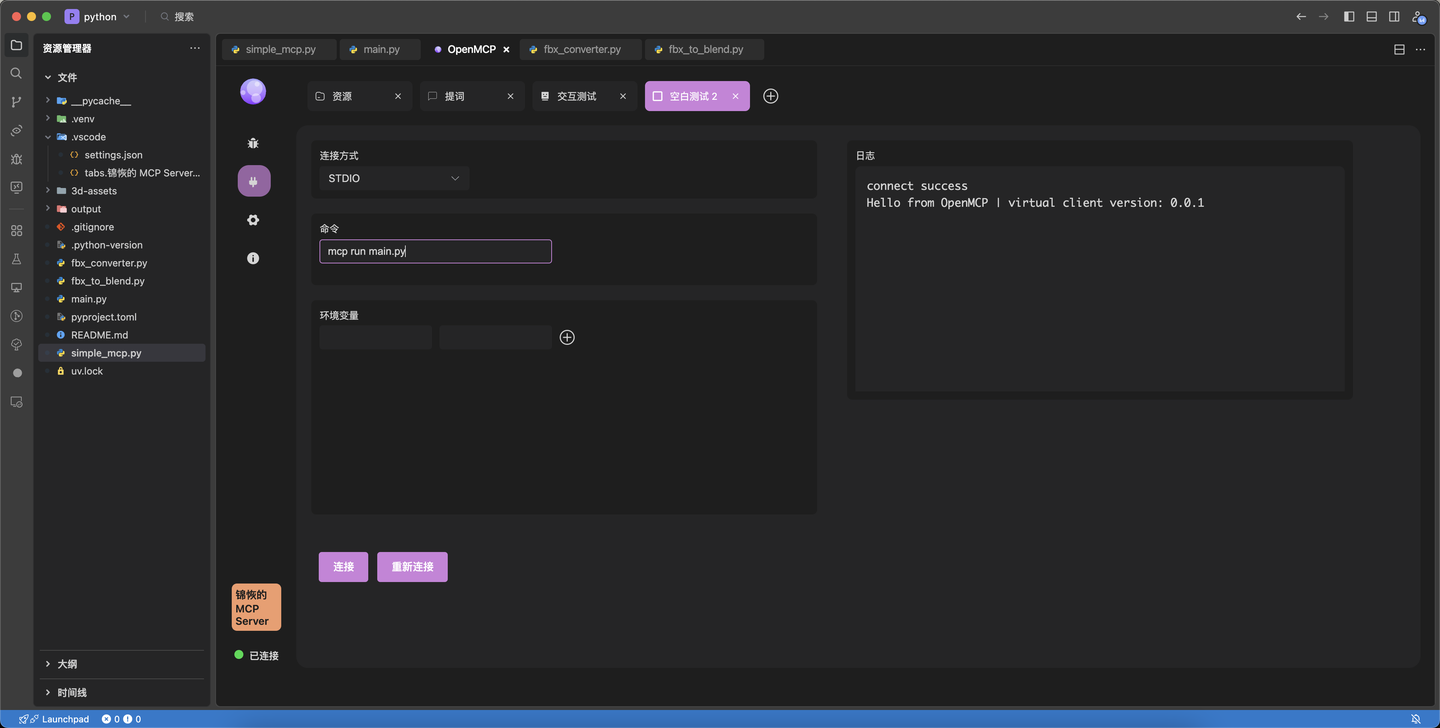

-这会启动一个前端服务器,并打开 `http://localhost:5173/` 后我们可以看到 inspector 的调试界面,先点击左侧的 `Connect` 来运行我们的 server.py 并通过 stdio 为通信管道和 web 建立通信。

+これによりフロントエンドサーバーが起動し、`http://localhost:5173/`を開くとinspectorのデバッグインターフェースが表示されます。まず左側の`Connect`をクリックしてserver.pyを実行し、stdioを通信パイプとして使用してwebと通信を確立します。

-Fine,可以开始愉快地进行调试了,Inspector 主要给了我们三个板块,分别对应 Resources,Prompts 和 Tools。

+さあ、楽しくデバッグを始められます。Inspectorは主に3つのセクションを提供し、それぞれResources、Prompts、Toolsに対応しています。

-先来看 Resources,点击「Resource Templates」可以罗列所有注册的 Resource,比如我们上文定义的 `get_greeting`,你可以通过输入参数运行来查看这个函数是否正常工作。(因为一般情况下的这个资源协议是会访问远程数据库或者微服务的)

+まずResourcesを見てみましょう。「Resource Templates」をクリックすると、登録されているすべてのResourceがリスト表示されます。例えば上記で定義した`get_greeting`は、パラメータを入力して実行することで、この関数が正常に動作するかどうかを確認できます。(通常、このリソースプロトコルはリモートデータベースまたはマイクロサービスにアクセスします)

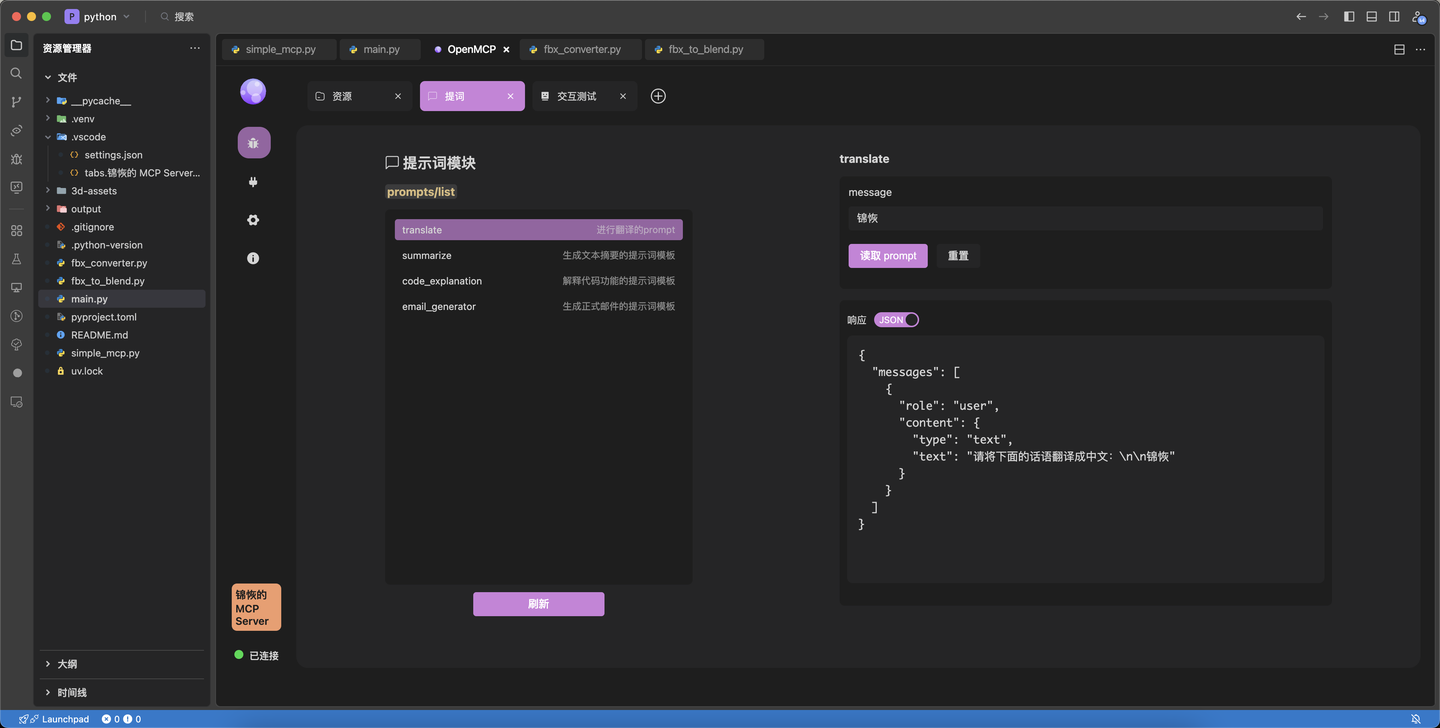

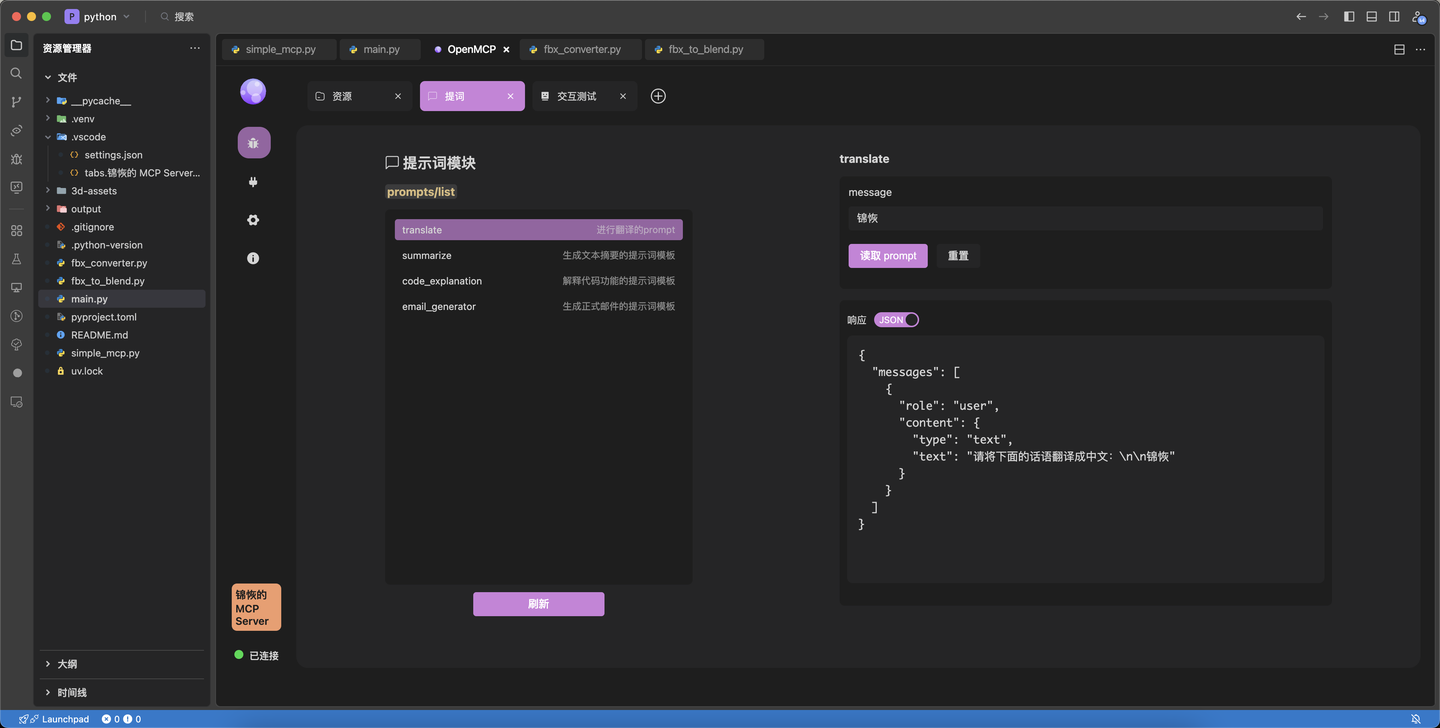

-Prompts 端就比较简单了,直接输入预定义参数就能获取正常的返回结果。

+Prompts側は比較的シンプルで、定義済みパラメータを入力するだけで正常な戻り値を取得できます。

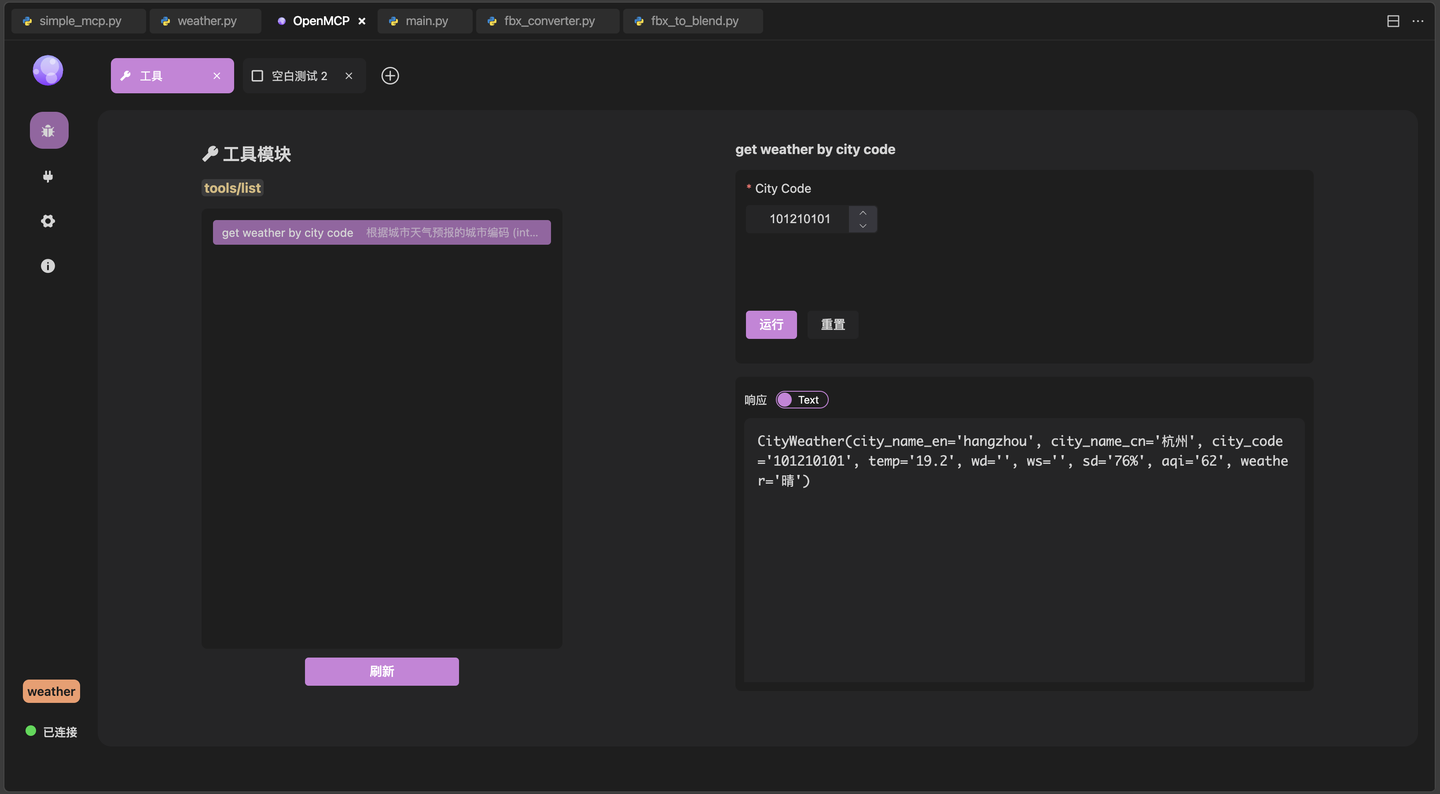

-Tools 端将会是我们后面调试的核心。在之前的章节我们讲过了,MCP 协议中的 Prompts 和 Resources 目前还没有被 openai 协议和各大 MCP 客户端广泛支持,因此,我们主要的服务端业务都应该是在写 tools。

+Tools側は、これからデバッグの中心となる部分です。前の章で説明したように、MCPプロトコルのPromptsとResourcesは現在openaiプロトコルや主要なMCPクライアントで広くサポートされていないため、サーバー側の主要なビジネスはtoolsの作成に集中すべきです。

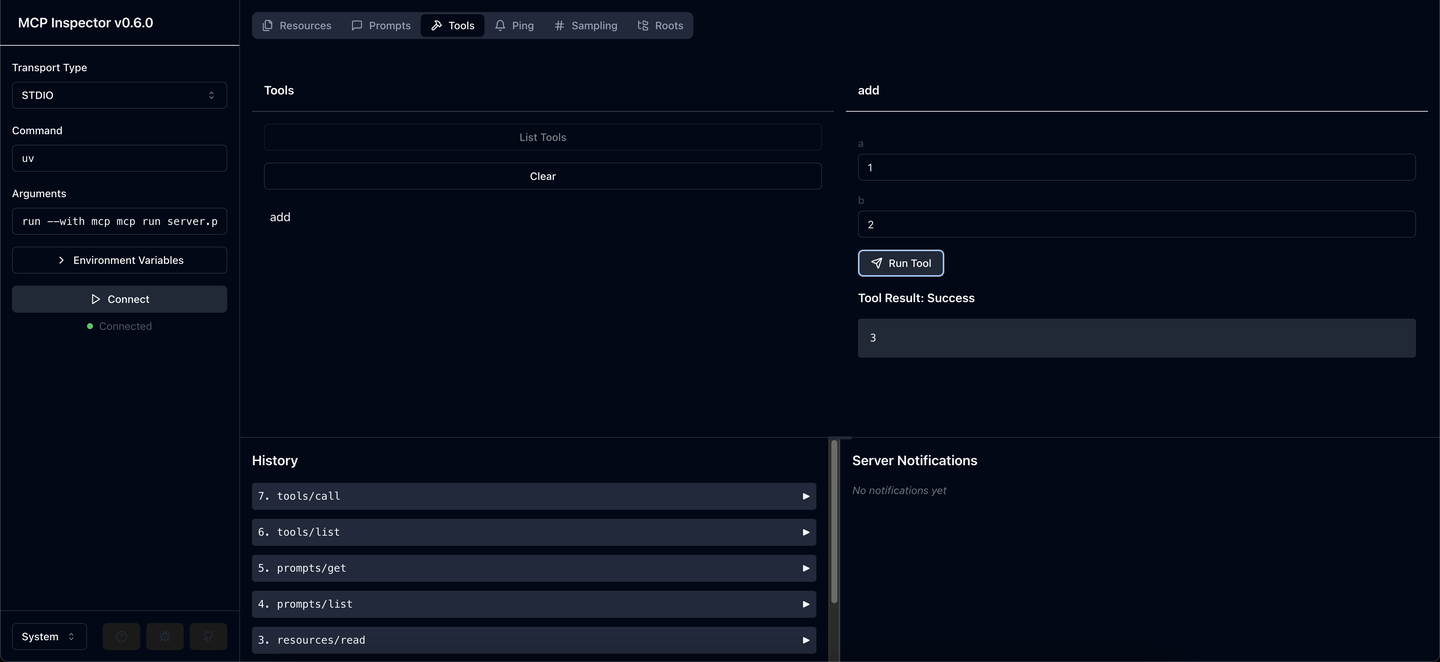

-我们此处提供的 tool 是实现一个简单的加法,它非常简单,我们输入 1 和 2 就可以直接看到结果是 3。我们后续会开发一个可以访问天气预报的 tool,那么到时候就非常需要一个这样的窗口来调试我们的天气信息获取是否正常了。

+ここで提供するtoolは、簡単な加算を実装するものです。非常にシンプルで、1と2を入力すると、結果が3であることが直接確認できます。今後、天気予報にアクセスできるtoolを開発する予定ですので、その際はこのようなウィンドウが天気情報の取得が正常かどうかをデバッグするのに非常に役立ちます。

+## まとめ

+この記事では、MCP内部のいくつかの基本概念について簡単に理解しました。これらの概念は、MCPサーバーを開発する上で非常に有益だと思いますので、まず説明する必要があると考えました。

-## 结语

-

-这篇文章,我们简单了解了 MCP 内部的一些基本概念,我认为这些概念对于诸位开发一个 MCP 服务器是大有裨益的,所以我认为有必要先讲一讲。

-

-下面的文章中,我将带领大家探索 MCP 的奇境,一个属于 AI Agent 的时代快要到来了。

+次の記事では、MCPの不思議な世界を探求し、AI Agentの時代がまもなく到来することをお伝えします。

\ No newline at end of file

diff --git a/ja/plugin-tutorial/examples/go-neo4j-sse.md b/ja/plugin-tutorial/examples/go-neo4j-sse.md

index 24a11db..91ae39d 100644

--- a/ja/plugin-tutorial/examples/go-neo4j-sse.md

+++ b/ja/plugin-tutorial/examples/go-neo4j-sse.md

@@ -1,32 +1,30 @@

-# go 实现 neo4j 的只读 mcp 服务器 (SSE)

+# Goで実装するNeo4jの読み取り専用MCPサーバー(SSE)

-[本期教程视频](https://www.bilibili.com/video/BV1g8TozyEE7/)

+[今回のチュートリアル動画](https://www.bilibili.com/video/BV1g8TozyEE7/)

-## 前言

+## はじめに

-本篇教程,演示一下如何使用 go 语言写一个可以访问 neo4j 数据库的 mcp 服务器。实现完成后,我们不需要写任何 查询代码 就能通过询问大模型了解服务器近况。

+このチュートリアルでは、Go言語を使ってNeo4jデータベースにアクセスできるMCPサーバーを書く方法をデモンストレーションします。実装が完了すると、クエリコードを一切書かずに、大規模言語モデルに問い合わせるだけでサーバーの状況を把握できるようになります。

-不同于之前的连接方式,这次,我们将采用 SSE 的方式来完成服务器的创建和连接。

+従来の接続方法とは異なり、今回はSSE(Server-Sent Events)方式でサーバーの作成と接続を行います。

-本期教程的代码:https://github.com/LSTM-Kirigaya/openmcp-tutorial/tree/main/neo4j-go-server

+今回のチュートリアルのコード:https://github.com/LSTM-Kirigaya/openmcp-tutorial/tree/main/neo4j-go-server

-建议下载本期的代码,因为里面有我为大家准备好的数据库文件。要不然,你们得自己 mock 数据了。

+このコードをダウンロードすることをお勧めします。なぜなら、私が準備したデータベースファイルが含まれているからです。そうでないと、自分でデータをモックする必要があります。

+## 1. 準備

-

-## 1. 准备

-

-项目结构如下:

+プロジェクトの構造は以下の通りです:

```bash

📦neo4j-go-server

┣ 📂util

- ┃ ┗ 📜util.go # 工具函数

- ┣ 📜main.go # 主函数

- ┗ 📜neo4j.json # 数据库连接的账号密码

+ ┃ ┗ 📜util.go # ユーティリティ関数

+ ┣ 📜main.go # メイン関数

+ ┗ 📜neo4j.json # データベース接続のアカウント情報

```

-我们先创建一个 go 项目:

+まずGoプロジェクトを作成します:

```bash

mkdir neo4j-go-server

@@ -34,15 +32,13 @@ cd neo4j-go-server

go mod init neo4j-go-server

```

+## 2. データベースの初期化を完了する

+### 2.1 Neo4jのインストール

-## 2. 完成数据库初始化

+まず、私のチュートリアルに従ってローカルまたはサーバーにNeo4jデータベースを設定します。ここではチュートリアルですので、このチュートリアルの最初の2ステップだけを完了すれば十分です:[Neo4jデータベースのインストールと設定](https://kirigaya.cn/blog/article?seq=199)。binパスを環境変数に追加し、パスワードをopenmcpに設定します。

-### 2.1 安装 neo4j

-

-首先,根据我的教程在本地或者服务器配置一个 neo4j 数据库,这里是是教程,你只需要完成该教程的前两步即可: [neo4j 数据库安装与配置](https://kirigaya.cn/blog/article?seq=199)。将 bin 路径加入环境变量,并且设置的密码设置为 openmcp。

-

-然后在 main.go 同级下创建 neo4j.json,填写 neo4j 数据库的连接信息:

+次に、main.goと同じ階層にneo4j.jsonを作成し、Neo4jデータベースの接続情報を記入します:

```json

{

@@ -52,9 +48,9 @@ go mod init neo4j-go-server

}

```

-### 2.2 导入事先准备好的数据

+### 2.2 事前に準備されたデータのインポート

-安装完成后,大家可以导入我实现准备好的数据,这些数据是我的个人网站上部分数据脱敏后的摘要,大家可以随便使用,下载链接:[neo4j.db](https://github.com/LSTM-Kirigaya/openmcp-tutorial/releases/download/neo4j.db/neo4j.db)。下载完成后,运行下面的命令:

+インストールが完了したら、私が事前に準備したデータをインポートできます。これらのデータは私の個人ウェブサイトの一部のデータを匿名化した要約です。自由に使用してください。ダウンロードリンク:[neo4j.db](https://github.com/LSTM-Kirigaya/openmcp-tutorial/releases/download/neo4j.db/neo4j.db)。ダウンロードが完了したら、以下のコマンドを実行します:

```bash

neo4j stop

@@ -62,7 +58,7 @@ neo4j-admin load --database neo4j --from neo4j.db --force

neo4j start

```

-然后,我们登录数据库就能看到我准备好的数据啦:

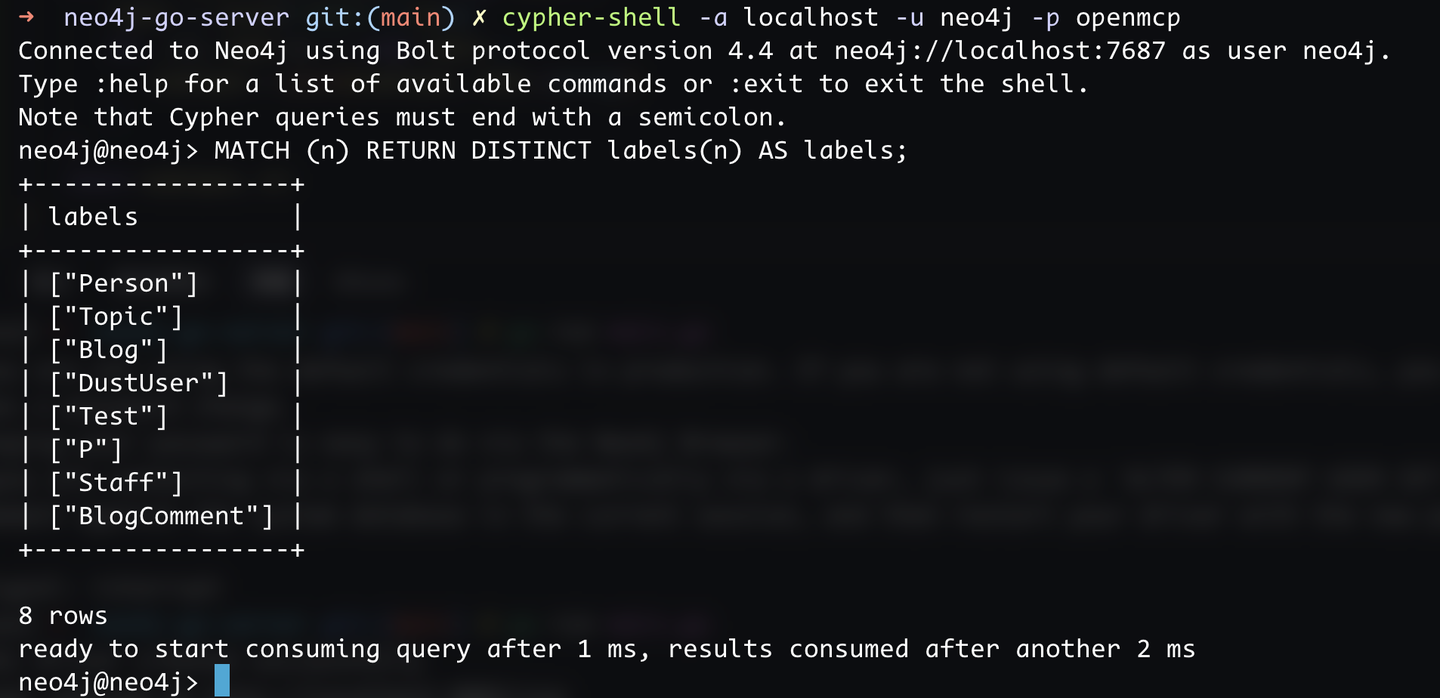

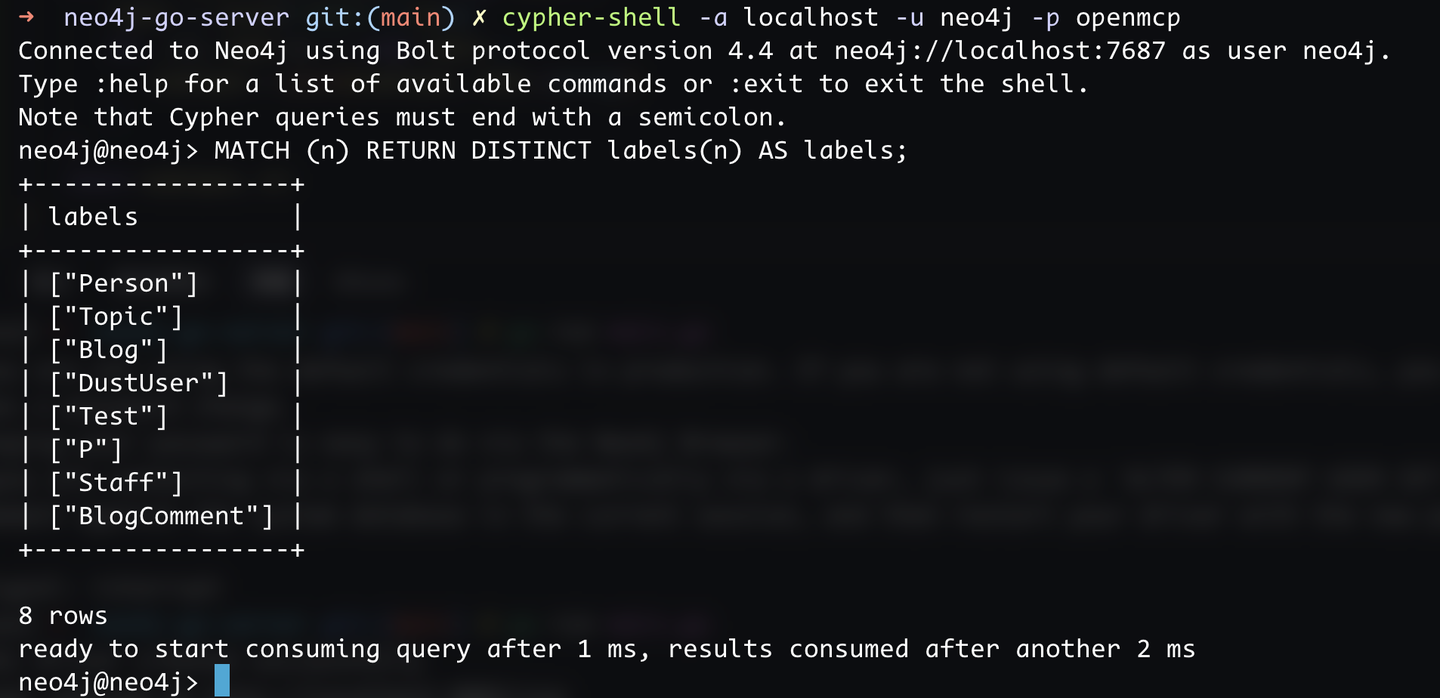

+その後、データベースにログインすると、私が準備したデータを見ることができます:

```bash

cypher-shell -a localhost -u neo4j -p openmcp

@@ -72,17 +68,17 @@ cypher-shell -a localhost -u neo4j -p openmcp

-### 2.3 验证 go -> 数据库连通性

+### 2.3 Goからデータベースへの接続性を検証する

-为了验证数据库的连通性和 go 的数据库驱动是否正常工作,我们需要先写一段数据库访问的最小系统。

+データベースの接続性とGoのデータベースドライバーが正常に動作していることを確認するために、まずデータベースアクセスの最小システムを書く必要があります。

-先安装 neo4j 的 v5 版本的 go 驱动:

+まず、Neo4jのv5バージョンのGoドライバーをインストールします:

```bash

go get github.com/neo4j/neo4j-go-driver/v5

```

-在 `util.go` 中添加以下代码:

+`util.go`に以下のコードを追加します:

```go

package util

@@ -100,7 +96,7 @@ var (

Neo4jDriver neo4j.DriverWithContext

)

-// 创建 neo4j 服务器的连接

+// Neo4jサーバーへの接続を作成

func CreateNeo4jDriver(configPath string) (neo4j.DriverWithContext, error) {

jsonString, _ := os.ReadFile(configPath)

config := make(map[string]string)

@@ -120,7 +116,7 @@ func CreateNeo4jDriver(configPath string) (neo4j.DriverWithContext, error) {

}

-// 执行只读的 cypher 查询

+// 読み取り専用のCypherクエリを実行

func ExecuteReadOnlyCypherQuery(

cypher string,

) ([]map[string]any, error) {

@@ -145,7 +141,7 @@ func ExecuteReadOnlyCypherQuery(

}

```

-main.go 中添加以下代码:

+main.goに以下のコードを追加します:

```go

package main

@@ -170,66 +166,64 @@ func main() {

}

```

-运行主程序来验证数据库的连通性:

+メインプログラムを実行してデータベースの接続性を検証します:

```bash

go run main.go

```

-如果输出了 `Neo4j driver created successfully`,则说明数据库的连通性验证通过。

+`Neo4j driver created successfully`と出力されれば、データベースの接続性検証は成功です。

+## 3. MCPサーバーの実装

+GoのMCP SDKで最も有名なのはmark3labs/mcp-goです。これを使用します。

-## 3. 实现 mcp 服务器

+> mark3labs/mcp-goのデモはhttps://github.com/mark3labs/mcp-goにあり、非常にシンプルです。ここでは直接使用します。

-go 的 mcp 的 sdk 最为有名的是 mark3labs/mcp-go 了,我们就用这个。

-

-> mark3labs/mcp-go 的 demo 在 https://github.com/mark3labs/mcp-go,非常简单,此处直接使用即可。

-

-先安装

+まずインストールします:

```bash

go get github.com/mark3labs/mcp-go

```

-然后在 `main.go` 中添加以下代码:

+次に`main.go`に以下のコードを追加します:

```go

-// ... existing code ...

+// ... 既存のコード ...

var (

addr string = "localhost:8083"

)

func main() {

- // ... existing code ...

+ // ... 既存のコード ...

s := server.NewMCPServer(

- "只读 Neo4j 服务器",

+ "読み取り専用Neo4jサーバー",

"0.0.1",

server.WithToolCapabilities(true),

)

srv := server.NewSSEServer(s)

- // 定义 executeReadOnlyCypherQuery 这个工具的 schema

+ // executeReadOnlyCypherQueryツールのスキーマを定義

executeReadOnlyCypherQuery := mcp.NewTool("executeReadOnlyCypherQuery",

- mcp.WithDescription("执行只读的 Cypher 查询"),

+ mcp.WithDescription("読み取り専用のCypherクエリを実行"),

mcp.WithString("cypher",

mcp.Required(),

- mcp.Description("Cypher 查询语句,必须是只读的"),

+ mcp.Description("Cypherクエリ文、読み取り専用でなければなりません"),

),

)

- // 将真实函数和申明的 schema 绑定

+ // 実際の関数と宣言されたスキーマをバインド

s.AddTool(executeReadOnlyCypherQuery, func(ctx context.Context, request mcp.CallToolRequest) (*mcp.CallToolResult, error) {

args, ok := request.Params.Arguments.(map[string]interface{})

if !ok {

- return mcp.NewToolResultText(""), fmt.Errorf("invalid arguments type")

+ return mcp.NewToolResultText(""), fmt.Errorf("無効な引数の型")

}

cypher, ok := args["cypher"].(string)

if !ok {

- return mcp.NewToolResultText(""), fmt.Errorf("cypher argument is not a string")

+ return mcp.NewToolResultText(""), fmt.Errorf("cypher引数が文字列ではありません")

}

result, err := util.ExecuteReadOnlyCypherQuery(cypher)

@@ -242,247 +236,104 @@ func main() {

return mcp.NewToolResultText(fmt.Sprintf("%v", result)), nil

})

- // 在 http://localhost:8083/sse 开启服务

- fmt.Printf("Server started at http://%s/sse\n", addr)

+ // http://localhost:8083/sseでサービスを開始

+ fmt.Printf("サーバーがhttp://%s/sseで起動しました\n", addr)

srv.Start(addr)

}

```

-go run main.go 运行上面的代码,你就能看到如下信息:

+go run main.goを実行すると、以下の情報が表示されます:

```

Neo4j driver created successfully

-Server started at http://localhost:8083/sse

+サーバーがhttp://localhost:8083/sseで起動しました

```

-说明我们的 mcp 服务器在本地的 8083 上启动了。

+これで、MCPサーバーがローカルの8083ポートで起動しました。

+## 4. OpenMCPを使用したデバッグ

+### 4.1 ワークスペースにSSEデバッグプロジェクトを追加

-## 4. 通过 openmcp 来进行调试

-

-### 4.1 添加工作区 sse 调试项目

-

-接下来,我们来通过 openmcp 进行调试,先点击 vscode 左侧的 openmcp 图标进入控制面板,如果你是下载的 https://github.com/LSTM-Kirigaya/openmcp-tutorial/tree/main/neo4j-go-server 这个项目,那么你能看到【MCP 连接(工作区)】里面已经有一个创建好的调试项目【只读 Neo4j 服务器】了。如果你是完全自己做的这个项目,可以通过下面的按钮添加连接,选择 sse 后填入 http://localhost:8083/sse,oauth 空着不填即可。

+次に、OpenMCPを使用してデバッグを行います。まず、VSコードの左側にあるOpenMCPアイコンをクリックしてコントロールパネルに入ります。https://github.com/LSTM-Kirigaya/openmcp-tutorial/tree/main/neo4j-go-server からこのプロジェクトをダウンロードした場合、【MCP接続(ワークスペース)】に既に作成済みのデバッグプロジェクト【読み取り専用Neo4jサーバー】が表示されます。完全に自分でこのプロジェクトを作成した場合は、以下のボタンから接続を追加し、SSEを選択してhttp://localhost:8083/sseを入力し、OAuthは空のままにします。

-### 4.2 测试工具

+### 4.2 ツールのテスト

-第一次调试 mcp 服务器要做的事情一定是先调通 mcp tool,新建标签页,选择 tool,点击下图的工具,输入 `CALL db.labels() YIELD label RETURN label`,这个语句是用来列出所有节点类型的。如果输出下面的结果,说明当前的链路生效,没有问题。

+MCPサーバーを初めてデバッグする際に最初に行うべきことは、MCPツールを動作させることです。新しいタブを作成し、ツールを選択し、以下の図のツールをクリックして、`CALL db.labels() YIELD label RETURN label`と入力します。この文はすべてのノードタイプをリストアップするために使用されます。以下の結果が出力されれば、現在のリンクは有効で問題ありません。

+### 4.3 大規模言語モデルの機能範囲を理解し、プロンプトで知識をカプセル化する

-### 4.3 摸清大模型功能边界,用提示词来封装我们的知识

-

-然后,让我们做点有趣的事情吧!我们接下来要测试一下大模型的能力边界,因为 neo4j 属于特种数据库,通用大模型不一定知道怎么用它。新建标签页,点击「交互测试」,我们先问一个简单的问题:

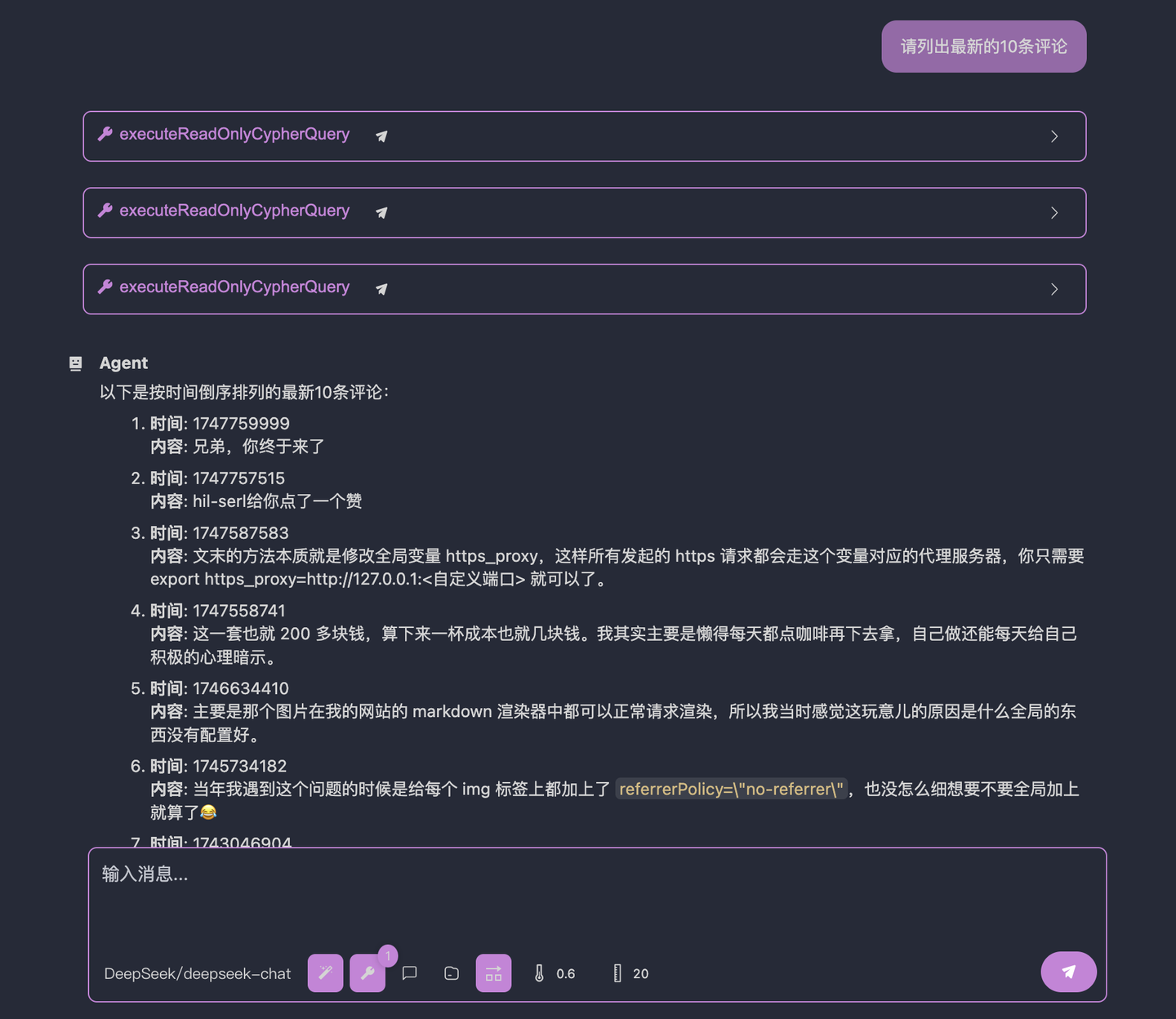

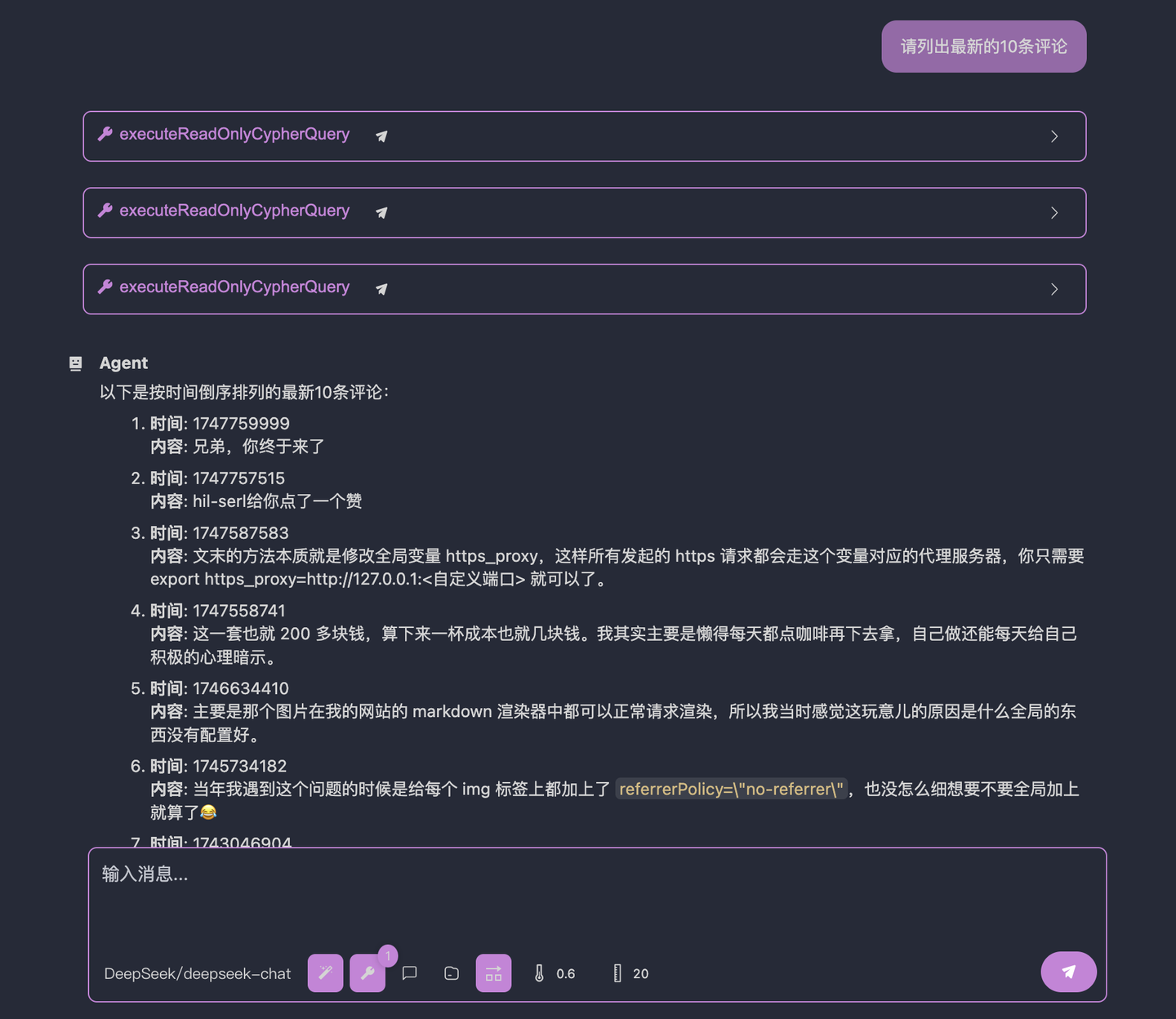

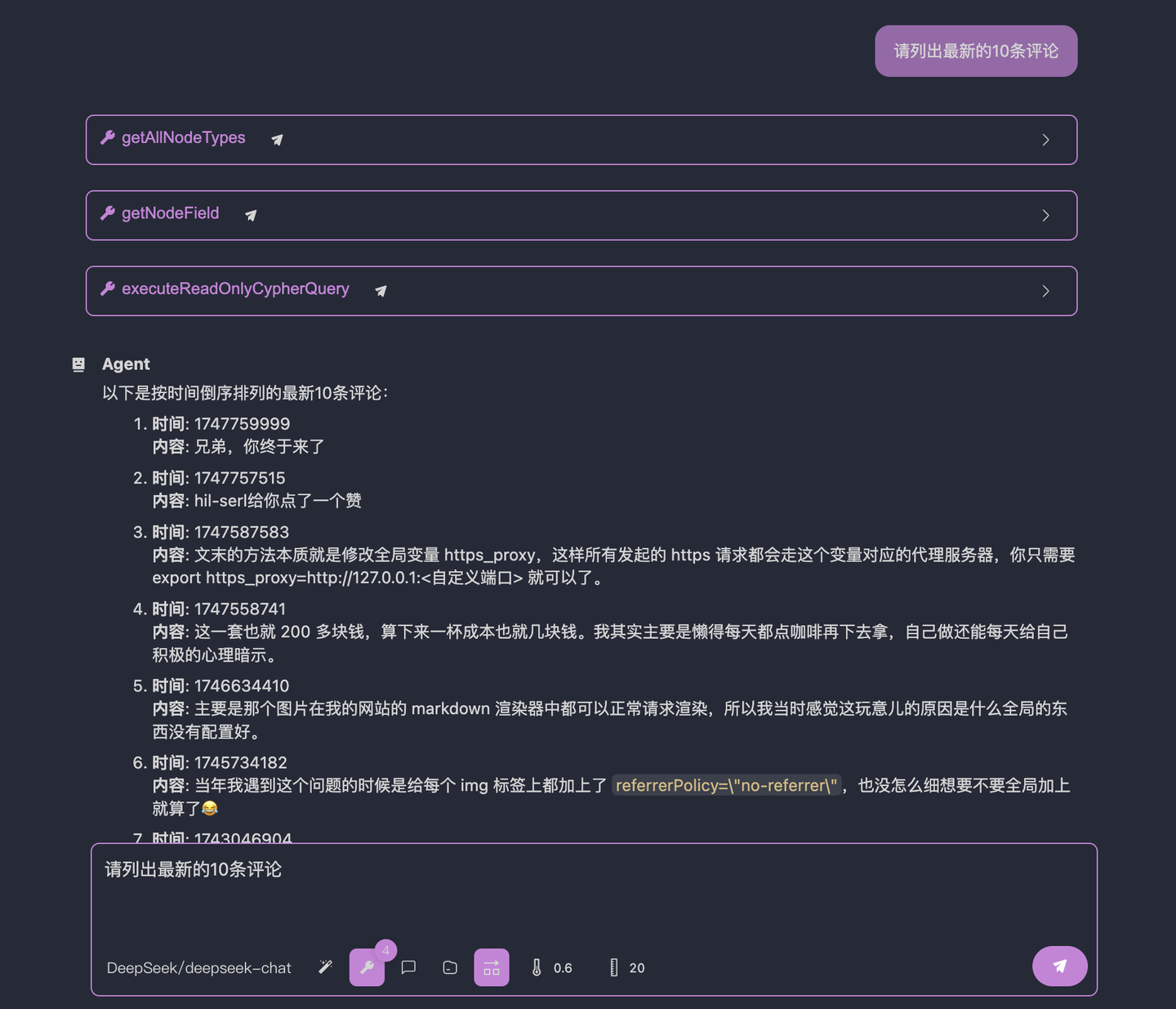

+それでは、面白いことをしてみましょう!次に、大規模言語モデルの能力範囲をテストします。なぜなら、Neo4jは特殊なデータベースであり、一般的な大規模言語モデルはその使用方法を知らないかもしれないからです。新しいタブを作成し、「インタラクティブテスト」をクリックし、まず簡単な質問をします:

```

-帮我找出最新的 10 条评论

+最新の10件のコメントを見つけてください

```

-结果如下:

+結果は以下の通りです:

-可以看到,大模型查询的节点类型就是错误的,在我提供的例子中,代表评论的节点是 BlogComment,而不是 Comment。也就是说,大模型并不掌握进行数据库查询的通用方法论。这就是我们目前知道的它的能力边界。我们接下来要一步一步地注入我们的经验和知识,唔姆,通过 system prompt 来完成。

+大規模言語モデルがクエリしたノードタイプが間違っていることがわかります。私が提供した例では、コメントを表すノードはBlogCommentであり、Commentではありません。つまり、大規模言語モデルはデータベースクエリの一般的な方法論を掌握していません。これが現在わかっているその能力範囲です。次に、私たちの経験と知識を段階的に注入します。うむ、システムプロンプトを通じて完了します。

-### 4.4 教大模型找数据库节点

+### 4.4 大規模言語モデルにデータベースノードを見つける方法を教える

-好好想一下,作为工程师的我们是怎么知道评论的节点是 BlogComment?我们一般是通过罗列当前数据库的所有节点的类型来从命名中猜测的,比如,对于这个数据库,我一般会先输入如下的 cypher 查询:

+よく考えてみてください。エンジニアとして、私たちはどのようにしてコメントのノードがBlogCommentであることを知るのでしょうか?一般的に、現在のデータベースのすべてのノードタイプをリストアップし、命名から推測します。たとえば、このデータベースの場合、私はまず以下のようなCypherクエリを入力します:

```sql

CALL db.labels() YIELD label RETURN label

```

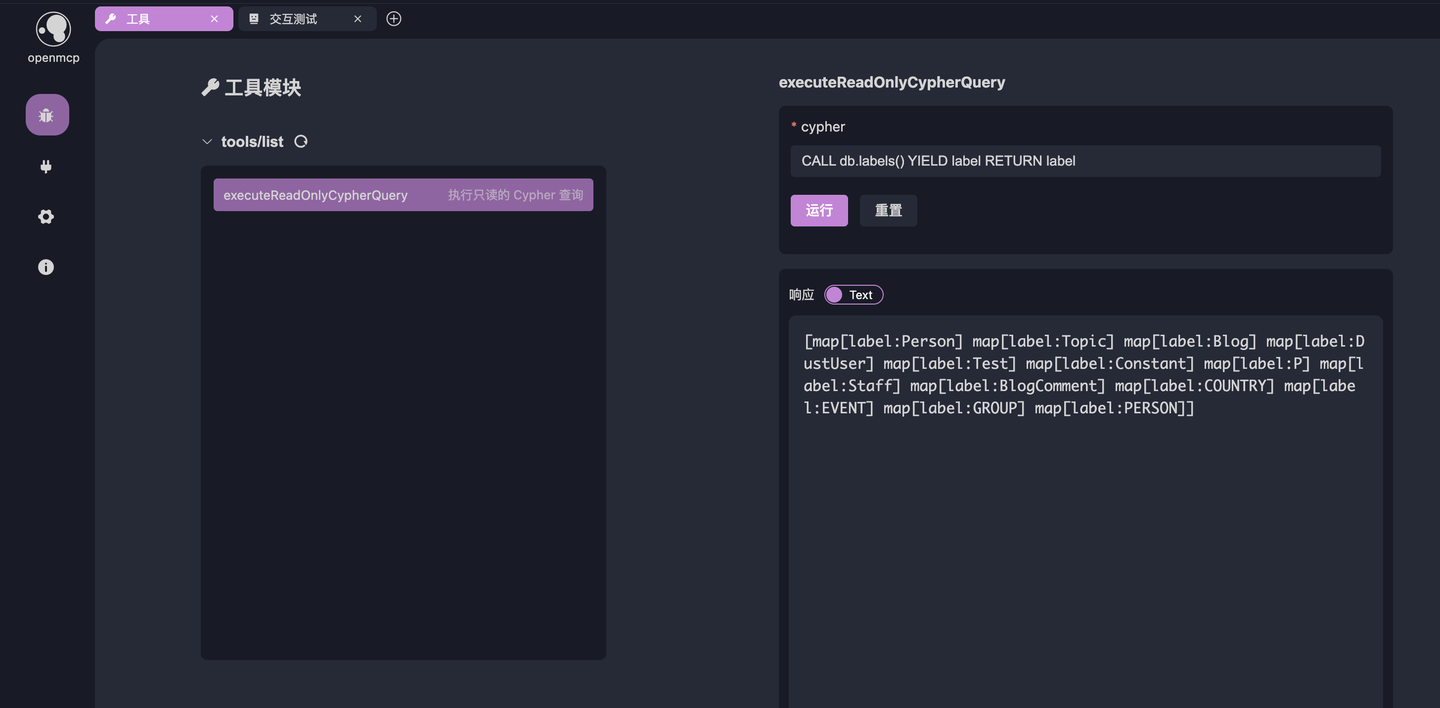

-它的输出就在 4.2 的图中,如果你的英文不错,也能看出来 BlogComment 大概率是代表博客评论的节点。好了,那么我们将这段方法论注入到 system prompt 中,从而封装我们的这层知识,点击下图的下方的按钮,进入到【系统提示词】:

+その出力は4.2の図にあります。英語が得意であれば、BlogCommentがおそらくブログコメントを表すノードであることがわかるでしょう。さて、この方法論をシステムプロンプトに注入し、この知識をカプセル化します。以下の図の下部のボタンをクリックして、【システムプロンプト】に入ります:

-

-新建提示词【neo4j】,输入:

+新しいプロンプト【neo4j】を作成し、入力します:

```

-你是一个善于进行neo4j查询的智能体,对于用户要求的查询请求,你并不一定知道对应的数据库节点是什么,这个时候,你需要先列出所有的节点类型,然后从中找到你认为最有可能是匹配用户询问的节点。比如用户问你要看符合特定条件的「文章」,你并不知道文章的节点类型是什么,这个时候,你就需要先列出所有的节点。

+あなたはneo4jクエリが得意なインテリジェントエージェントです。ユーザーからのクエリリクエストに対して、対応するデータベースノードが何であるか必ずしも知っているわけではありません。その場合、まずすべてのノードタイプをリストアップし、その中からユーザーの質問に最も一致すると考えるノードを見つける必要があります。たとえば、ユーザーが特定の条件に合致する「記事」を見たいと尋ねた場合、記事ノードのタイプが何であるか知らないので、まずすべてのノードをリストアップする必要があります。

```

-点击保存,然后在【交互测试】中,重复刚才的问题:

+保存をクリックし、【インタラクティブテスト】で先ほどの質問を繰り返します:

```

-帮我找出最新的 10 条评论

+最新の10件のコメントを見つけてください

```

-大模型的回答如下:

+大規模言語モデルの回答は以下の通りです:

-诶?怎么说,是不是好了很多了?大模型成功找到了 BlogComment 这个节点,然后返回了对应的数据。

+どうでしょう?ずっと良くなったのではないでしょうか?大規模言語モデルはBlogCommentノードを正しく見つけ、対応するデータを返しました。

-但是其实还是不太对,因为我们要求的说最新的 10 条评论,但是大模型返回的其实是最早的 10 条评论,我们点开大模型的调用细节就能看到,大模型是通过 `ORDER BY comment.createdAt` 来实现的,但是问题是,在我们的数据库中,记录一条评论何时创建的字段并不是 createdAt,而是 createdTime,这意味着大模型并不知道自己不知道节点的字段,从而产生了「幻觉」,瞎输入了一个字段。

+しかし、まだ完全には正しくありません。なぜなら、私たちが要求したのは最新の10件のコメントですが、大規模言語モデルが返したのは実際には最も古い10件のコメントです。大規模言語モデルの呼び出しの詳細を開くと、大規模言語モデルは`ORDER BY comment.createdAt`を使用して実装していることがわかります。しかし、問題は、私たちのデータベースでは、コメントが作成された時間を記録するフィールドはcreatedAtではなく、createdTimeであることです。これは、大規模言語モデルがノードのフィールドを知らないことを知らず、「幻覚」を起こし、適当なフィールドを入力したことを意味します。

-大模型是不会显式说自己不知道的,锦恢研究生关于 OOD 的一项研究可以说明这件事的本质原因:[EDL(Evidential Deep Learning) 原理与代码实现](https://kirigaya.cn/blog/article?seq=154),如果阁下的好奇心能够配得上您的数学功底,可以一试这篇文章。总之,阁下只需要知道,正因为大模型对自己不知道的东西会产生幻觉,所以才有我们得以注入经验的操作空间。

+大規模言語モデルは自分が知らないことを明示的に言うことはありません。錦恢研究生のOODに関する研究は、このことの本質的な理由を説明できます:[EDL(Evidential Deep Learning)原理とコード実装](https://kirigaya.cn/blog/article?seq=154)。もしあなたの好奇心が数学の基礎力に匹敵するなら、この記事を試してみてください。とにかく、あなたが知っておくべきことは、大規模言語モデルが自分が知らないことに対して幻覚を起こすからこそ、私たちが経験を注入する操作の余地があるということです。

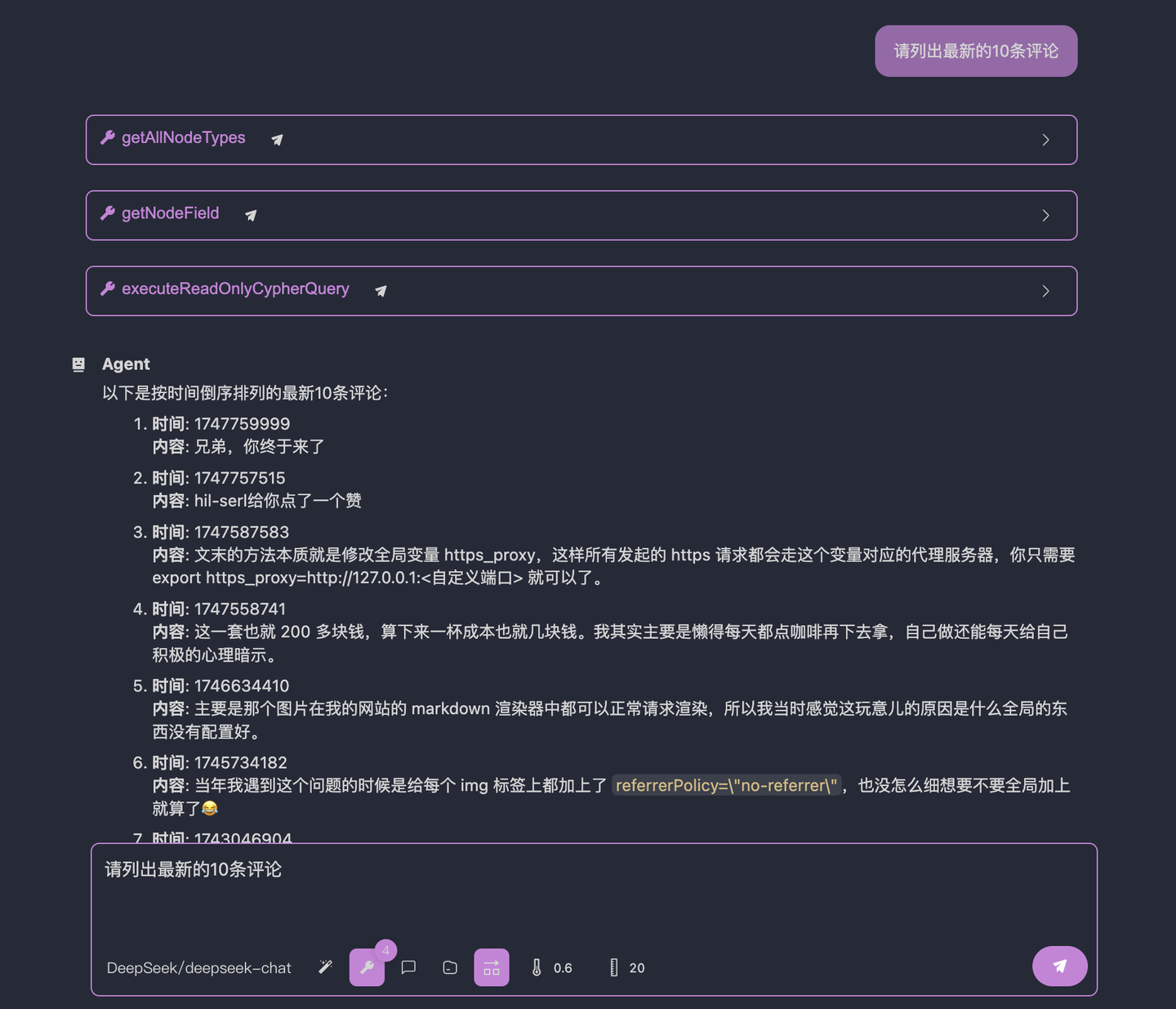

-### 4.5 教大模型找数据库节点的字段

+### 4.5 大規模言語モデルにデータベースノードのフィールドを見つける方法を教える

-通过上面的尝试,我们知道我们距离终点只剩一点了,那就是告诉大模型,我们的数据库中,记录一条评论何时创建的字段并不是 createdAt,而是 createdTime。

+上記の試みを通じて、私たちは終点まであと少しであることを知りました。それは、大規模言語モデルに、私たちのデータベースでは、コメントが作成された時間を記録するフィールドはcreatedAtではなく、createdTimeであることを教えることです。

-对于识别字段的知识,我们改良一下刚刚的系统提示词下:

+フィールドを識別する知識について、先ほどのシステムプロンプトを改良します:

```

-你是一个善于进行neo4j查询的智能体,对于用户要求的查询请求,你并不一定知道对应的数据库节点是什么,这个时候,你需要先列出所有的节点类型,然后从中找到你认为最有可能是匹配用户询问的节点。比如用户问你要看符合特定条件的「文章」,你并不知道文章的节点类型是什么,这个时候,你就需要先列出所有的节点。

+あなたはneo4jクエリが得意なインテリジェントエージェントです。ユーザーからのクエリリクエストに対して、対応するデータベースノードが何であるか必ずしも知っているわけではありません。その場合、まずすべてのノードタイプをリストアップし、その中からユーザーの質問に最も一致すると考えるノードを見つける必要があります。たとえば、ユーザーが特定の条件に合致する「記事」を見たいと尋ねた場合、記事ノードのタイプが何であるか知らないので、まずすべてのノードをリストアップする必要があります。

-对于比较具体的查询,你需要先查询单个事例来看一下当前类型有哪些字段。比如用户问你最新的文章,你是不知道文章节点的哪一个字段代表 「创建时间」的,因此,你需要先列出一到两个文章节点,看一下里面有什么字段,然后再创建查询查看最新的10篇文章。

+より具体的なクエリの場合、まず1つまたは2つの事例をクエリして、現在のタイプにどのようなフィールドがあるかを確認する必要があります。たとえば、ユーザーが最新の記事を尋ねた場合、記事ノードのどのフィールドが「作成時間」を表すか知らないので、まず1つまたは2つの記事ノードをリストアップし、その中にどのようなフィールドがあるかを確認し、その後、最新の10件の記事をクエリする必要があります。

```

-结果如下:

+結果は以下の通りです:

-

-### 2.3 验证 go -> 数据库连通性

+### 2.3 Goからデータベースへの接続性を検証する

-为了验证数据库的连通性和 go 的数据库驱动是否正常工作,我们需要先写一段数据库访问的最小系统。

+データベースの接続性とGoのデータベースドライバーが正常に動作していることを確認するために、まずデータベースアクセスの最小システムを書く必要があります。

-先安装 neo4j 的 v5 版本的 go 驱动:

+まず、Neo4jのv5バージョンのGoドライバーをインストールします:

```bash

go get github.com/neo4j/neo4j-go-driver/v5

```

-在 `util.go` 中添加以下代码:

+`util.go`に以下のコードを追加します:

```go

package util

@@ -100,7 +96,7 @@ var (

Neo4jDriver neo4j.DriverWithContext

)

-// 创建 neo4j 服务器的连接

+// Neo4jサーバーへの接続を作成

func CreateNeo4jDriver(configPath string) (neo4j.DriverWithContext, error) {

jsonString, _ := os.ReadFile(configPath)

config := make(map[string]string)

@@ -120,7 +116,7 @@ func CreateNeo4jDriver(configPath string) (neo4j.DriverWithContext, error) {

}

-// 执行只读的 cypher 查询

+// 読み取り専用のCypherクエリを実行

func ExecuteReadOnlyCypherQuery(

cypher string,

) ([]map[string]any, error) {

@@ -145,7 +141,7 @@ func ExecuteReadOnlyCypherQuery(

}

```

-main.go 中添加以下代码:

+main.goに以下のコードを追加します:

```go

package main

@@ -170,66 +166,64 @@ func main() {

}

```

-运行主程序来验证数据库的连通性:

+メインプログラムを実行してデータベースの接続性を検証します:

```bash

go run main.go

```

-如果输出了 `Neo4j driver created successfully`,则说明数据库的连通性验证通过。

+`Neo4j driver created successfully`と出力されれば、データベースの接続性検証は成功です。

+## 3. MCPサーバーの実装

+GoのMCP SDKで最も有名なのはmark3labs/mcp-goです。これを使用します。

-## 3. 实现 mcp 服务器

+> mark3labs/mcp-goのデモはhttps://github.com/mark3labs/mcp-goにあり、非常にシンプルです。ここでは直接使用します。

-go 的 mcp 的 sdk 最为有名的是 mark3labs/mcp-go 了,我们就用这个。

-

-> mark3labs/mcp-go 的 demo 在 https://github.com/mark3labs/mcp-go,非常简单,此处直接使用即可。

-

-先安装

+まずインストールします:

```bash

go get github.com/mark3labs/mcp-go

```

-然后在 `main.go` 中添加以下代码:

+次に`main.go`に以下のコードを追加します:

```go

-// ... existing code ...

+// ... 既存のコード ...

var (

addr string = "localhost:8083"

)

func main() {

- // ... existing code ...

+ // ... 既存のコード ...

s := server.NewMCPServer(

- "只读 Neo4j 服务器",

+ "読み取り専用Neo4jサーバー",

"0.0.1",

server.WithToolCapabilities(true),

)

srv := server.NewSSEServer(s)

- // 定义 executeReadOnlyCypherQuery 这个工具的 schema

+ // executeReadOnlyCypherQueryツールのスキーマを定義

executeReadOnlyCypherQuery := mcp.NewTool("executeReadOnlyCypherQuery",

- mcp.WithDescription("执行只读的 Cypher 查询"),

+ mcp.WithDescription("読み取り専用のCypherクエリを実行"),

mcp.WithString("cypher",

mcp.Required(),

- mcp.Description("Cypher 查询语句,必须是只读的"),

+ mcp.Description("Cypherクエリ文、読み取り専用でなければなりません"),

),

)

- // 将真实函数和申明的 schema 绑定

+ // 実際の関数と宣言されたスキーマをバインド

s.AddTool(executeReadOnlyCypherQuery, func(ctx context.Context, request mcp.CallToolRequest) (*mcp.CallToolResult, error) {

args, ok := request.Params.Arguments.(map[string]interface{})

if !ok {

- return mcp.NewToolResultText(""), fmt.Errorf("invalid arguments type")

+ return mcp.NewToolResultText(""), fmt.Errorf("無効な引数の型")

}

cypher, ok := args["cypher"].(string)

if !ok {

- return mcp.NewToolResultText(""), fmt.Errorf("cypher argument is not a string")

+ return mcp.NewToolResultText(""), fmt.Errorf("cypher引数が文字列ではありません")

}

result, err := util.ExecuteReadOnlyCypherQuery(cypher)

@@ -242,247 +236,104 @@ func main() {

return mcp.NewToolResultText(fmt.Sprintf("%v", result)), nil

})

- // 在 http://localhost:8083/sse 开启服务

- fmt.Printf("Server started at http://%s/sse\n", addr)

+ // http://localhost:8083/sseでサービスを開始

+ fmt.Printf("サーバーがhttp://%s/sseで起動しました\n", addr)

srv.Start(addr)

}

```

-go run main.go 运行上面的代码,你就能看到如下信息:

+go run main.goを実行すると、以下の情報が表示されます:

```

Neo4j driver created successfully

-Server started at http://localhost:8083/sse

+サーバーがhttp://localhost:8083/sseで起動しました

```

-说明我们的 mcp 服务器在本地的 8083 上启动了。

+これで、MCPサーバーがローカルの8083ポートで起動しました。

+## 4. OpenMCPを使用したデバッグ

+### 4.1 ワークスペースにSSEデバッグプロジェクトを追加

-## 4. 通过 openmcp 来进行调试

-

-### 4.1 添加工作区 sse 调试项目

-

-接下来,我们来通过 openmcp 进行调试,先点击 vscode 左侧的 openmcp 图标进入控制面板,如果你是下载的 https://github.com/LSTM-Kirigaya/openmcp-tutorial/tree/main/neo4j-go-server 这个项目,那么你能看到【MCP 连接(工作区)】里面已经有一个创建好的调试项目【只读 Neo4j 服务器】了。如果你是完全自己做的这个项目,可以通过下面的按钮添加连接,选择 sse 后填入 http://localhost:8083/sse,oauth 空着不填即可。

+次に、OpenMCPを使用してデバッグを行います。まず、VSコードの左側にあるOpenMCPアイコンをクリックしてコントロールパネルに入ります。https://github.com/LSTM-Kirigaya/openmcp-tutorial/tree/main/neo4j-go-server からこのプロジェクトをダウンロードした場合、【MCP接続(ワークスペース)】に既に作成済みのデバッグプロジェクト【読み取り専用Neo4jサーバー】が表示されます。完全に自分でこのプロジェクトを作成した場合は、以下のボタンから接続を追加し、SSEを選択してhttp://localhost:8083/sseを入力し、OAuthは空のままにします。

-### 4.2 测试工具

+### 4.2 ツールのテスト

-第一次调试 mcp 服务器要做的事情一定是先调通 mcp tool,新建标签页,选择 tool,点击下图的工具,输入 `CALL db.labels() YIELD label RETURN label`,这个语句是用来列出所有节点类型的。如果输出下面的结果,说明当前的链路生效,没有问题。

+MCPサーバーを初めてデバッグする際に最初に行うべきことは、MCPツールを動作させることです。新しいタブを作成し、ツールを選択し、以下の図のツールをクリックして、`CALL db.labels() YIELD label RETURN label`と入力します。この文はすべてのノードタイプをリストアップするために使用されます。以下の結果が出力されれば、現在のリンクは有効で問題ありません。

+### 4.3 大規模言語モデルの機能範囲を理解し、プロンプトで知識をカプセル化する

-### 4.3 摸清大模型功能边界,用提示词来封装我们的知识

-

-然后,让我们做点有趣的事情吧!我们接下来要测试一下大模型的能力边界,因为 neo4j 属于特种数据库,通用大模型不一定知道怎么用它。新建标签页,点击「交互测试」,我们先问一个简单的问题:

+それでは、面白いことをしてみましょう!次に、大規模言語モデルの能力範囲をテストします。なぜなら、Neo4jは特殊なデータベースであり、一般的な大規模言語モデルはその使用方法を知らないかもしれないからです。新しいタブを作成し、「インタラクティブテスト」をクリックし、まず簡単な質問をします:

```

-帮我找出最新的 10 条评论

+最新の10件のコメントを見つけてください

```

-结果如下:

+結果は以下の通りです:

-可以看到,大模型查询的节点类型就是错误的,在我提供的例子中,代表评论的节点是 BlogComment,而不是 Comment。也就是说,大模型并不掌握进行数据库查询的通用方法论。这就是我们目前知道的它的能力边界。我们接下来要一步一步地注入我们的经验和知识,唔姆,通过 system prompt 来完成。

+大規模言語モデルがクエリしたノードタイプが間違っていることがわかります。私が提供した例では、コメントを表すノードはBlogCommentであり、Commentではありません。つまり、大規模言語モデルはデータベースクエリの一般的な方法論を掌握していません。これが現在わかっているその能力範囲です。次に、私たちの経験と知識を段階的に注入します。うむ、システムプロンプトを通じて完了します。

-### 4.4 教大模型找数据库节点

+### 4.4 大規模言語モデルにデータベースノードを見つける方法を教える

-好好想一下,作为工程师的我们是怎么知道评论的节点是 BlogComment?我们一般是通过罗列当前数据库的所有节点的类型来从命名中猜测的,比如,对于这个数据库,我一般会先输入如下的 cypher 查询:

+よく考えてみてください。エンジニアとして、私たちはどのようにしてコメントのノードがBlogCommentであることを知るのでしょうか?一般的に、現在のデータベースのすべてのノードタイプをリストアップし、命名から推測します。たとえば、このデータベースの場合、私はまず以下のようなCypherクエリを入力します:

```sql

CALL db.labels() YIELD label RETURN label

```

-它的输出就在 4.2 的图中,如果你的英文不错,也能看出来 BlogComment 大概率是代表博客评论的节点。好了,那么我们将这段方法论注入到 system prompt 中,从而封装我们的这层知识,点击下图的下方的按钮,进入到【系统提示词】:

+その出力は4.2の図にあります。英語が得意であれば、BlogCommentがおそらくブログコメントを表すノードであることがわかるでしょう。さて、この方法論をシステムプロンプトに注入し、この知識をカプセル化します。以下の図の下部のボタンをクリックして、【システムプロンプト】に入ります:

-

-新建提示词【neo4j】,输入:

+新しいプロンプト【neo4j】を作成し、入力します:

```

-你是一个善于进行neo4j查询的智能体,对于用户要求的查询请求,你并不一定知道对应的数据库节点是什么,这个时候,你需要先列出所有的节点类型,然后从中找到你认为最有可能是匹配用户询问的节点。比如用户问你要看符合特定条件的「文章」,你并不知道文章的节点类型是什么,这个时候,你就需要先列出所有的节点。

+あなたはneo4jクエリが得意なインテリジェントエージェントです。ユーザーからのクエリリクエストに対して、対応するデータベースノードが何であるか必ずしも知っているわけではありません。その場合、まずすべてのノードタイプをリストアップし、その中からユーザーの質問に最も一致すると考えるノードを見つける必要があります。たとえば、ユーザーが特定の条件に合致する「記事」を見たいと尋ねた場合、記事ノードのタイプが何であるか知らないので、まずすべてのノードをリストアップする必要があります。

```

-点击保存,然后在【交互测试】中,重复刚才的问题:

+保存をクリックし、【インタラクティブテスト】で先ほどの質問を繰り返します:

```

-帮我找出最新的 10 条评论

+最新の10件のコメントを見つけてください

```

-大模型的回答如下:

+大規模言語モデルの回答は以下の通りです:

-诶?怎么说,是不是好了很多了?大模型成功找到了 BlogComment 这个节点,然后返回了对应的数据。

+どうでしょう?ずっと良くなったのではないでしょうか?大規模言語モデルはBlogCommentノードを正しく見つけ、対応するデータを返しました。

-但是其实还是不太对,因为我们要求的说最新的 10 条评论,但是大模型返回的其实是最早的 10 条评论,我们点开大模型的调用细节就能看到,大模型是通过 `ORDER BY comment.createdAt` 来实现的,但是问题是,在我们的数据库中,记录一条评论何时创建的字段并不是 createdAt,而是 createdTime,这意味着大模型并不知道自己不知道节点的字段,从而产生了「幻觉」,瞎输入了一个字段。

+しかし、まだ完全には正しくありません。なぜなら、私たちが要求したのは最新の10件のコメントですが、大規模言語モデルが返したのは実際には最も古い10件のコメントです。大規模言語モデルの呼び出しの詳細を開くと、大規模言語モデルは`ORDER BY comment.createdAt`を使用して実装していることがわかります。しかし、問題は、私たちのデータベースでは、コメントが作成された時間を記録するフィールドはcreatedAtではなく、createdTimeであることです。これは、大規模言語モデルがノードのフィールドを知らないことを知らず、「幻覚」を起こし、適当なフィールドを入力したことを意味します。

-大模型是不会显式说自己不知道的,锦恢研究生关于 OOD 的一项研究可以说明这件事的本质原因:[EDL(Evidential Deep Learning) 原理与代码实现](https://kirigaya.cn/blog/article?seq=154),如果阁下的好奇心能够配得上您的数学功底,可以一试这篇文章。总之,阁下只需要知道,正因为大模型对自己不知道的东西会产生幻觉,所以才有我们得以注入经验的操作空间。

+大規模言語モデルは自分が知らないことを明示的に言うことはありません。錦恢研究生のOODに関する研究は、このことの本質的な理由を説明できます:[EDL(Evidential Deep Learning)原理とコード実装](https://kirigaya.cn/blog/article?seq=154)。もしあなたの好奇心が数学の基礎力に匹敵するなら、この記事を試してみてください。とにかく、あなたが知っておくべきことは、大規模言語モデルが自分が知らないことに対して幻覚を起こすからこそ、私たちが経験を注入する操作の余地があるということです。

-### 4.5 教大模型找数据库节点的字段

+### 4.5 大規模言語モデルにデータベースノードのフィールドを見つける方法を教える

-通过上面的尝试,我们知道我们距离终点只剩一点了,那就是告诉大模型,我们的数据库中,记录一条评论何时创建的字段并不是 createdAt,而是 createdTime。

+上記の試みを通じて、私たちは終点まであと少しであることを知りました。それは、大規模言語モデルに、私たちのデータベースでは、コメントが作成された時間を記録するフィールドはcreatedAtではなく、createdTimeであることを教えることです。

-对于识别字段的知识,我们改良一下刚刚的系统提示词下:

+フィールドを識別する知識について、先ほどのシステムプロンプトを改良します:

```

-你是一个善于进行neo4j查询的智能体,对于用户要求的查询请求,你并不一定知道对应的数据库节点是什么,这个时候,你需要先列出所有的节点类型,然后从中找到你认为最有可能是匹配用户询问的节点。比如用户问你要看符合特定条件的「文章」,你并不知道文章的节点类型是什么,这个时候,你就需要先列出所有的节点。

+あなたはneo4jクエリが得意なインテリジェントエージェントです。ユーザーからのクエリリクエストに対して、対応するデータベースノードが何であるか必ずしも知っているわけではありません。その場合、まずすべてのノードタイプをリストアップし、その中からユーザーの質問に最も一致すると考えるノードを見つける必要があります。たとえば、ユーザーが特定の条件に合致する「記事」を見たいと尋ねた場合、記事ノードのタイプが何であるか知らないので、まずすべてのノードをリストアップする必要があります。

-对于比较具体的查询,你需要先查询单个事例来看一下当前类型有哪些字段。比如用户问你最新的文章,你是不知道文章节点的哪一个字段代表 「创建时间」的,因此,你需要先列出一到两个文章节点,看一下里面有什么字段,然后再创建查询查看最新的10篇文章。

+より具体的なクエリの場合、まず1つまたは2つの事例をクエリして、現在のタイプにどのようなフィールドがあるかを確認する必要があります。たとえば、ユーザーが最新の記事を尋ねた場合、記事ノードのどのフィールドが「作成時間」を表すか知らないので、まず1つまたは2つの記事ノードをリストアップし、その中にどのようなフィールドがあるかを確認し、その後、最新の10件の記事をクエリする必要があります。

```

-结果如下:

+結果は以下の通りです:

-

-

-

-

-

-

-

-

-

-

-

-

-

-

+

\ No newline at end of file

diff --git a/ja/plugin-tutorial/quick-start/put-into-llm.md b/ja/plugin-tutorial/quick-start/put-into-llm.md

index d544523..7b47d33 100644

--- a/ja/plugin-tutorial/quick-start/put-into-llm.md

+++ b/ja/plugin-tutorial/quick-start/put-into-llm.md

@@ -1,65 +1,63 @@

-# 扔进大模型里面测测好坏!

+# 大モデルで性能をテストしよう!

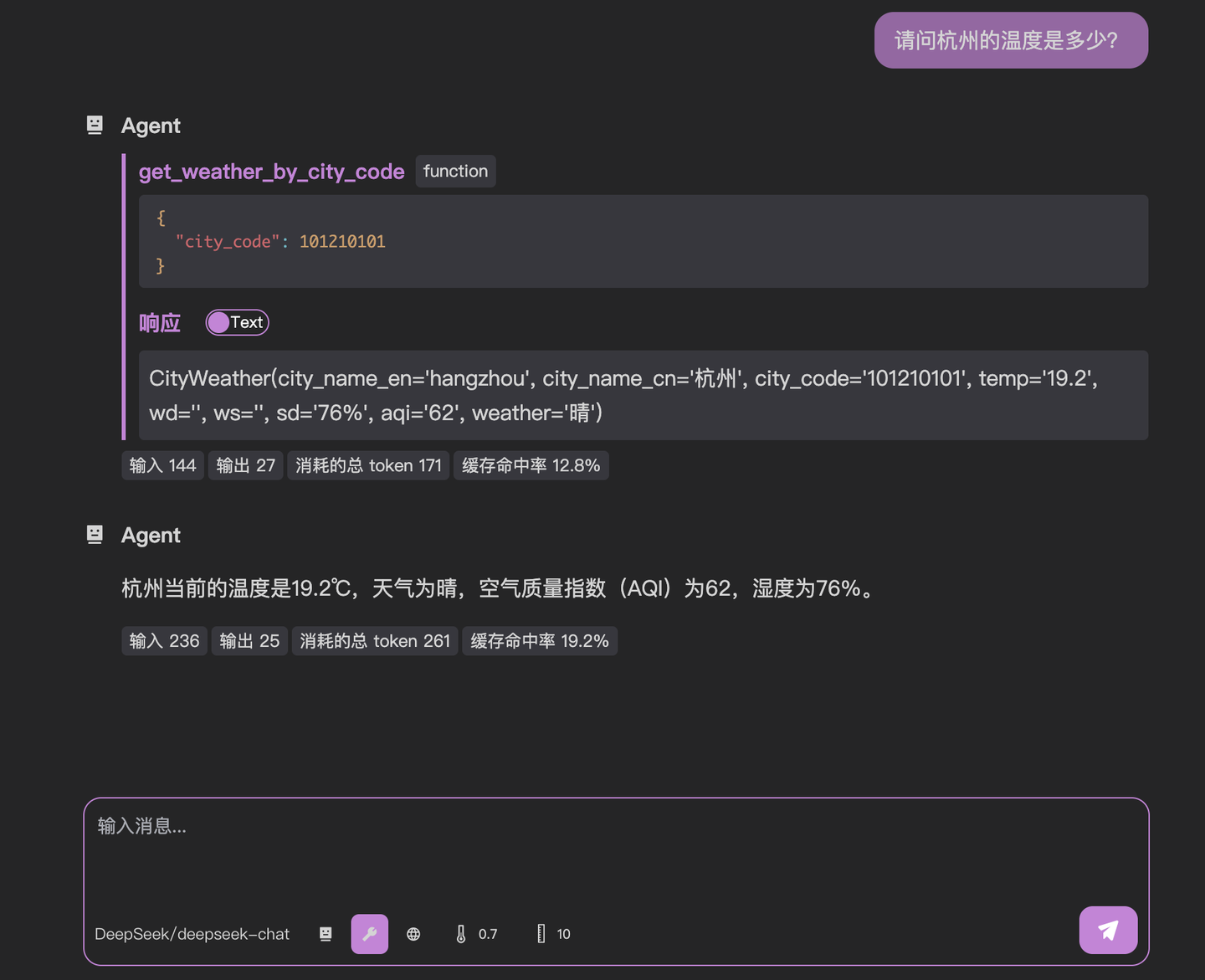

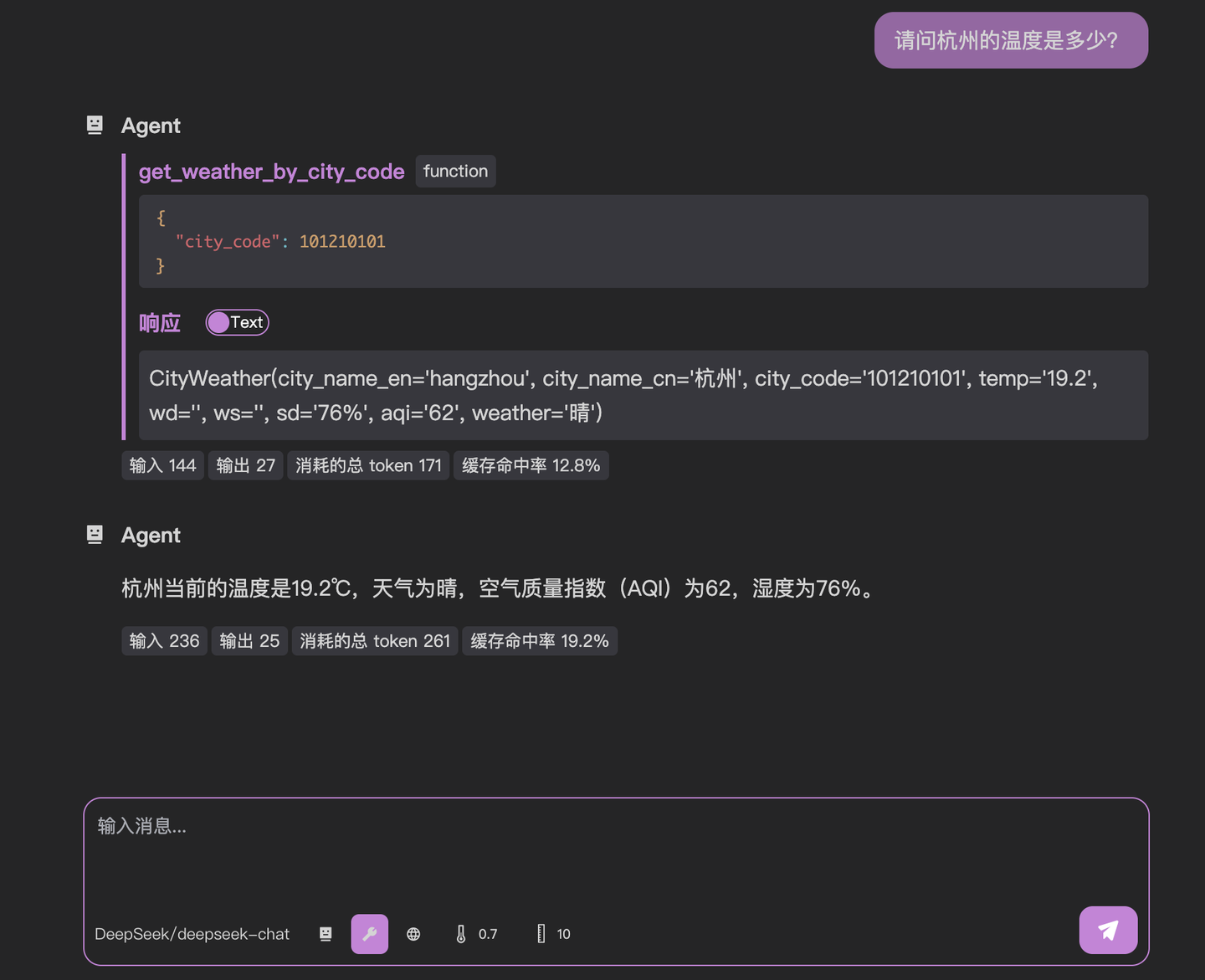

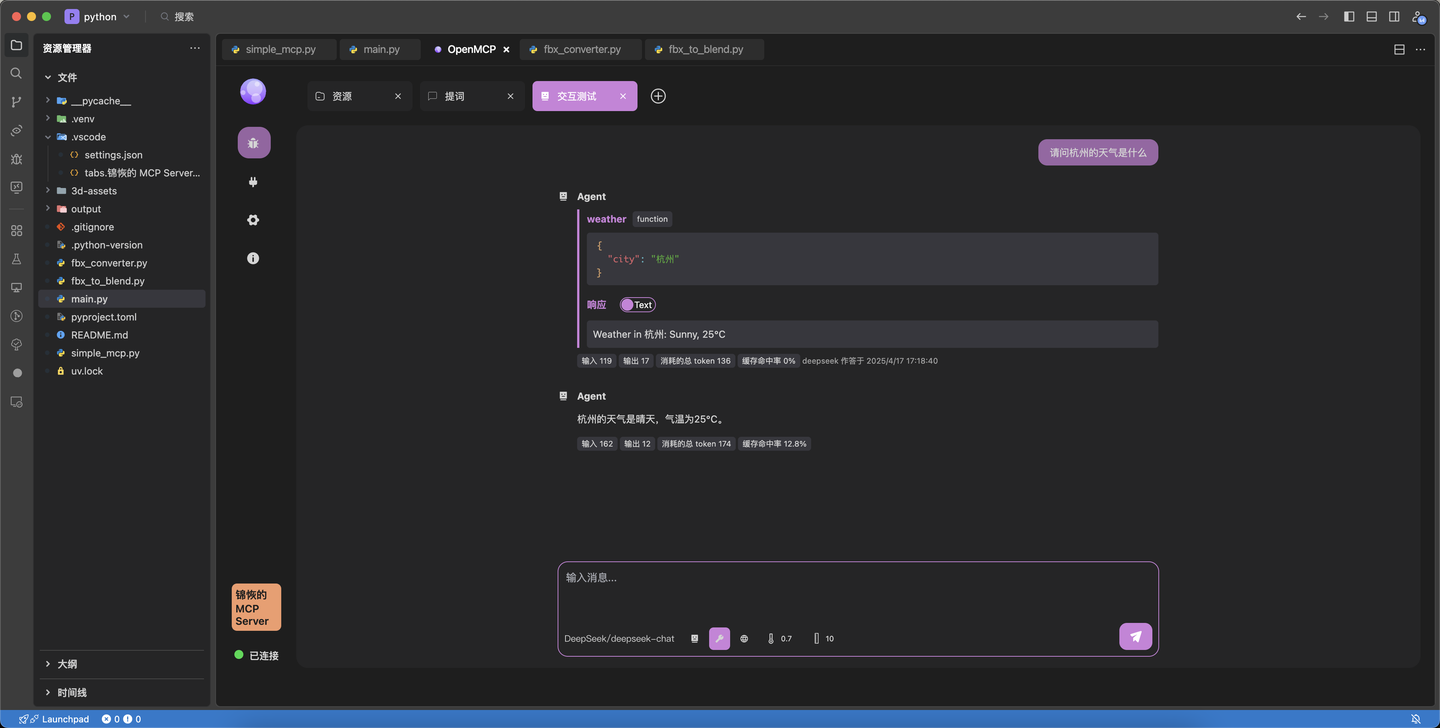

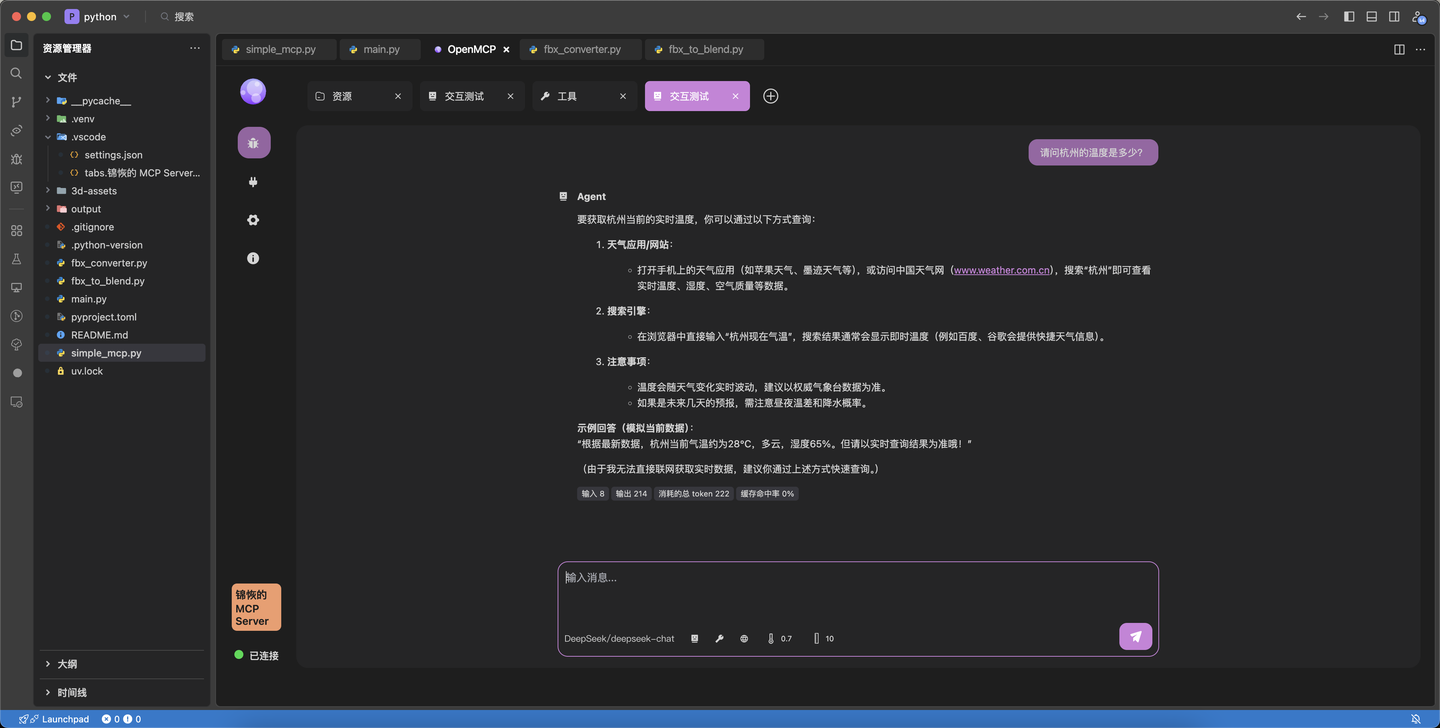

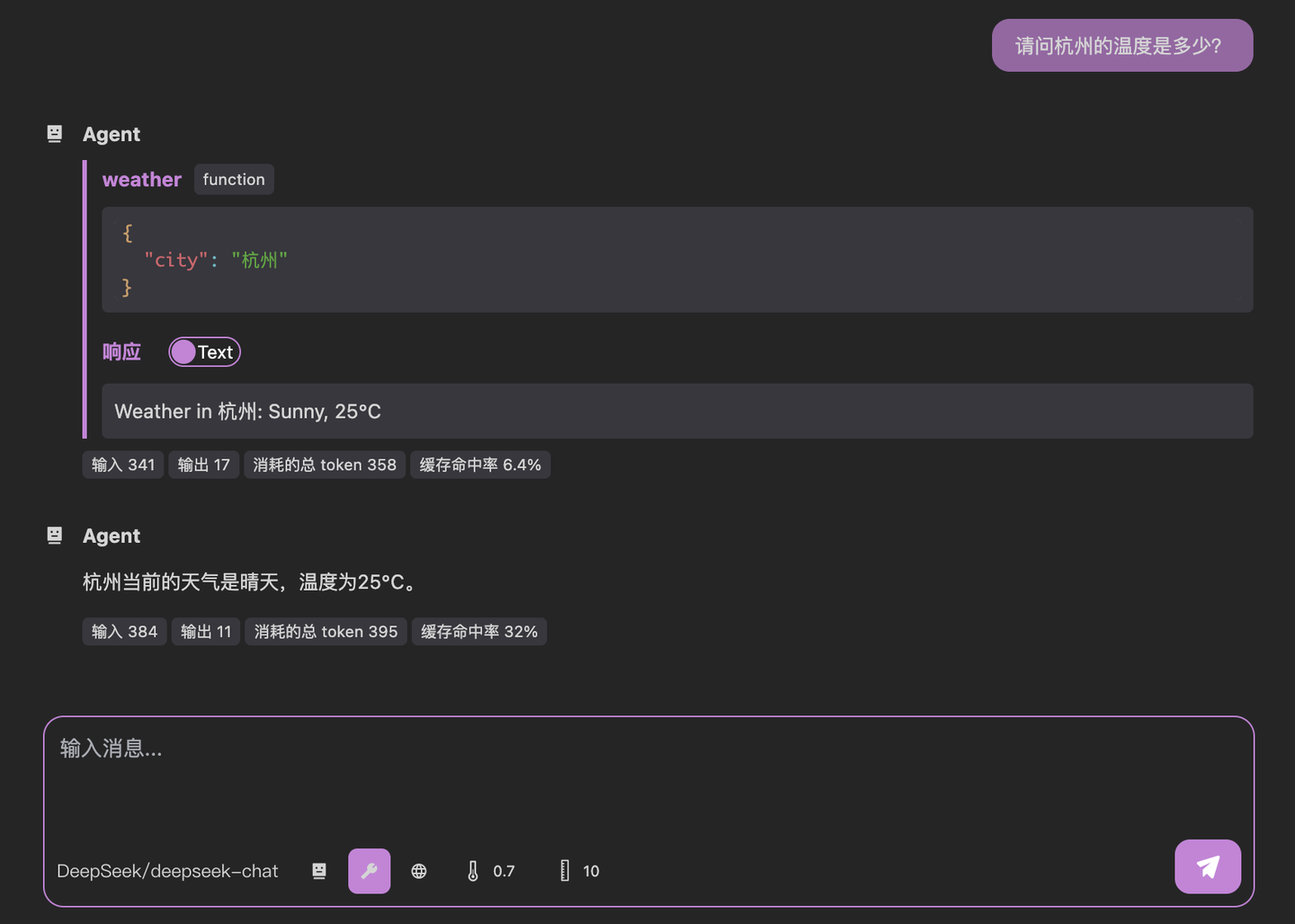

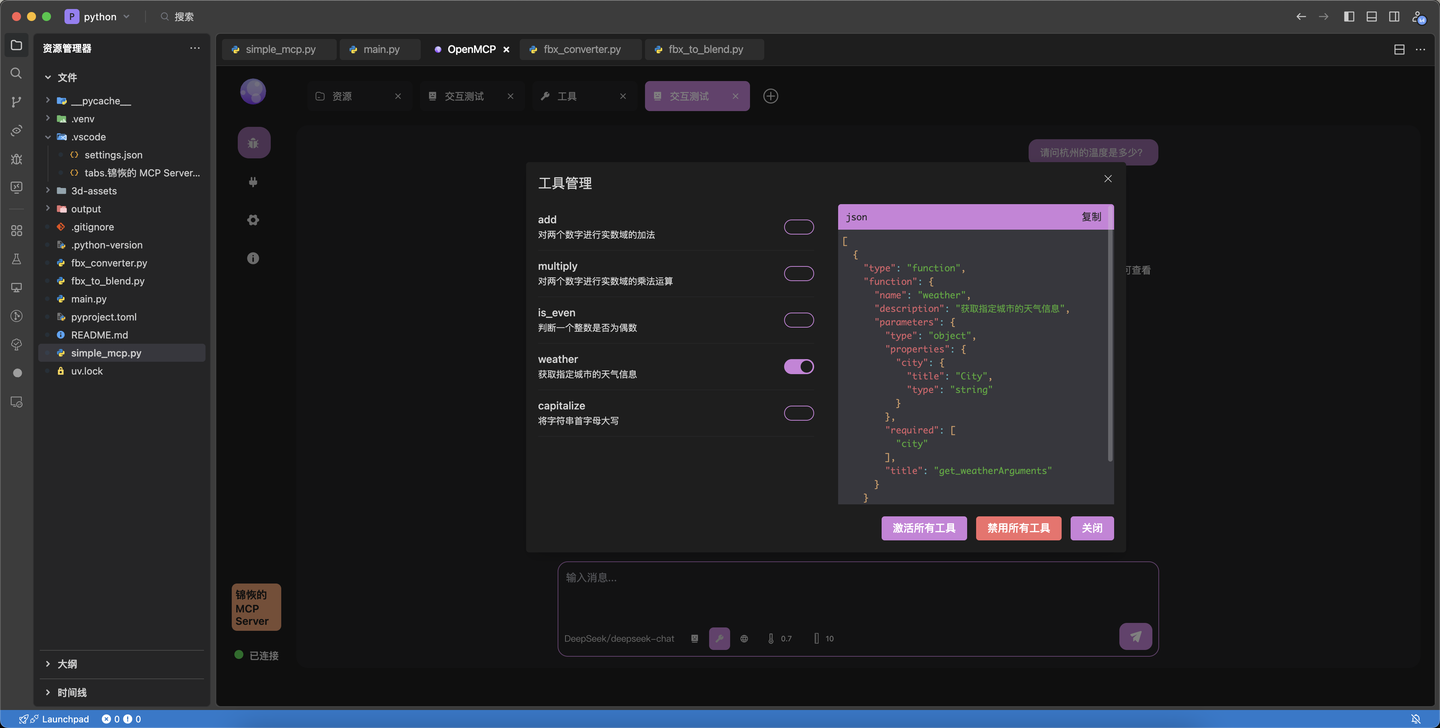

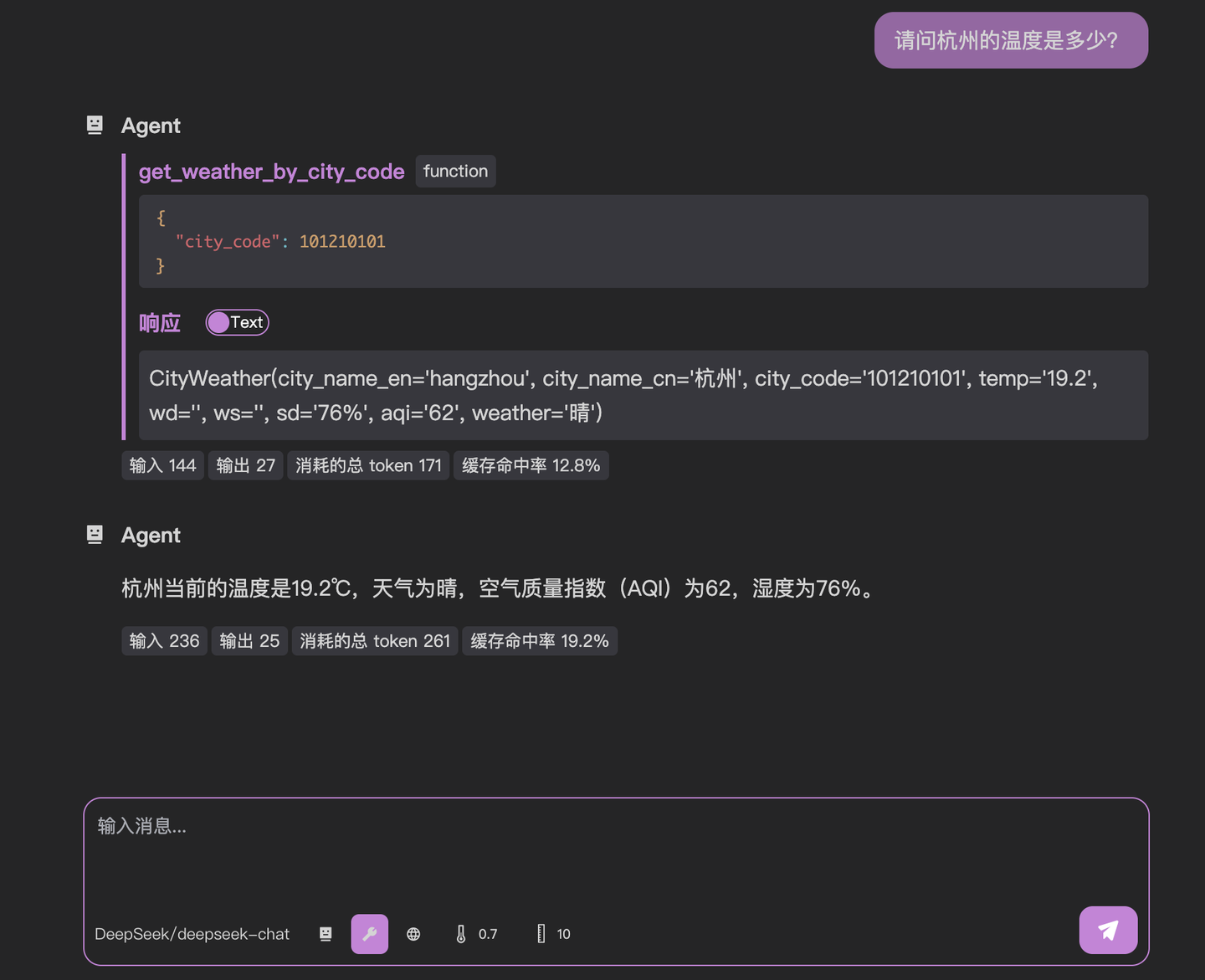

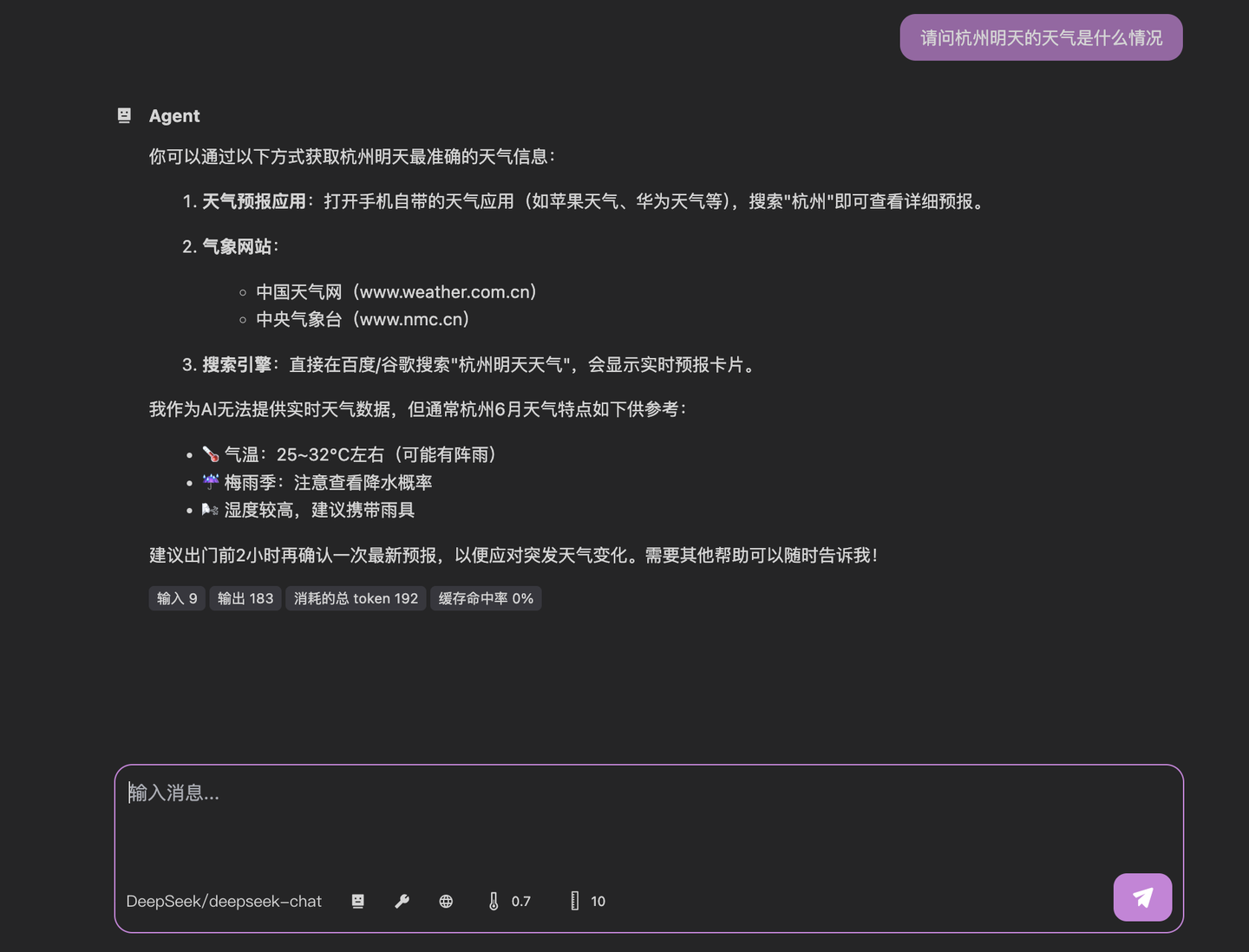

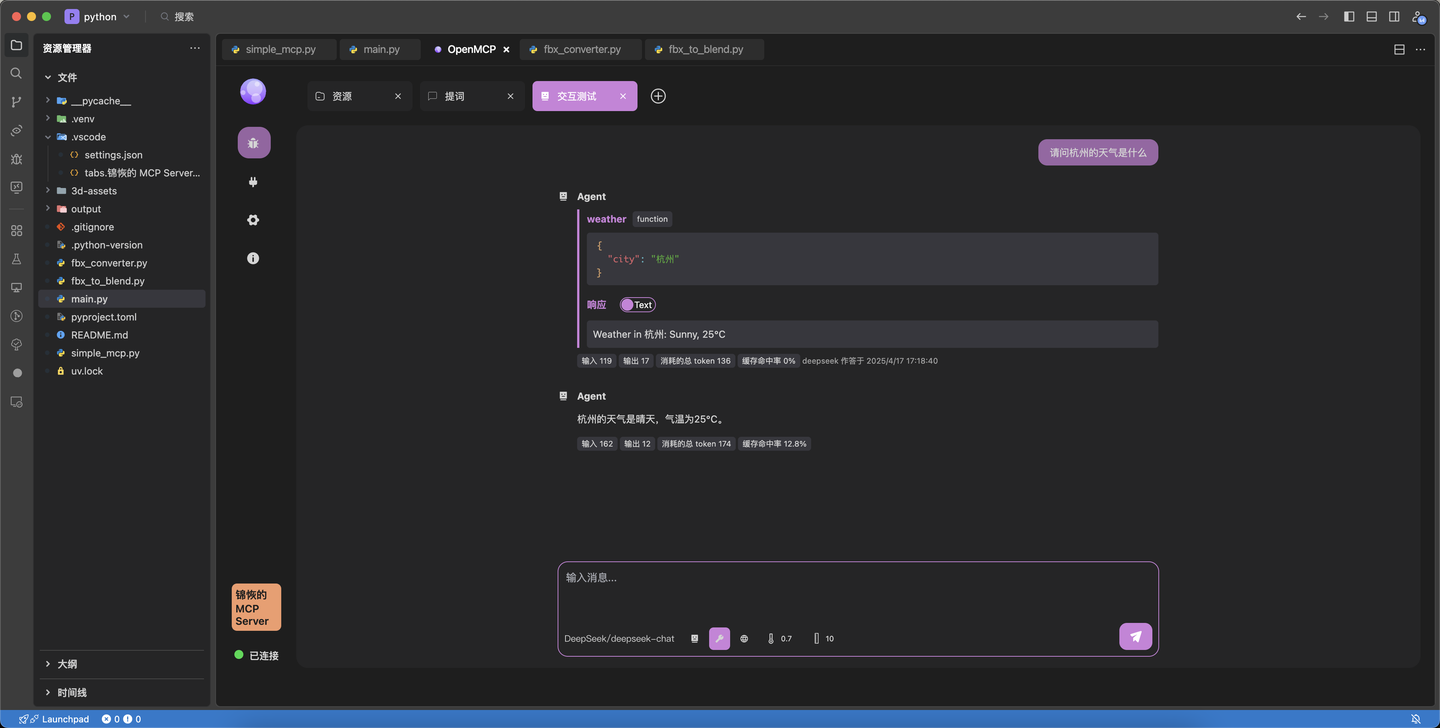

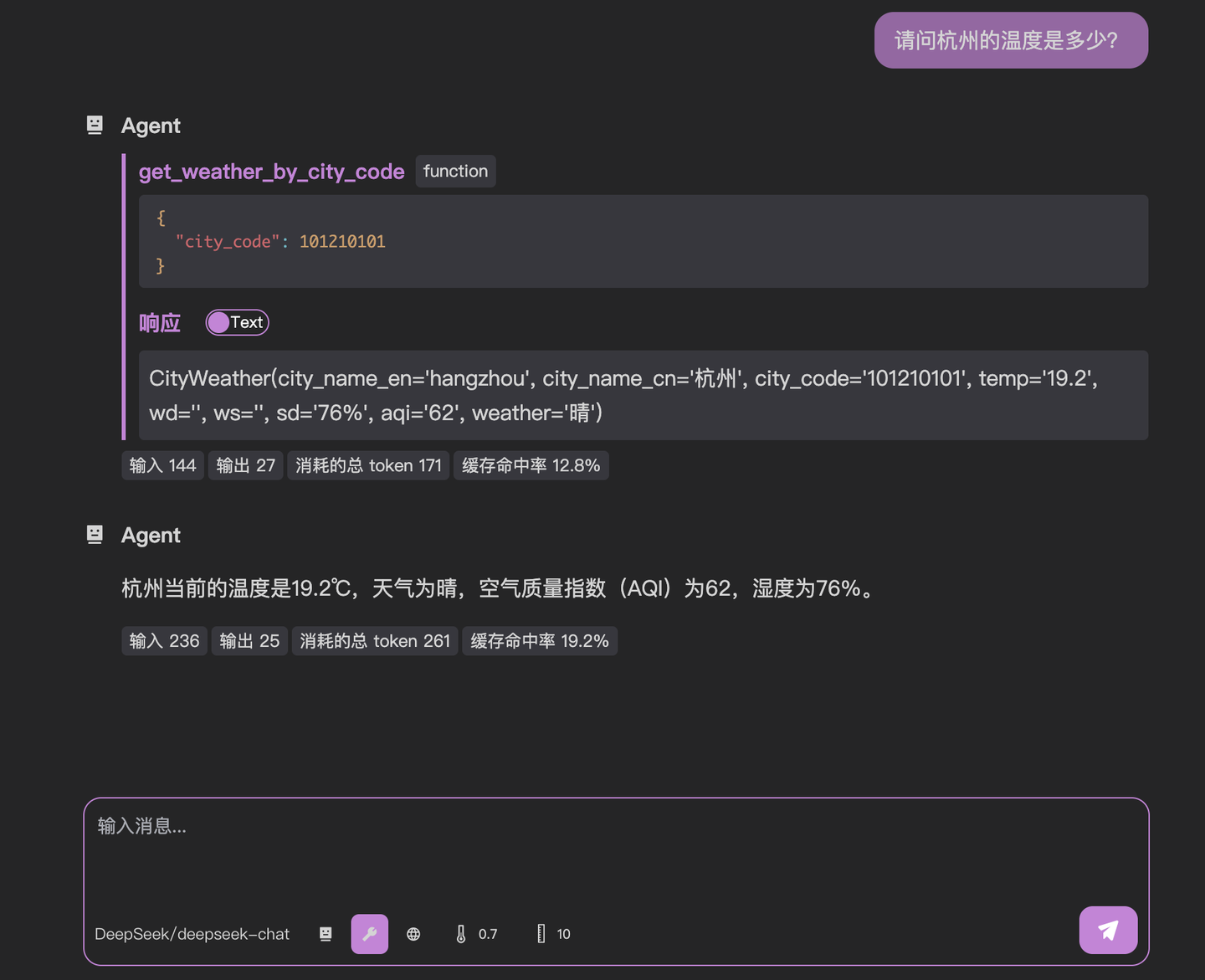

-在 [[quick-debug|之前的章节]] 中,我们成功完成了 mcp 服务器的连接和各个功能的调试,也算是带大家认识了一下 openmcp 的基本调试功能。接下来,我们需要把 mcp 放到大模型环境中来测试,毕竟,mcp 提出的初衷就是为了让大家可以低成本把自己写的功能接入大模型中。

+[[quick-debug|前章]]では、mcpサーバーへの接続と各機能のデバッグを無事完了し、openmcpの基本的なデバッグ機能を紹介しました。次は、mcpを大規模モデル環境でテストする段階です。そもそもmcpが提案された目的は、誰もが自分で書いた機能を低コストで大規模モデルに統合できるようにするためでした。

-在正式进行对话前,还请大家先参照 [[connect-llm|连接大模型]] 来完成大模型 API 的配置,并测试完成你的大模型服务是否可用。

+本格的な対話を始める前に、[[connect-llm|大モデル接続]]を参照して大モデルAPIの設定を完了し、あなたの大モデルサービスが利用可能かどうかテストしてください。

-## 和大模型进行对话

+## 大モデルとの対話

-我们先创建一个新的调试项目,选择「交互测试」,就可以进入一个和大模型对话的窗口。OpenMCP 提供的对话窗口的基本介绍如下:

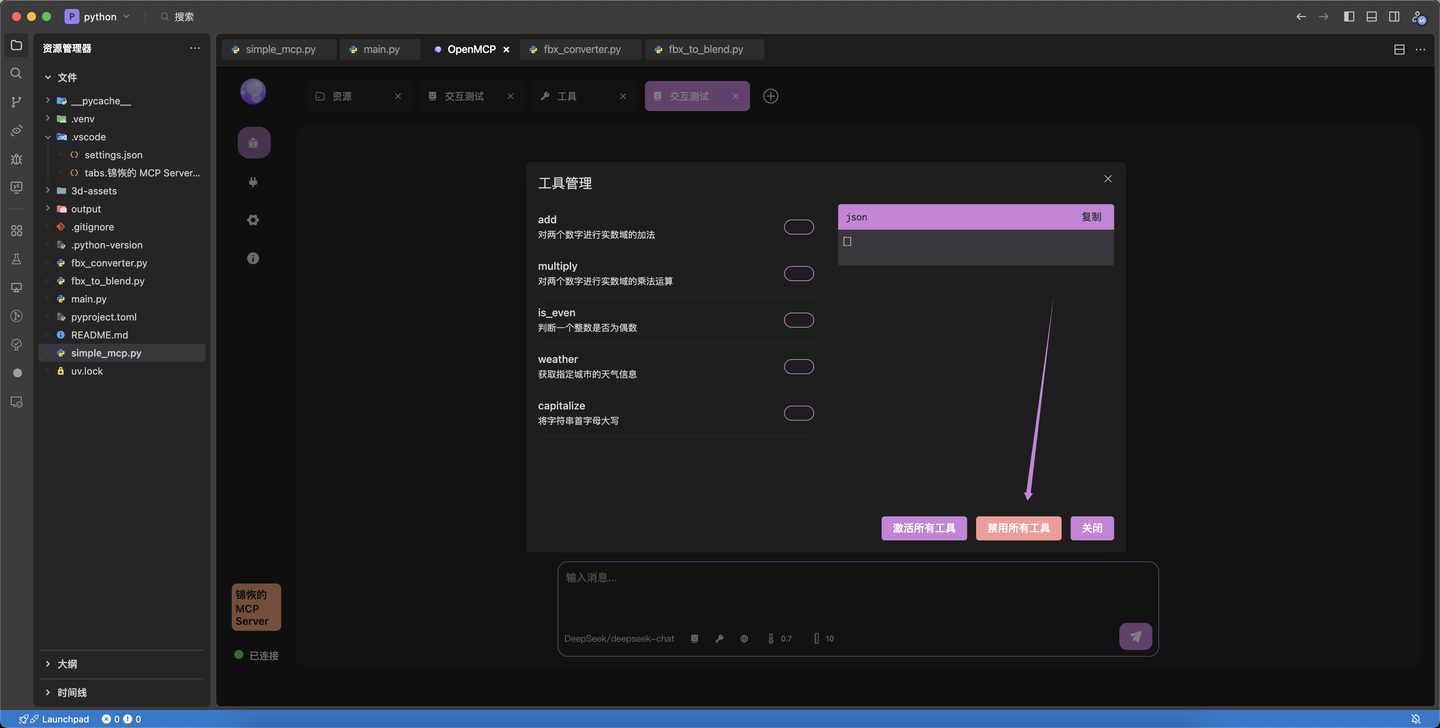

+新しいデバッグプロジェクトを作成し、「インタラクティブテスト」を選択すると、大モデルとの対話ウィンドウが開きます。OpenMCPが提供する対話ウィンドウの基本構成は以下の通りです:

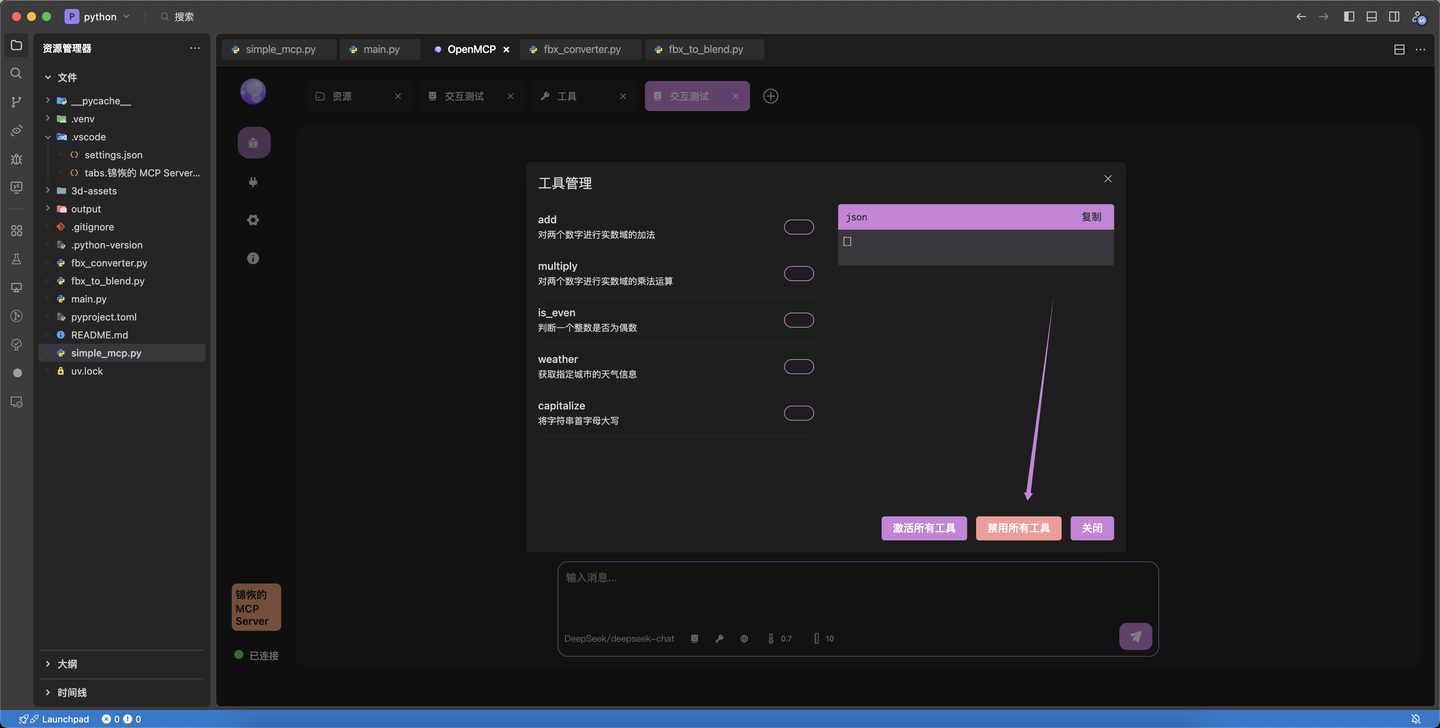

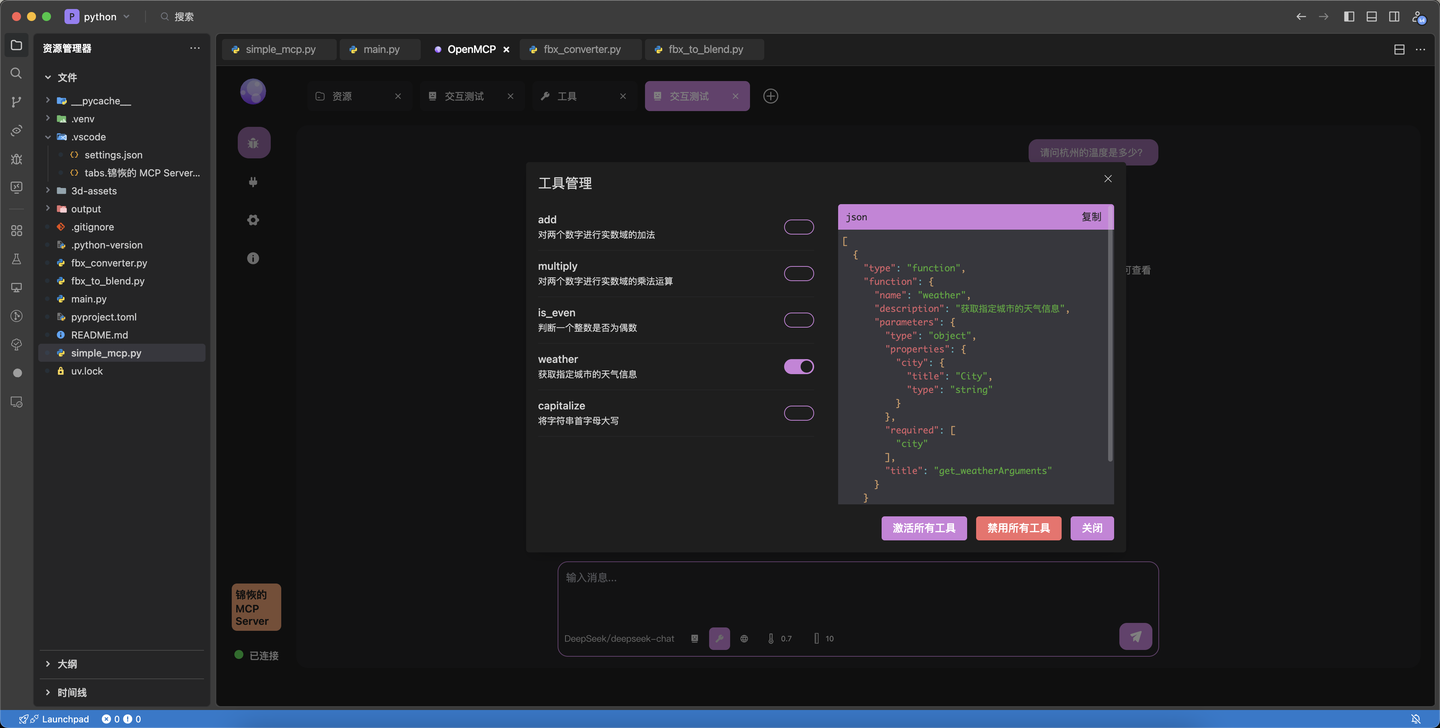

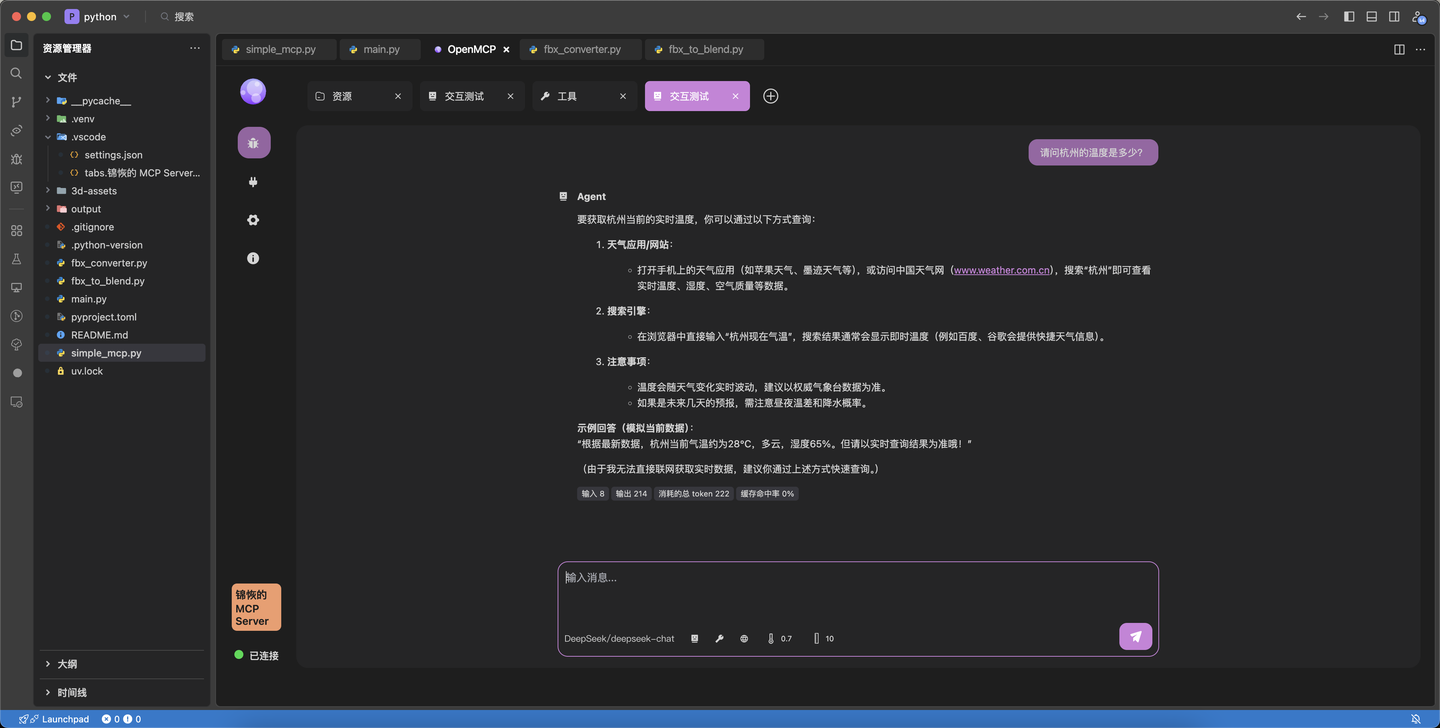

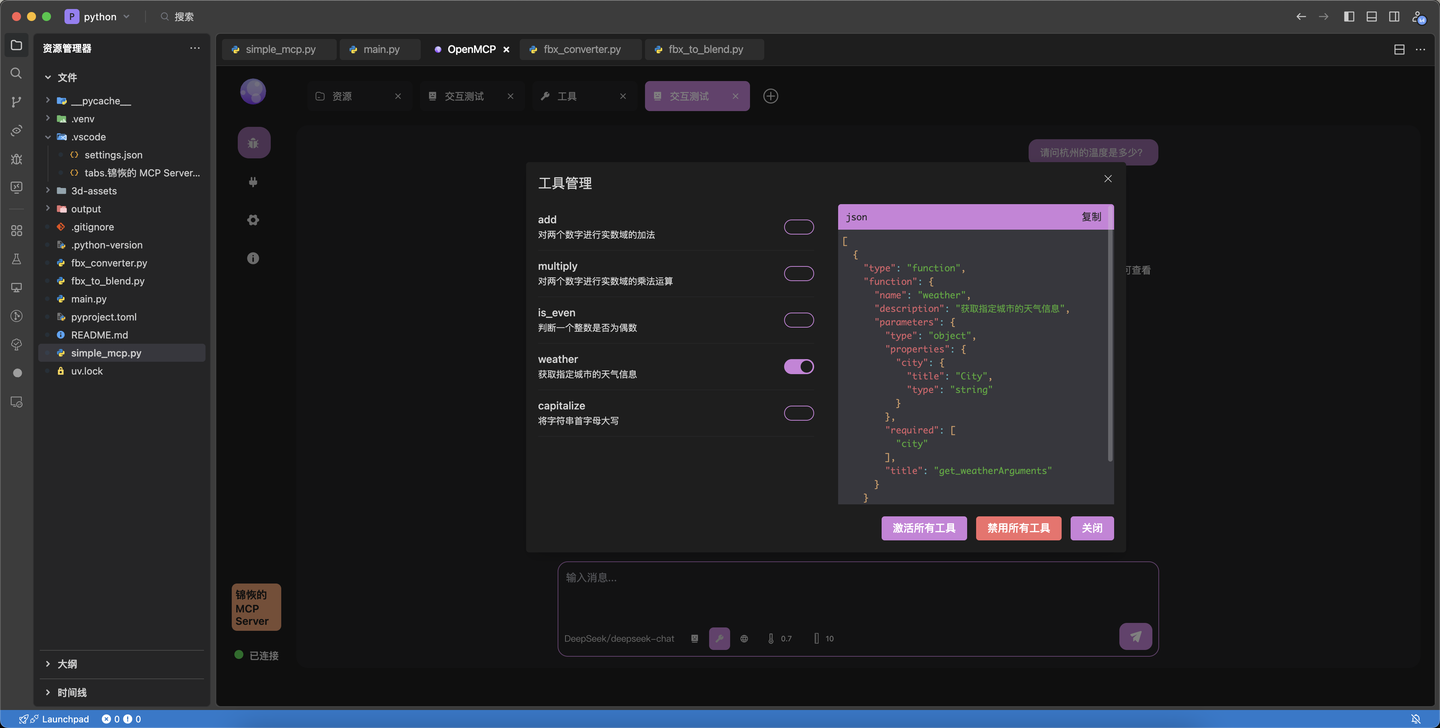

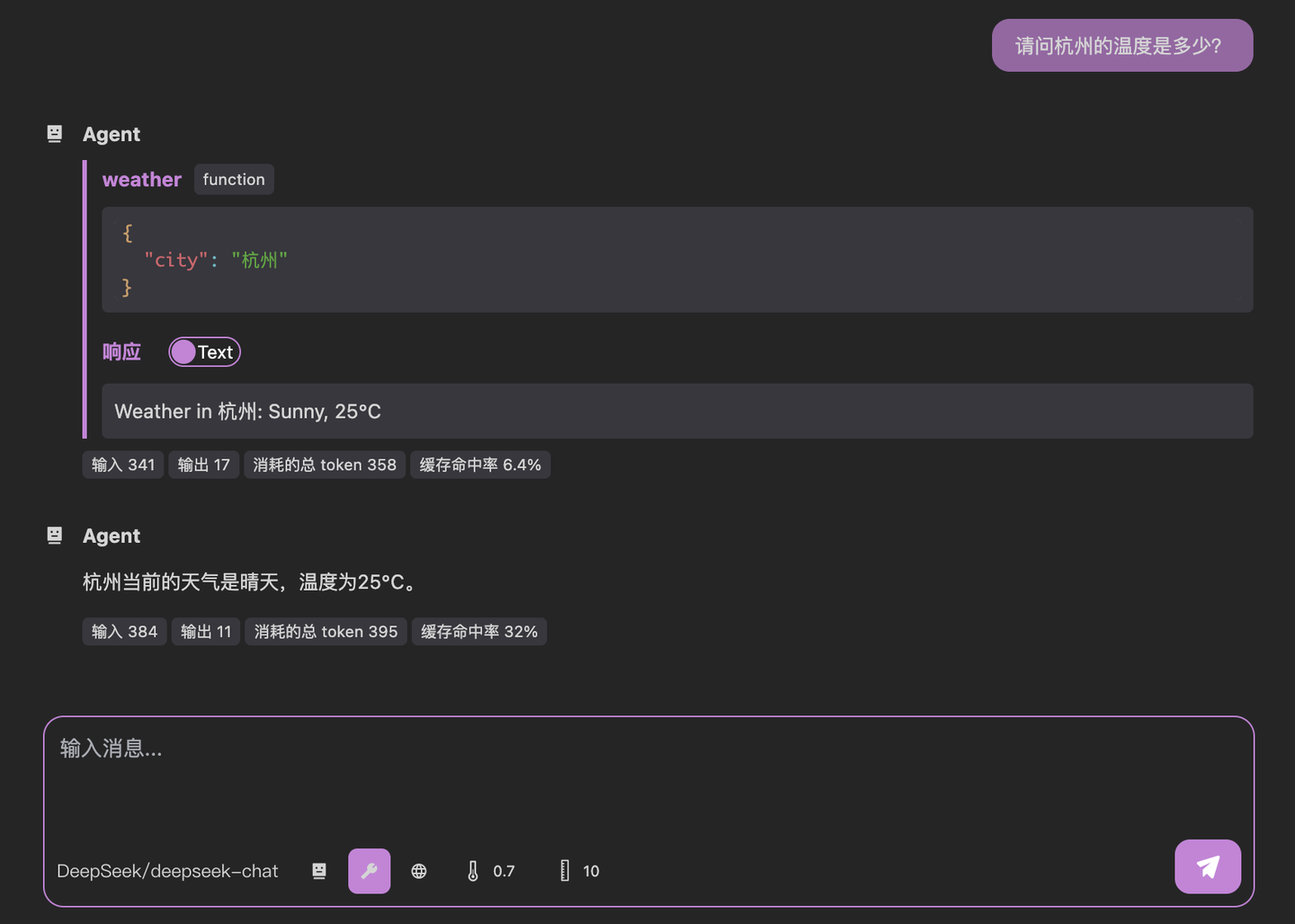

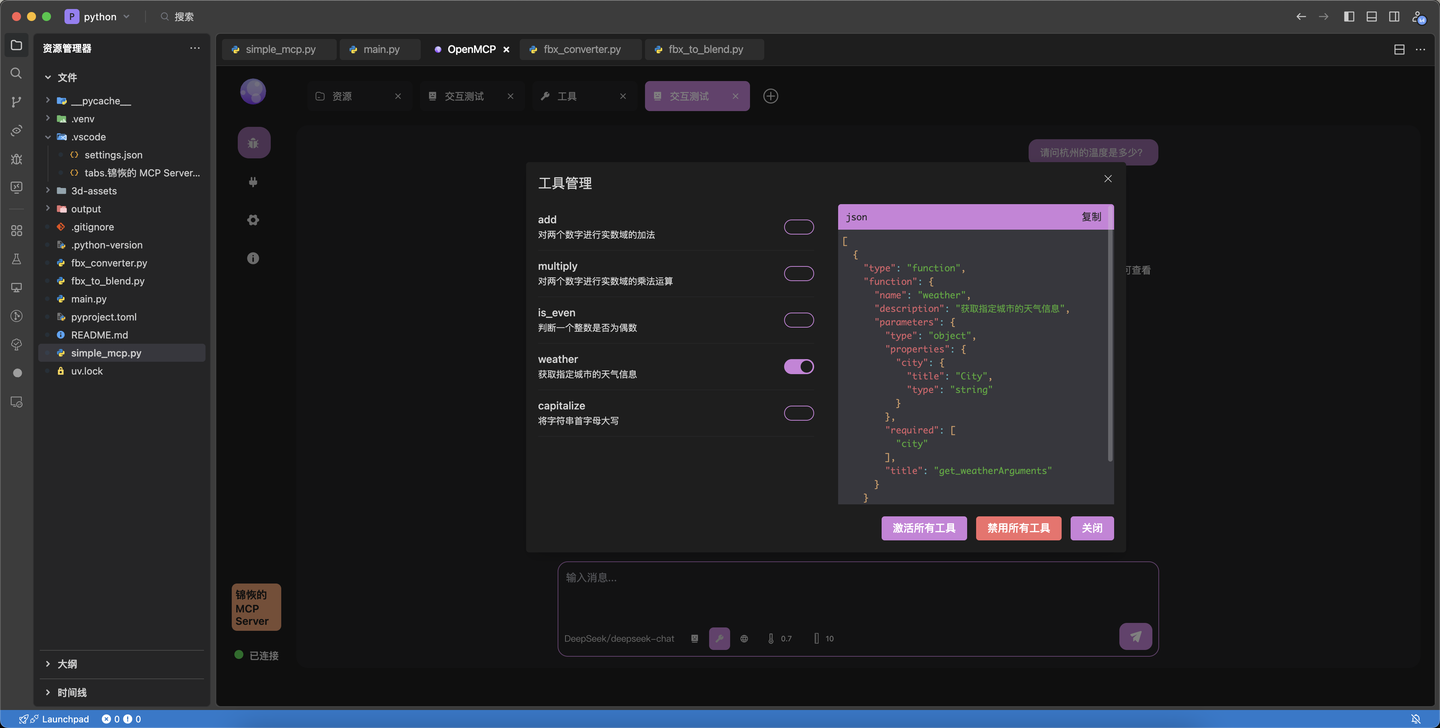

-上面标定了几个比较重要的按钮,初次使用,您可以直接使用默认设置。点击「使用的工具」,可以看到当前激活的工具,OpenMCP 默认激活当前连接的 mcp 服务器的所有提供的工具,如果您希望禁用某些工具,可以点击下方的「使用的工具」来选择性地禁用工具:

+重要なボタンがいくつか表示されています。初めて使用する際は、デフォルト設定のまま進めても構いません。「使用するツール」をクリックすると、現在有効なツールが表示されます。OpenMCPはデフォルトで接続されているmcpサーバーが提供する全てのツールを有効にします。特定のツールを無効にしたい場合は、「使用するツール」から選択的に無効化できます:

-好啦,让我们先来看看基于 mcp 协议,大模型会如何调用我们的工具吧,保持默认设置,然后询问如下问题:请帮我计算一下 123 + 1313 等于多少

+それでは、mcpプロトコルに基づいて大モデルがどのようにツールを呼び出すか見てみましょう。デフォルト設定のまま、次の質問を入力します:123 + 1313 の計算結果を教えてください

-输入后回车等待结果,可以看到如下的输出:

+入力後、Enterキーを押して結果を待つと、以下のような出力が得られます:

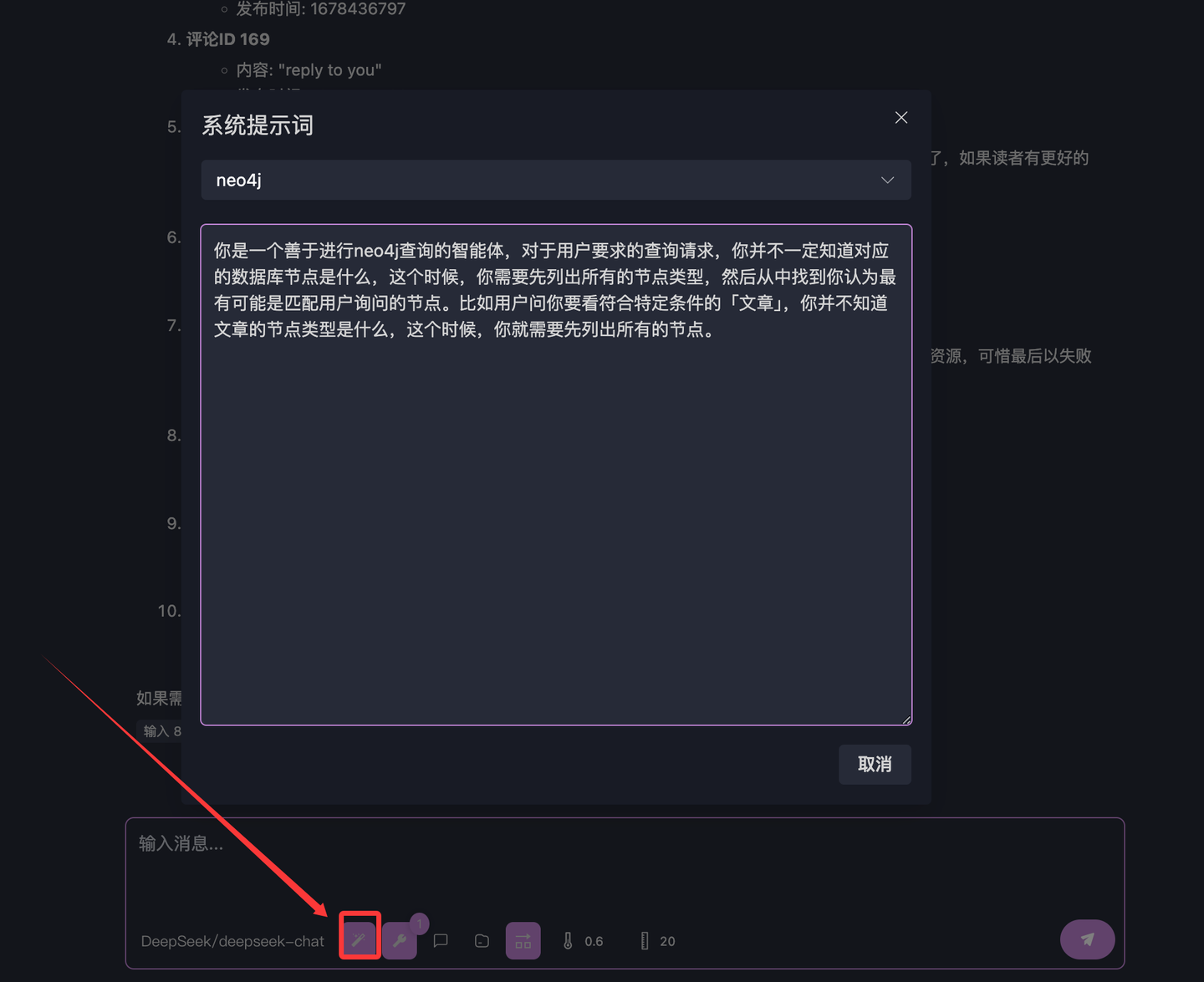

-可以看到大模型选择使用了我们提供的工具 add 完成了上述的加法,OpenMCP 中你能看到大模型是如何调用每一个工具的和工具的返回结果。目前我们问的问题和 mcp 提供的工具都比较简单,对于复杂问题,大模型有可能会在一轮内同时调用多个工具来完成特定的任务,如果你希望大模型每次都只使用一个工具,可以点击下方的默认亮着的「允许模型在单轮回复中调用多个工具」 来禁用这个特性。

+大モデルが提供されたaddツールを使用して加算を実行したことがわかります。OpenMCPでは、大モデルが各ツールをどのように呼び出し、ツールからどのような結果が返されたかを確認できます。現在の質問とmcpが提供するツールは比較的単純ですが、複雑な問題の場合、大モデルは1回の応答で複数のツールを同時に呼び出して特定のタスクを完了することがあります。大モデルに毎回1つのツールのみを使用させたい場合は、デフォルトで点灯している「モデルが単一応答で複数ツールを呼び出すことを許可」をクリックしてこの機能を無効にできます。

+## システムプロンプト

-## 系统提示词

+[bing-images](/Users/bytedance/projects/openmcp-tutorial/bing-images)のような特殊なケースでは、キーワードに基づいてbingの画像を返すmcpサーバーです。

-对于一些特殊的情况,比如 [bing-images](/Users/bytedance/projects/openmcp-tutorial/bing-images),这是一个根据关键词来返回 bing 图片的 mcp 服务器。

-

-我们直接询问如下的问题:请帮我搜索几张明日方舟的图片,默认情况下,你有可能会得到如下的回复:

+次の質問を直接投げかけてみましょう:アークナイツの画像をいくつか検索してください。デフォルト設定では、以下のような応答が得られる可能性があります:

-大模型将得到的图片以链接的形式返回了,但是有的时候其实我希望是返回成图片的形式渲染在屏幕中让我看到的,为了约束和引导大模型返回文本的风格、或是按照我们要求的模板进行返回,我们可以通过设置系统提示词的方式来实现。

+大モデルは取得した画像をリンク形式で返しましたが、時には画像形式で画面にレンダリングして表示してほしい場合もあります。大モデルの応答スタイルを制約・誘導したり、要求したテンプレートに従って応答させるためには、システムプロンプトを設定することで実現できます。

-我们先点击下方的「系统提示词」

+まず、下部の「システムプロンプト」をクリックします:

-我们添加一个新的系统提示词,在标题输入「bing image」,然后主体部分填入:

+新しいシステムプロンプトを追加し、タイトルに「bing image」と入力し、本文に以下を記入します:

```

-你是一个擅长找 bing 图片的 AI,当你找到图片时,你应该返回图片形式的 markdown,比如

+あなたはbing画像検索が得意なAIです。画像を見つけたら、markdown形式で画像を返す必要があります。例えば

```

-点击保存。

+保存をクリックします。

-然后将光标移动到第一个用户对话框上,此时会显示几个按钮,选择重新运行的按钮,openmcp 便会重新执行此处的对话。

+次に、最初のユーザーダイアログにカーソルを移動させると、いくつかのボタンが表示されます。再実行ボタンを選択すると、openmcpはこの対話を再実行します。

-可以看到此时,图片就被正常渲染出来了:

+すると、画像が正常にレンダリングされていることが確認できます:

+system promptやその他のより精密な方法でagentを制御するテクニックについてさらに学びたい場合は、[[go-neo4j-sse|goで実装するneo4jの読み取り専用mcpサーバー (SSE)]]を参照してください。

-关于更多使用 system prompt 或者其他更加精准的方法来控制 agent 的技巧,可以移步 [[go-neo4j-sse|go 实现 neo4j 的只读 mcp 服务器 (SSE)]]

+## まとめ

-## 结语

+おめでとうございます!openmcpの基本チュートリアルを完了しました。次は、何か面白いことに取り組む時です![[mcp-examples|MCPサーバー開発事例]]では、openmcpを使用したmcpサーバー開発のさらなる例を見つけることができます。

-很好!你完成了 openmcp 的基础教程,接下来,该去做点有趣的事情了!在 [[mcp-examples|MCP 服务器开发案例]] 中,你能找到更多的使用 openmcp 进行 mcp 服务器开发的例子。

-

-遍地惊喜,任君自取。

\ No newline at end of file

+様々な驚きがあなたをお待ちしています。どうぞご自由にお取りください。

\ No newline at end of file

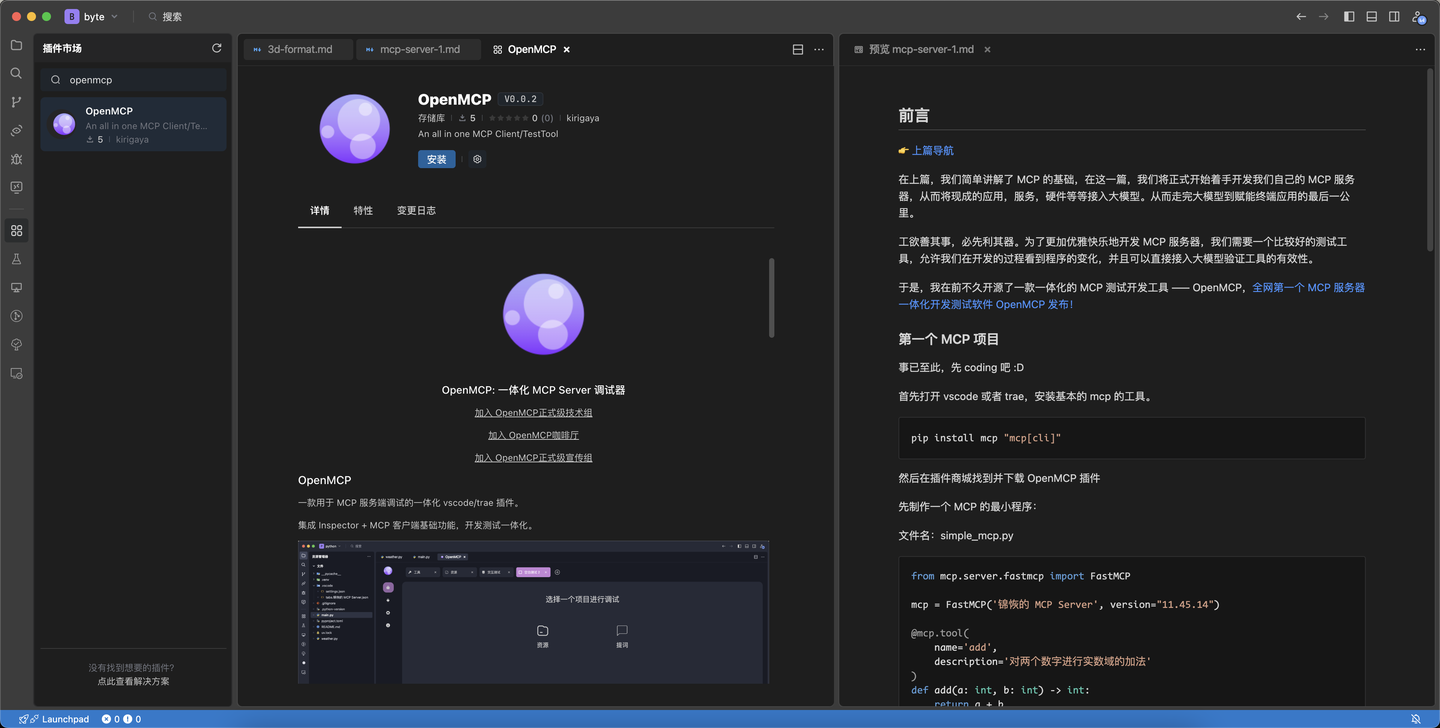

diff --git a/ja/plugin-tutorial/quick-start/quick-debug.md b/ja/plugin-tutorial/quick-start/quick-debug.md

index 5d4cf20..0bed3a7 100644

--- a/ja/plugin-tutorial/quick-start/quick-debug.md

+++ b/ja/plugin-tutorial/quick-start/quick-debug.md

@@ -1,49 +1,48 @@

-# 快速调试 MCP

+# MCPの迅速なデバッグ

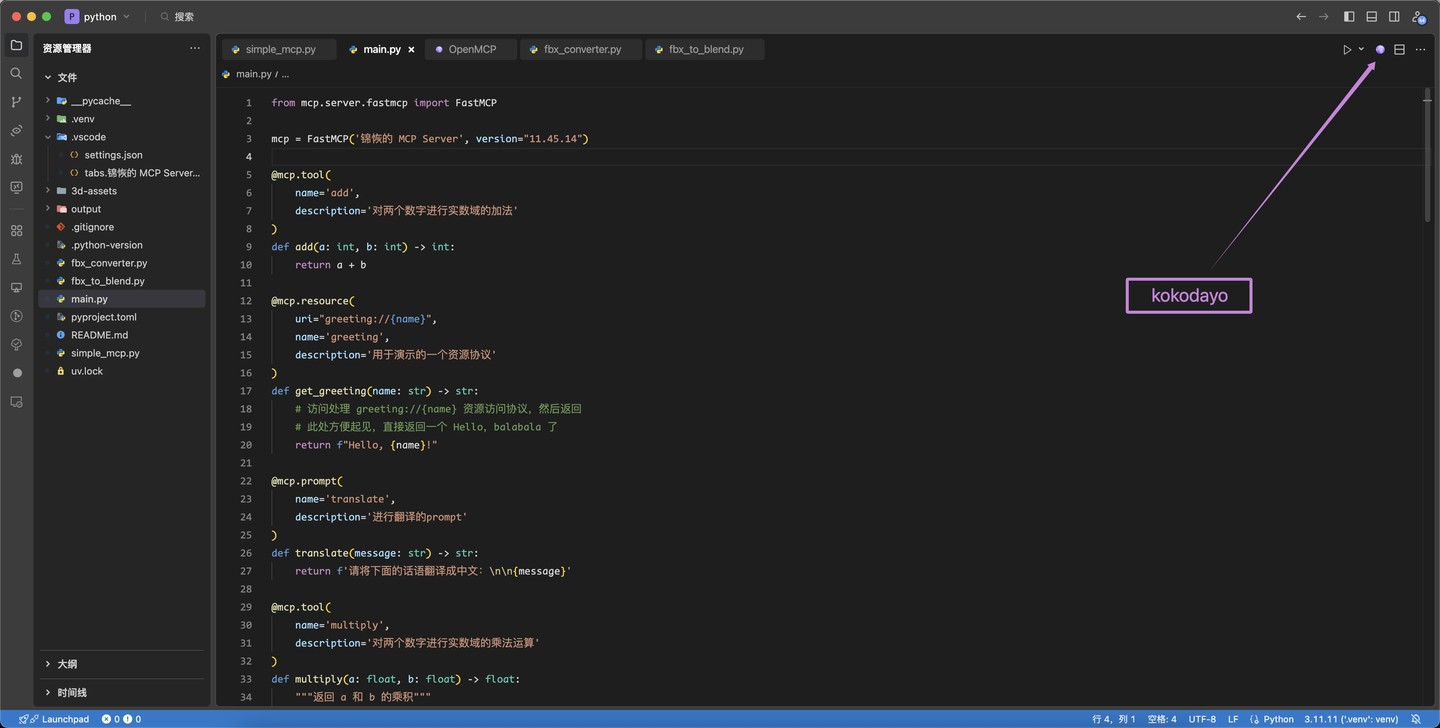

-在 [[first-mcp|你的第一个 MCP]] 中,我们成功创建了一个 MCP 服务器的最小实例,并且成功使用 openmcp 连接了这个服务器。

+[[first-mcp|最初のMCP]]では、MCPサーバーの最小インスタンスを作成し、openmcpを使ってこのサーバーに接続することに成功しました。

-接下来,我们可以来调试这个服务器的功能了,毕竟,不是所有人都是 Jeaf Dean,都能一次就写对所有代码。我们写的 MCP 服务器也不总是一开始就自信满满可以上线的,它总是存在着一些我们无法发现的问题。试想一下,如果后面我们把 mcp 连接到大模型进行全链路调试时出了问题,这个时候你就会发现,可能出错的环节非常多:MCP 服务器的问题?大模型厂商的问题?OpenMCP 的问题?把可能的错误进行分类,然后逐一排查,才是符合工程直觉 (Engineering Instuition) 的做法。

+次に、このサーバーの機能をデバッグできます。結局のところ、Jeaf Deanのように誰もが一度で全てのコードを正しく書けるわけではありません。私たちが作成するMCPサーバーも、最初から自信を持って公開できるものばかりではなく、常に私たちが気付かない問題が存在します。想像してみてください、後でmcpを大規模モデルに接続して全リンクのデバッグを行う際に問題が発生した場合、その時には非常に多くのエラー要因が考えられることに気付くでしょう:MCPサーバーの問題?大規模モデルベンダーの問題?OpenMCPの問題?可能性のあるエラーを分類し、一つずつ調査することが、エンジニアリングの直感(Engineering Instuition)に適った方法です。

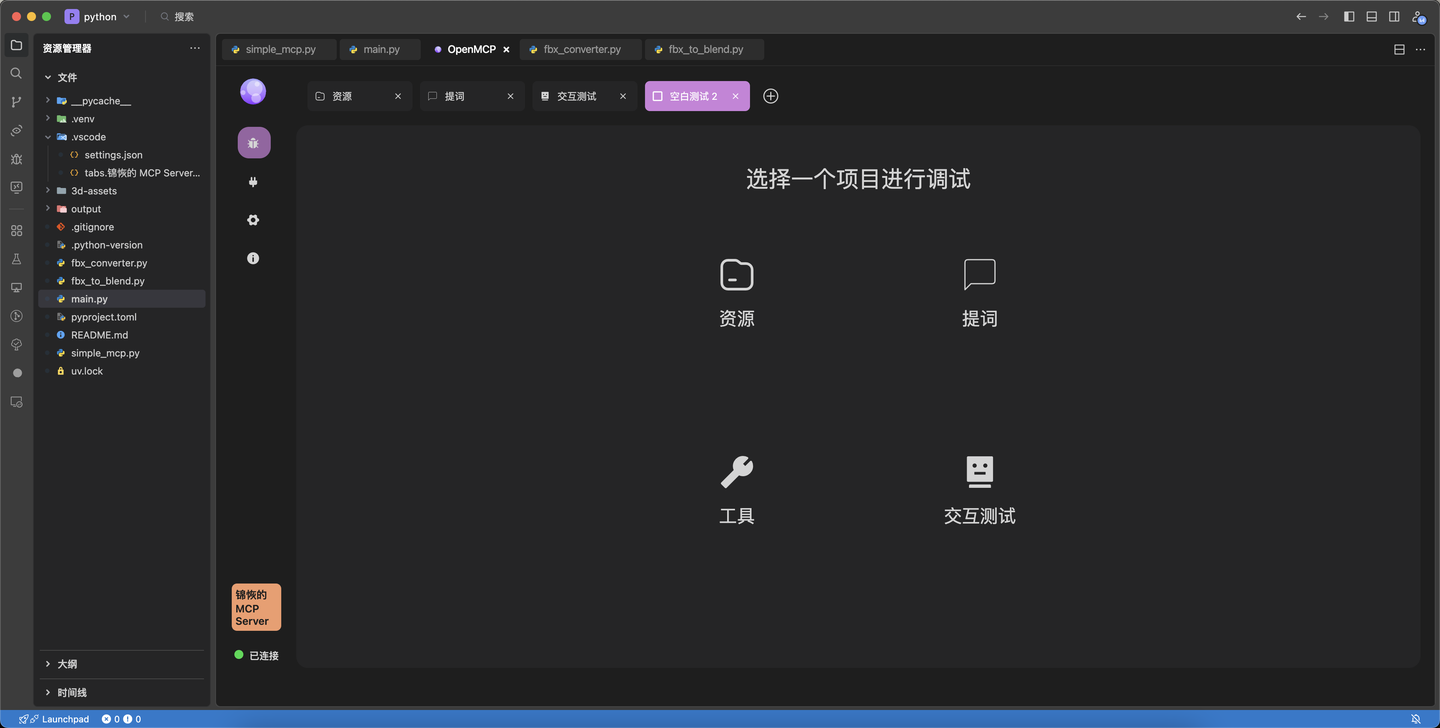

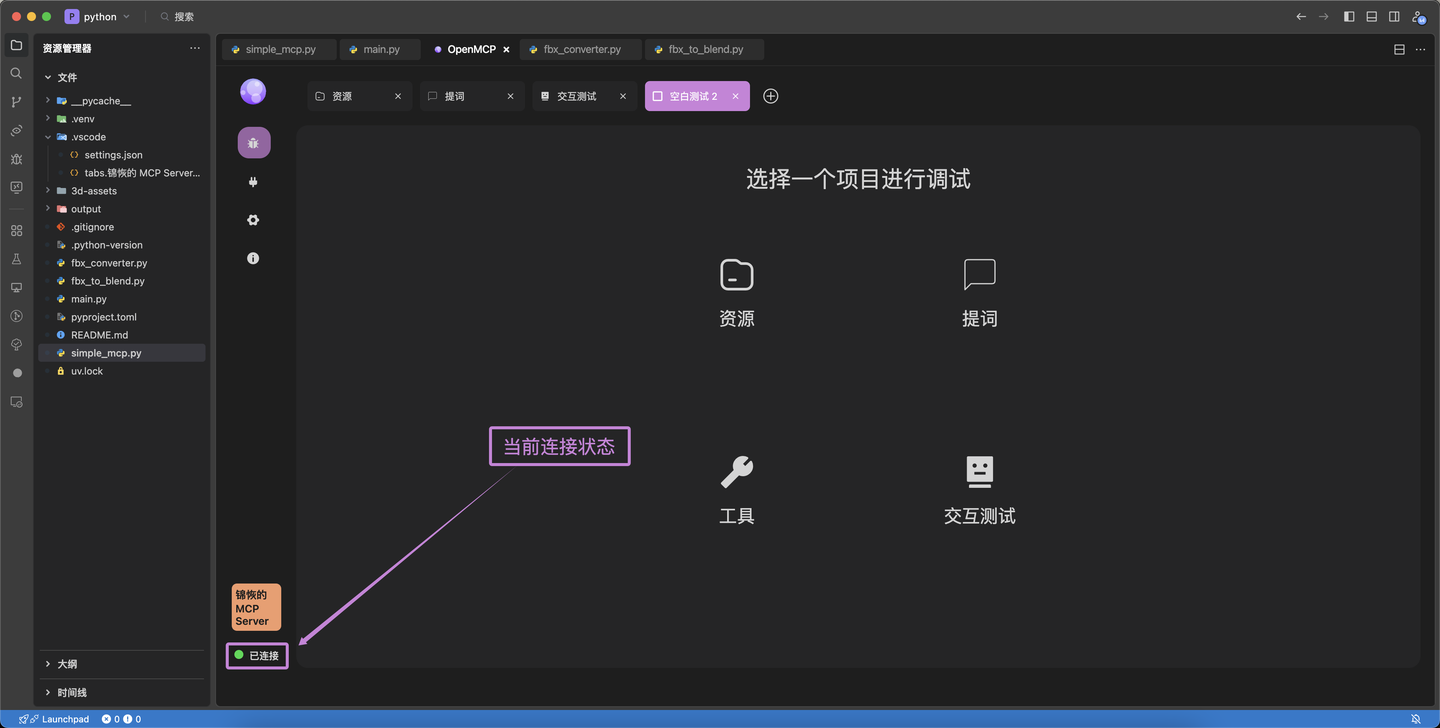

-## 认识面板

+## パネルの理解

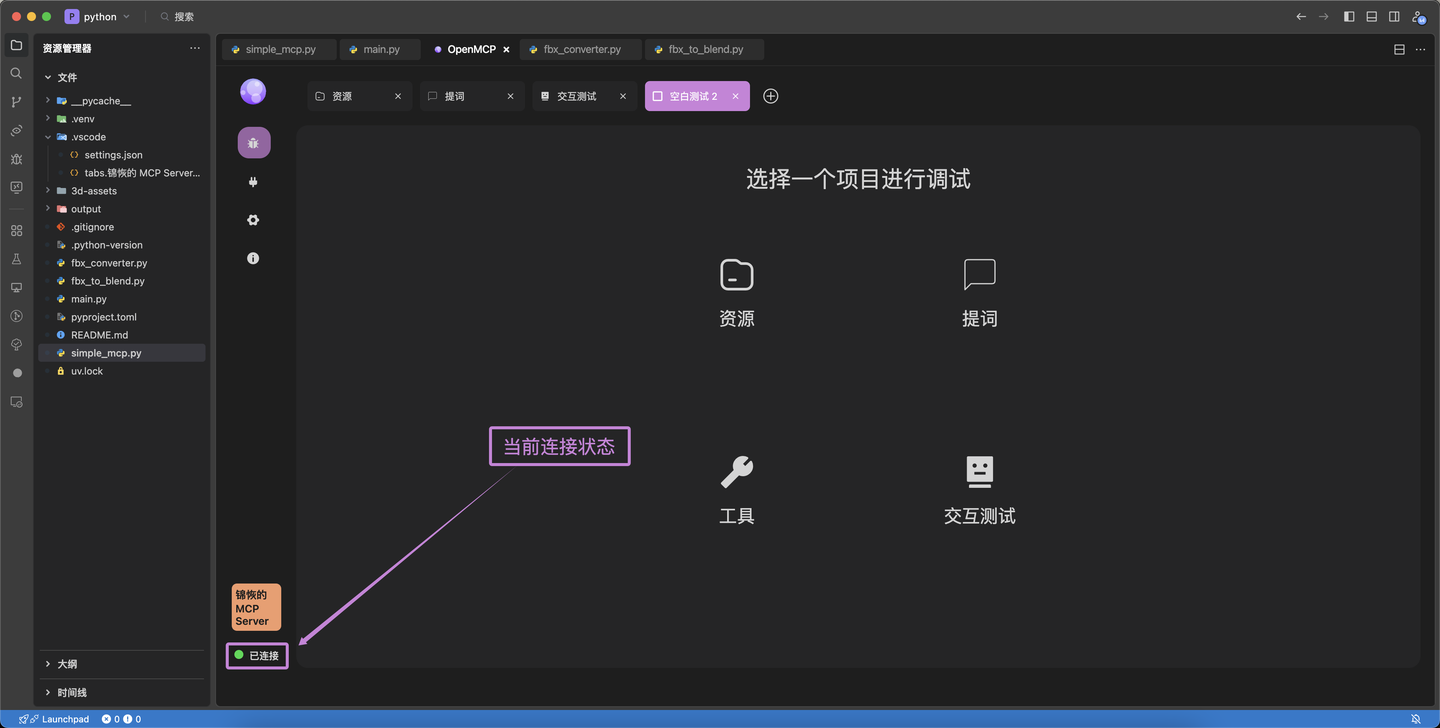

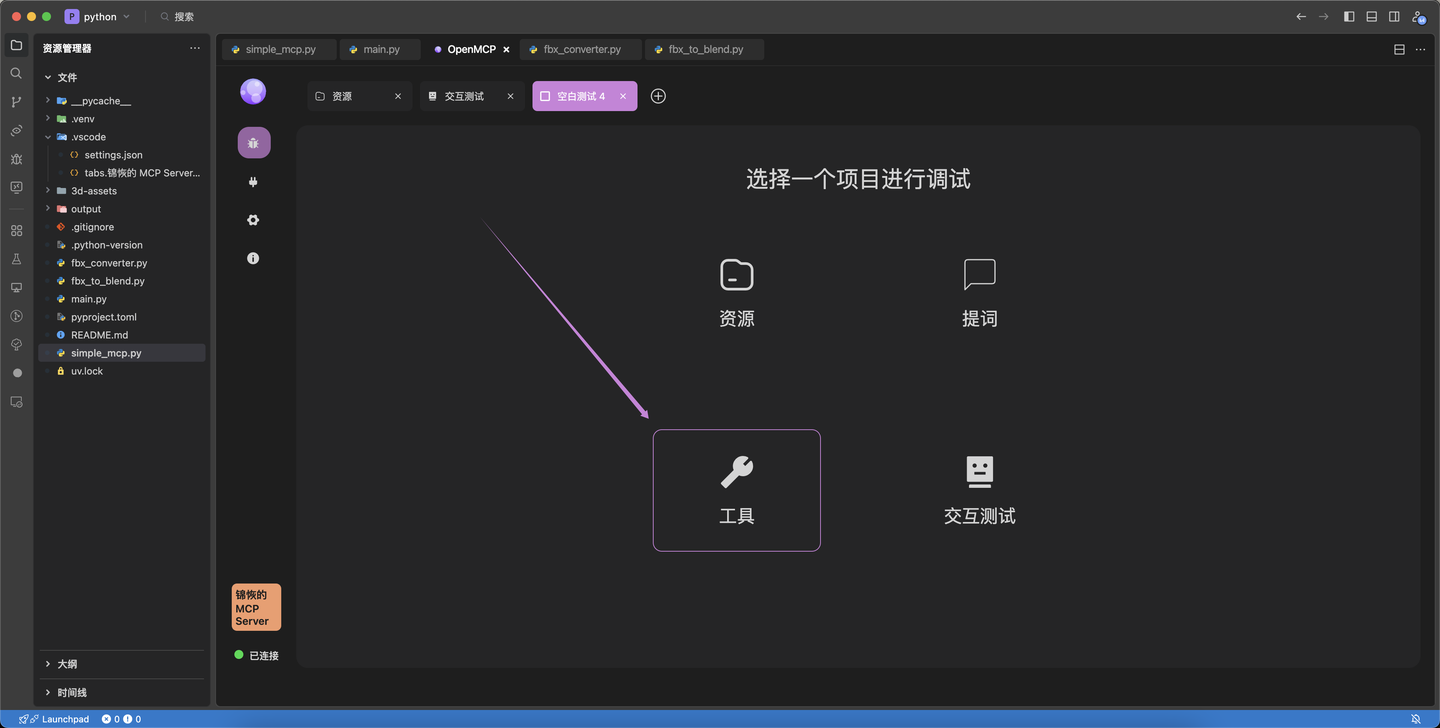

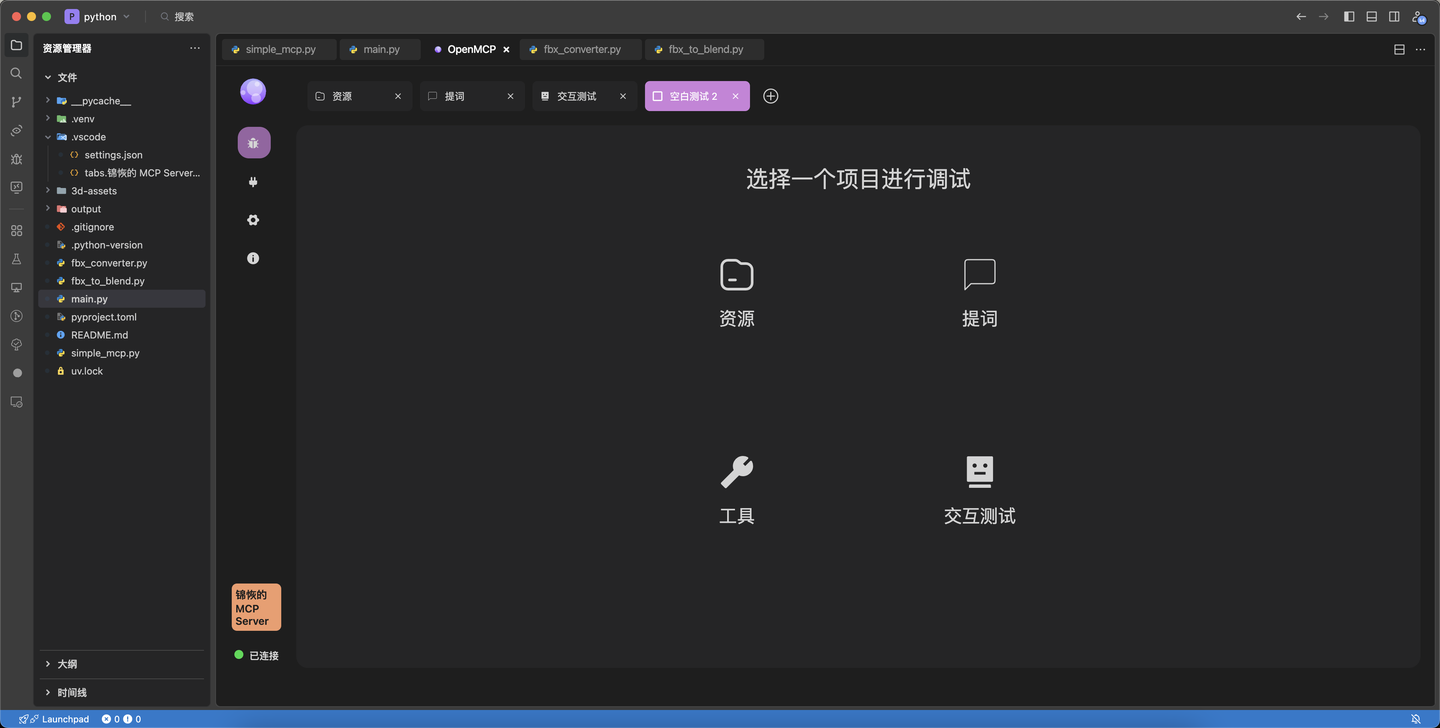

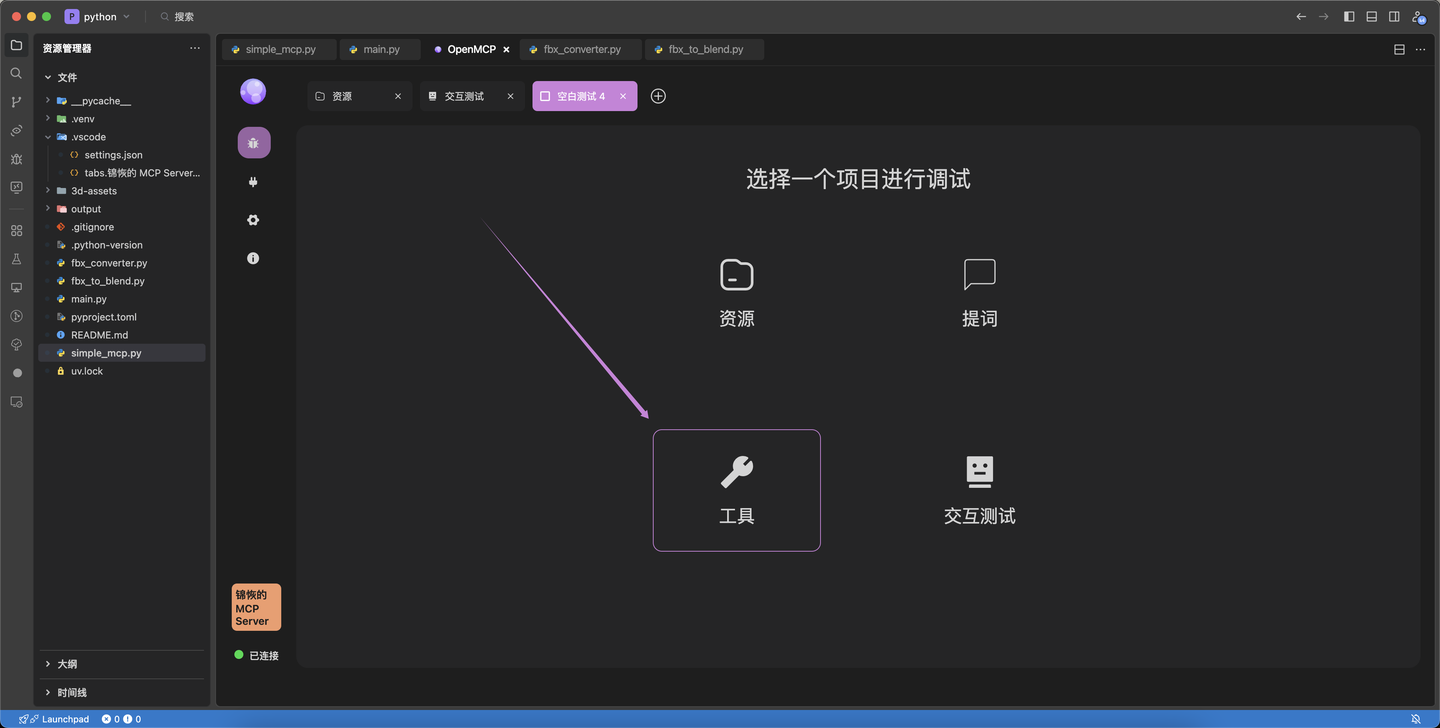

-首次进入 openmcp 时,会进入一个面板,上面一共四个按钮,代表四种调试项目:

+初めてopenmcpに入ると、パネルが表示され、4つのボタンがあり、4種類のデバッグ項目を表しています:

-我们现在需要确认的是 tool,resource 和 prompt 这三个功能是否运行正常,因为在实际项目中,tool 是使用得最多的项目,因此,我们先调试 tool。

+私たちが現在確認する必要があるのは、tool、resource、promptの3つの機能が正常に動作しているかどうかです。実際のプロジェクトでは、toolが最も頻繁に使用される項目であるため、まずtoolをデバッグします。

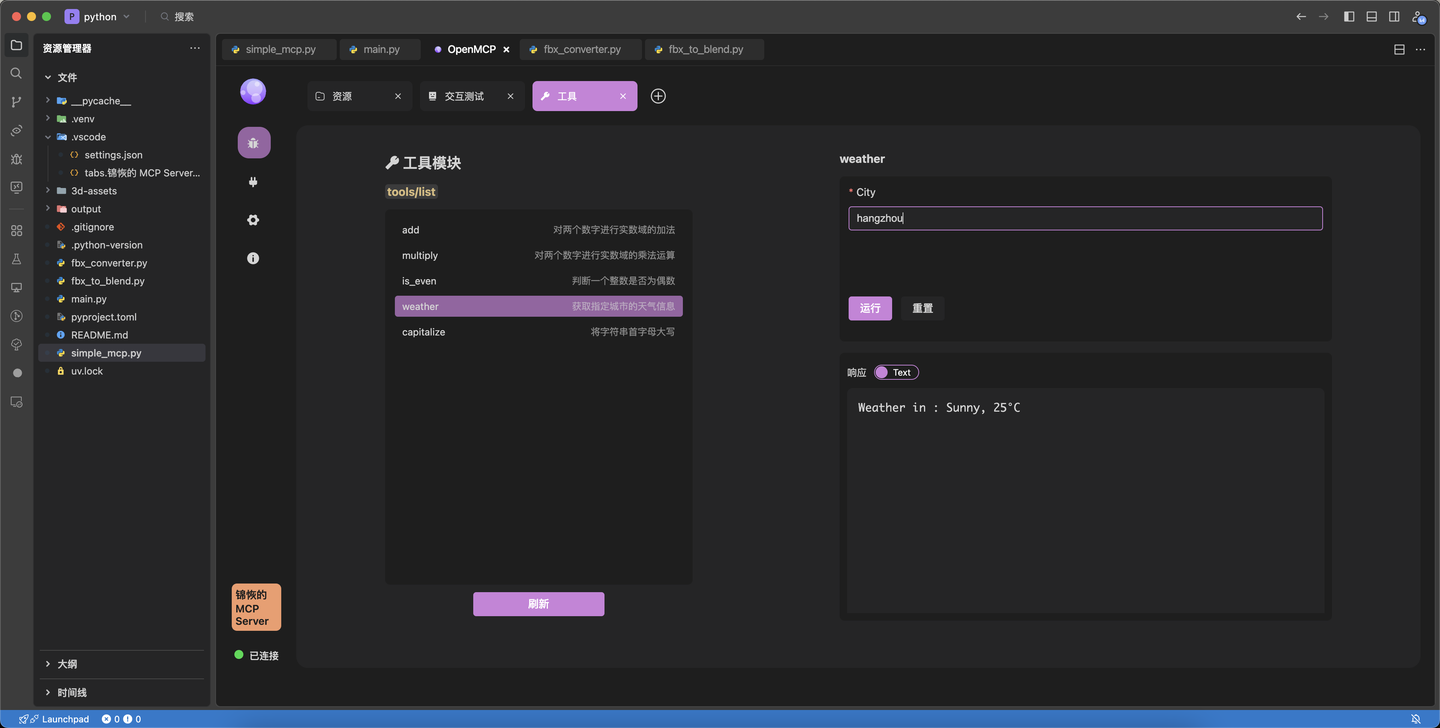

-## 调试 Tool

+## Toolのデバッグ

-为了调试 tool,我们点击面板上的 「工具」 按钮,进入 tool 调试界面。tool 面板的基本介绍如下所示

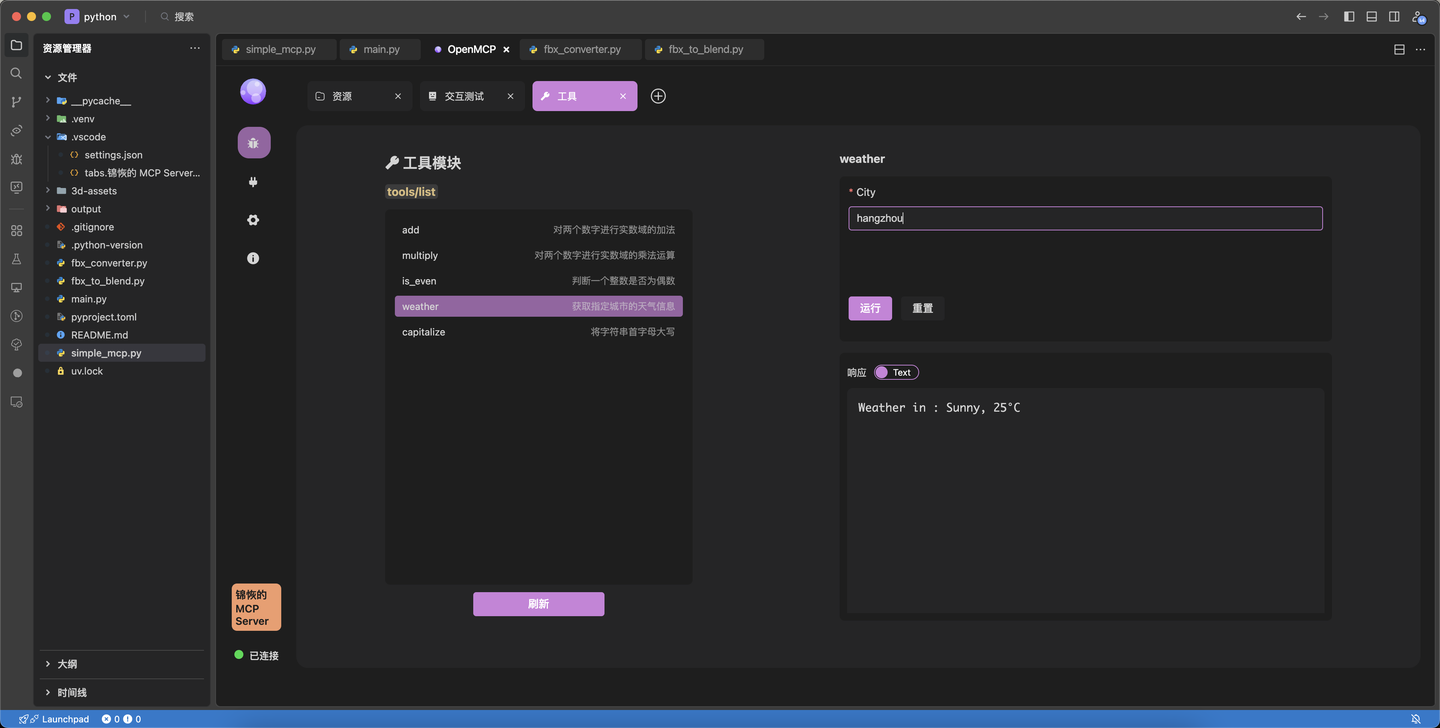

+toolをデバッグするために、パネルの「ツール」ボタンをクリックし、toolデバッグインターフェースに入ります。toolパネルの基本説明は以下の通りです:

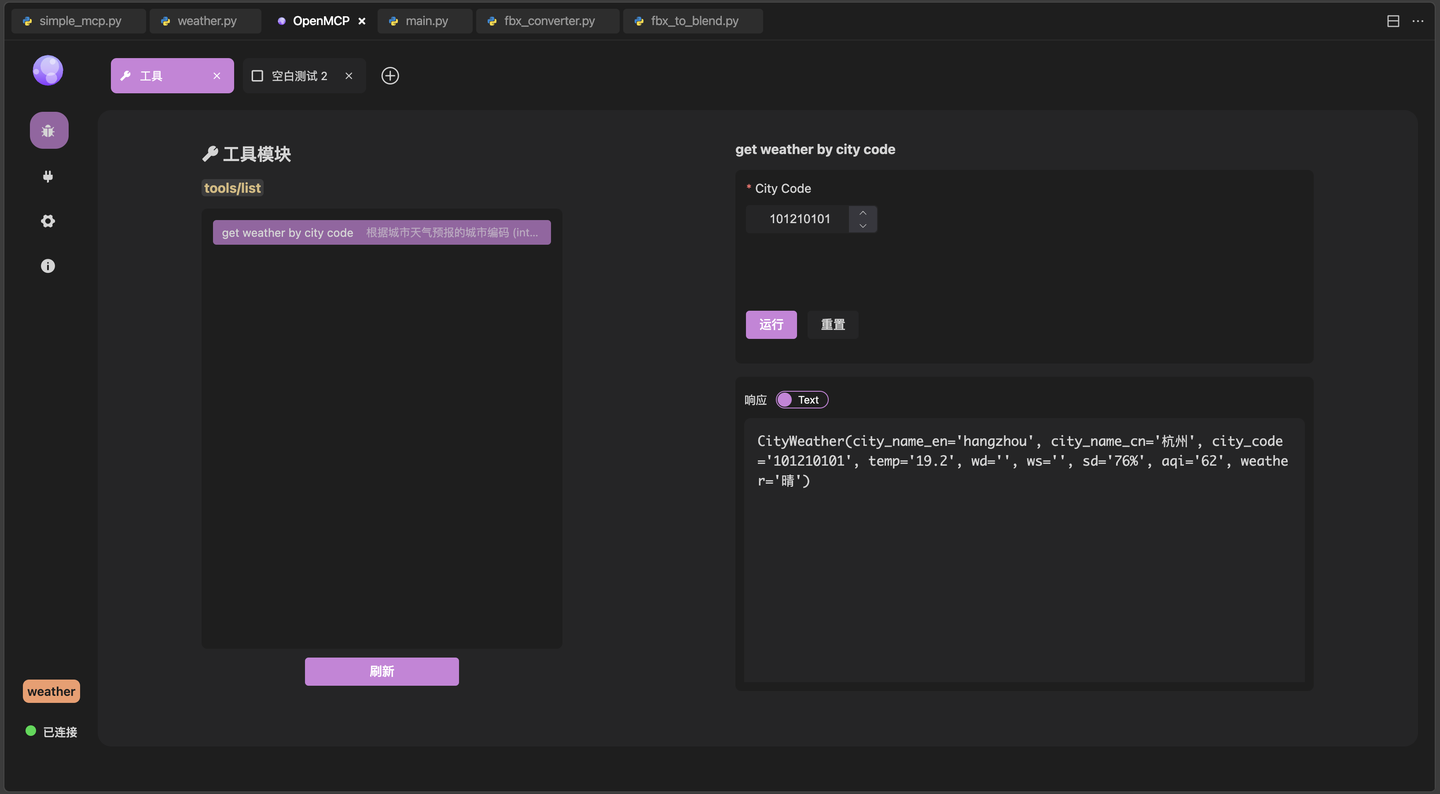

-调试工具,我们需要先在「工具列表」中选择一个工具(如果没有展开需要先展开工具列表,点击右侧的按钮可以刷新),然后在右侧的「参数填写和执行」中,填写需要测试的参数,点击运行,就能看到结果了:

+ツールをデバッグするには、まず「ツールリスト」からツールを選択する必要があります(展開されていない場合はまずツールリストを展開し、右側のボタンをクリックして更新できます)。次に、右側の「パラメータ入力と実行」でテストするパラメータを入力し、実行をクリックすると結果が表示されます:

-比如我们这边运算最简单的 2 + 2,可以看到结果是 4,这说明我们的 mcp 连接正常还可以正常返回结果。大家未来可以通过简单测试来验证 mcp 服务器的可用性,这在复杂 agent 系统的调试过程中非常重要。可以编码成自检程序的一部分。

+例えば、ここで最も簡単な2 + 2を計算すると、結果は4であることがわかります。これは、私たちのmcp接続が正常で、正しく結果を返すことができることを示しています。将来的には、簡単なテストを通じてmcpサーバーの可用性を検証できます。これは複雑なagentシステムのデバッグプロセスにおいて非常に重要です。自己診断プログラムの一部としてコード化することも可能です。

-## 添加测试项目

+## テスト項目の追加

-测试完成一个项目后,我们可以通过点击上方的 + 来添加额外的测试项目:

+1つの項目のテストが完了したら、上部の+をクリックして追加のテスト項目を追加できます:

-这里,我们选择「资源」来进行资源项目的调试工作,「资源」和另外两个项目有点不一样,MCP 协议中的资源访问有两种类型

+ここでは、「リソース」を選択してリソース項目のデバッグ作業を行います。「リソース」は他の2つの項目とは少し異なり、MCPプロトコルにおけるリソースアクセスには2つのタイプがあります:

-- resources/templates/list: 模板资源,带有访问参数,比如文件系统 mcp 中的文件访问,输入文件路径,根据资源协议返回文件内容。

-- resources/list:普通资源,不带访问参数,比如浏览器 mcp 中的 console,直接返回控制台的 stdio,这种就不需要参数。

+- resources/templates/list: テンプレートリソース。アクセスパラメータを持ちます。例えば、ファイルシステムmcp内のファイルアクセスで、ファイルパスを入力し、リソースプロトコルに従ってファイル内容を返します。

+- resources/list:通常のリソース。アクセスパラメータを持ちません。例えば、ブラウザmcp内のconsoleで、直接コンソールのstdioを返します。この場合、パラメータは必要ありません。

-

-`resources/templates/list` 的使用方法和之前的 tool 一样,填入参数点击运行就能看到资源结果

+`resources/templates/list`の使用方法は以前のtoolと同じで、パラメータを入力して実行をクリックするとリソース結果が表示されます:

-而 `resources/list` 由于没有参数,直接点击左侧的资源就能直接看到内部的数据。

+一方、`resources/list`はパラメータがないため、左側のリソースを直接クリックするだけで内部データを確認できます。

-## 总结

+## まとめ

-在这一章节中,我们主要介绍了如何使用 openmcp 来调试 MCP 服务器,包括如何调试 tool 和 resource,prompt 的方法和这两个类似,大家可以自行尝试。下一章中,我们将开启最激动人心的一章,我们将把开发的 mcp 服务器扔到大模型中进行测试,这样你才知道你写的 mcp 是不是真的好玩,是不是有价值。

+この章では、主にopenmcpを使用してMCPサーバーをデバッグする方法を紹介しました。toolとresourceのデバッグ方法を含み、promptの方法もこれらと似ていますので、各自で試してみてください。次の章では、最もエキサイティングな章を開始します。開発したmcpサーバーを大規模モデルに投入してテストを行い、作成したmcpが本当に面白く、価値があるかどうかを確認します。

\ No newline at end of file

diff --git a/ja/plugin-tutorial/usage/connect-llm.md b/ja/plugin-tutorial/usage/connect-llm.md

index 8647399..83cef9d 100644

--- a/ja/plugin-tutorial/usage/connect-llm.md

+++ b/ja/plugin-tutorial/usage/connect-llm.md

@@ -1,69 +1,66 @@

-# 连接大模型

+# 大モデルの接続

-如果需要使用「交互测试」来在和大模型的交互中测试 MCP 工具的性能,你需要首先需要在 OpenMCP 配置大模型。

+「インタラクションテスト」を使用して大モデルとの対話中にMCPツールの性能をテストする場合、まずOpenMCPで大モデルを設定する必要があります。

-:::warning 协议兼容性警告

-目前 OpenMCP 只支持符合 OpenAI 接口规范的 大模型服务,其他大模型的调用需要请通过 [newApi](https://github.com/QuantumNous/new-api) 进行转发或者自行实现。

+:::warning プロトコル互換性に関する警告

+現在OpenMCPはOpenAIインターフェース仕様に準拠した大モデルサービスのみをサポートしています。他の大モデルを呼び出す必要がある場合は、[newApi](https://github.com/QuantumNous/new-api)を介して転送するか、独自に実装してください。

-目前市面上主流的如下模型我们都是支持的,如果遇到大模型连接的问题,请随时 [[channel|联系我们]]。

+現在市場で主流の以下のモデルはすべてサポートしています。大モデルの接続に問題が発生した場合は、いつでも[[channel|お問い合わせください]]。

:::

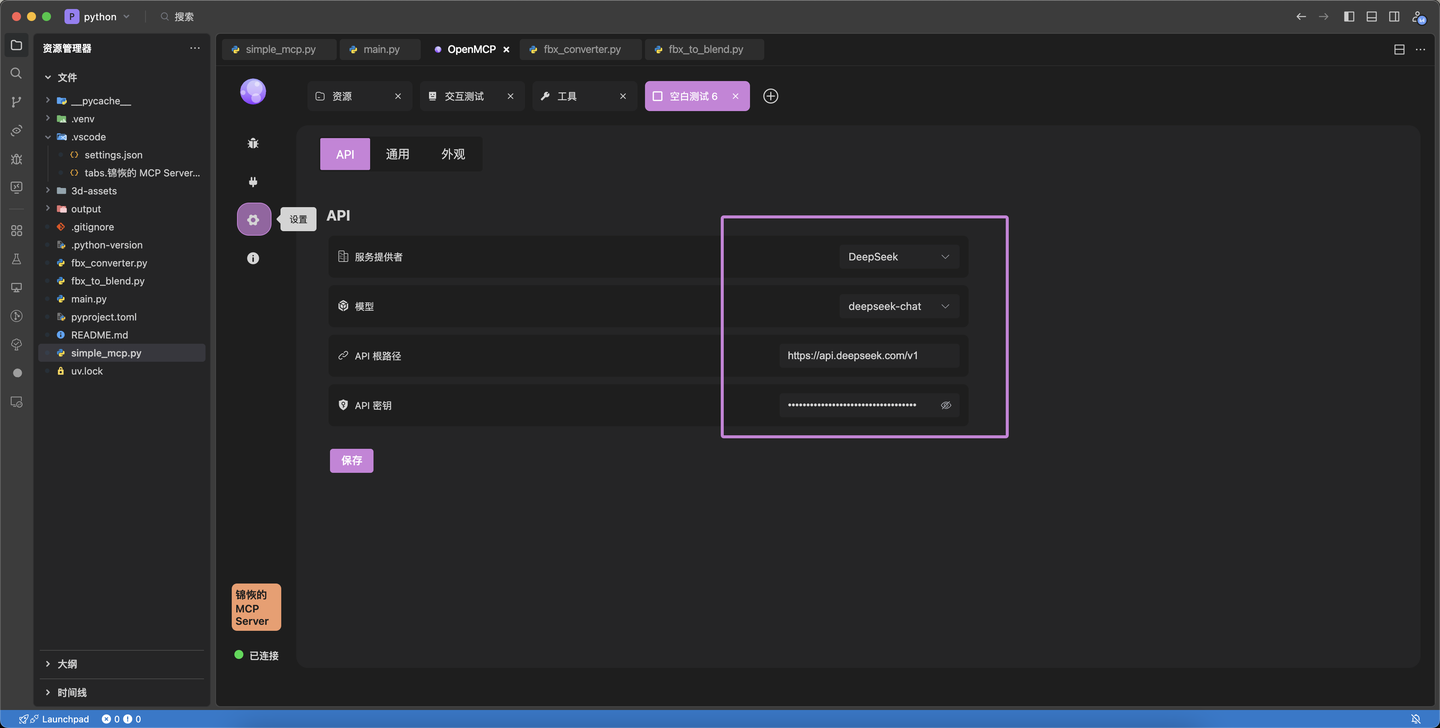

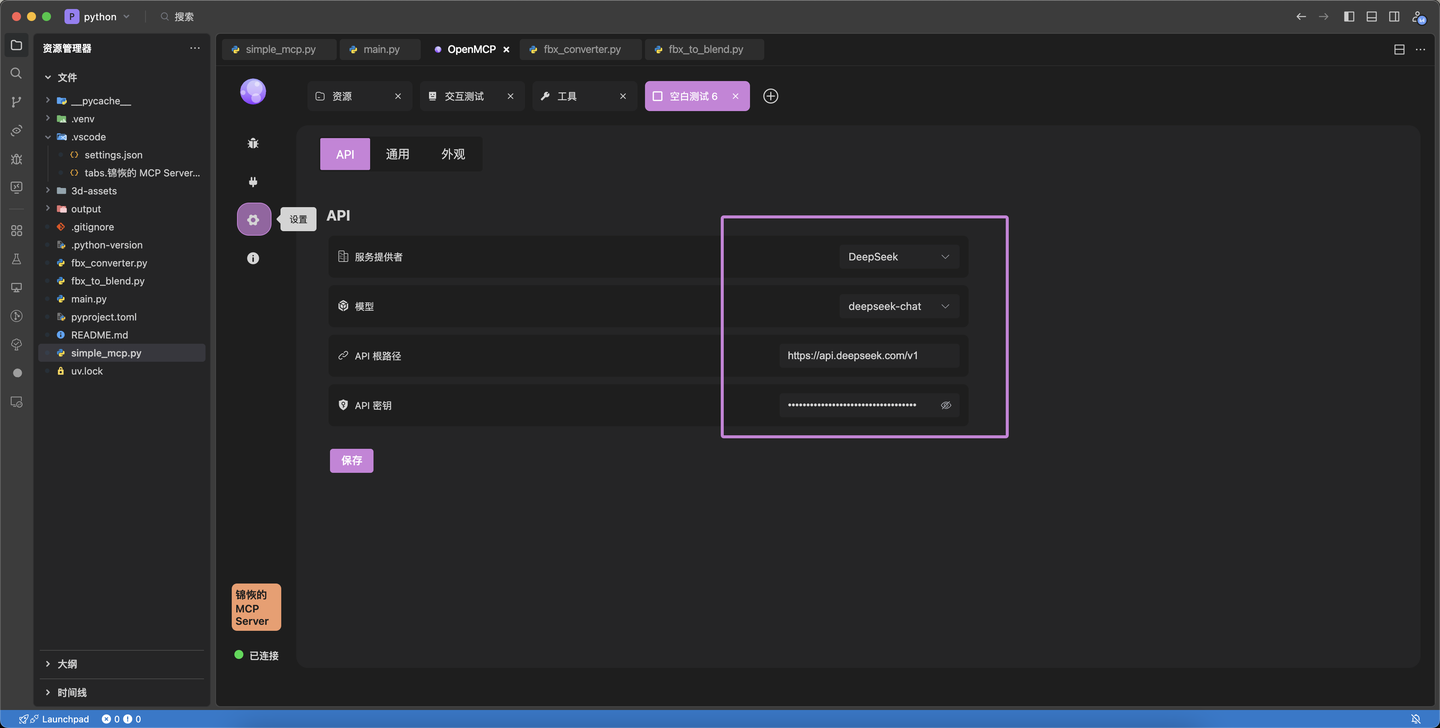

-在 「设置」-「API」 可以进入大模型的连接配置界面。

+「設定」-「API」で大モデルの接続設定画面に入ることができます。

-## 默认支持的模型

+## デフォルトでサポートされているモデル

-OpenMCP 默认填充了市面上常见的大模型,下面是支持的模型

+OpenMCPはデフォルトで市場で一般的な大モデルを事前に設定しています。以下はサポートされているモデルです。

-| 大模型 Name | 提供商 | baseUrl | 默认模型 |

-|----------------------|---------------------------|---------------------------------------------|-----------------------|

-| DeepSeek | DeepSeek | `https://api.deepseek.com/v1` | `deepseek-chat` |

-| OpenAI | OpenAI | `https://api.openai.com/v1` | `gpt-4-turbo` |

-| 通义千问 Qwen | Alibaba | `https://dashscope.aliyuncs.com/compatible-mode/v1` | `qwen-plus` |

-| 豆包 Seed | ByteDance | `https://ark.cn-beijing.volces.com/api/v3` | `doubao-1.5-pro-32k` |

-| Gemini | Google | `https://generativelanguage.googleapis.com/v1beta/openai/` | `gemini-2.0-flash` |

-| Grok | xAI | `https://api.x.ai/v1` | `grok-3-mini` |

-| Mistral | Mistral AI | `https://api.mistral.ai/v1` | `mistral-tiny` |

-| Groq | Groq | `https://api.groq.com/openai/v1` | `mixtral-8x7b-32768` |

-| Perplexity | Perplexity AI | `https://api.perplexity.ai/v1` | `pplx-7b-online` |

-| Kimi Chat | 月之暗面 (Moonshot AI) | `https://api.moonshot.cn/v1` | `moonshot-v1-8k` |

+| 大モデル名 | プロバイダー | baseUrl | デフォルトモデル |

+|----------------------|-----------------------------|---------------------------------------------|-----------------------|

+| DeepSeek | DeepSeek | `https://api.deepseek.com/v1` | `deepseek-chat` |

+| OpenAI | OpenAI | `https://api.openai.com/v1` | `gpt-4-turbo` |

+| 通義千問 Qwen | Alibaba | `https://dashscope.aliyuncs.com/compatible-mode/v1` | `qwen-plus` |

+| 豆包 Seed | ByteDance | `https://ark.cn-beijing.volces.com/api/v3` | `doubao-1.5-pro-32k` |

+| Gemini | Google | `https://generativelanguage.googleapis.com/v1beta/openai/` | `gemini-2.0-flash` |

+| Grok | xAI | `https://api.x.ai/v1` | `grok-3-mini` |

+| Mistral | Mistral AI | `https://api.mistral.ai/v1` | `mistral-tiny` |

+| Groq | Groq | `https://api.groq.com/openai/v1` | `mixtral-8x7b-32768` |

+| Perplexity | Perplexity AI | `https://api.perplexity.ai/v1` | `pplx-7b-online` |

+| Kimi Chat | 月の暗面 (Moonshot AI) | `https://api.moonshot.cn/v1` | `moonshot-v1-8k` |

+## 大モデルの設定

-## 配置大模型

-

-你需要做的只是把对应服务商的 apiToken 填入 openmcp 中即可。然后点击「测试」,看到下面的响应说明连接成功。您就可以在交互测试里面使用大模型了!

+対応するサービスプロバイダーのapiTokenをopenmcpに入力するだけです。その後「テスト」をクリックし、以下の応答が表示されれば接続成功です。インタラクションテストで大モデルを使用できるようになります!

:::warning

-有些用户会遇到无法访问的问题,请确保你的 baseUrl 填写正确。如果在国内使用某些国外厂商的服务,比如 gemini,openai,请确保你的网络环境可以访问到这些服务。在 「设置」-「通用」中你可以设置代理服务器。

+一部のユーザーはアクセスできない問題に遭遇する可能性があります。baseUrlが正しく入力されていることを確認してください。国内でGeminiやOpenAIなどの国外プロバイダーのサービスを使用する場合、ネットワーク環境がこれらのサービスにアクセスできることを確認してください。「設定」-「一般」でプロキシサーバーを設定できます。

:::

+## モデルの追加

-## 添加模型

+使用したい特定のプロバイダーのモデルがデフォルトでサポートされていない場合、2つの方法で追加できます。

-如果你想使用的指定服务商的模型不在默认支持的模型中,有两种方法可以添加它们。

+### 方法1:モデルリストの更新

-### 方法一:更新模型列表

-

-此处以通义千问为例子,确保在 apitoken 填写正确的情况下,点击「更新模型列表」,如果服务商严格实现了 openai 标准,那么就能看到所有更新的模型了。

+ここでは通義千問を例にします。apitokenが正しく入力されていることを確認した上で、「モデルリストを更新」をクリックします。プロバイダーがOpenAI標準を厳密に実装していれば、すべての更新されたモデルが表示されます。

-### 方法二:手动添加模型

+### 方法2:手動でのモデル追加

-如果你的服务器没有支持 openai 标准,你将无法使用「方法一」,你可以如此手动添加模型列表。此处以 Grok 为例,在服务商中找到 grok,点击图中所示的编辑

+サーバーがOpenAI標準をサポートしていない場合、「方法1」を使用できません。このように手動でモデルリストを追加できます。ここではGrokを例にします。プロバイダーリストからgrokを探し、図に示す編集をクリックします。

-点击模型,输入模型名称,回车,点击确认:

+モデルをクリックし、モデル名を入力してEnterキーを押し、確認をクリックします:

+APIページに戻り、保存をクリックします。

-回到 api 页面,再点击保存。

+## サービスの追加

-## 添加服务

-

-如果你要的服务商没有出现我们的列表中(云服务商的服务,或者自己部署的服务),可以通过「添加服务」按钮来添加自定义模型,使用方法和「添加模型」「方法二:手动添加模型」类似,就不赘述了。

+リストにないプロバイダーサービス(クラウドプロバイダーのサービスや自分でデプロイしたサービス)を使用する場合、「サービスの追加」ボタンでカスタムモデルを追加できます。使用方法は「モデルの追加」「方法2:手動でのモデル追加」と同様なので、ここでは繰り返しません。

\ No newline at end of file

diff --git a/ja/plugin-tutorial/usage/connect-mcp.md b/ja/plugin-tutorial/usage/connect-mcp.md

index 267d008..617e1a6 100644

--- a/ja/plugin-tutorial/usage/connect-mcp.md

+++ b/ja/plugin-tutorial/usage/connect-mcp.md

@@ -1,77 +1,73 @@

-# 连接 mcp 服务器

+# MCPサーバーへの接続

-不同于 Claude Desktop 和其他的 MCP 客户端类产品,OpenMCP 进行 MCP 服务器连接的步骤是相当丝滑的。

+Claude Desktopや他のMCPクライアント製品とは異なり、OpenMCPによるMCPサーバー接続の手順は非常にスムーズです。

-:::info MCP客户端

-MCP 客户端是指能够通过 MCP 协议进行通信的大模型对话客户端,通常是一个运行在本地的应用程序(因为网页没有文件IO的权限)。它的产品形式目前几乎都是聊天机器人的形式,类似于你在网页使用的 chat.deepseek.com 或者 chat.openai.com

+:::info MCPクライアント

+MCPクライアントとは、MCPプロトコルを通じて通信可能な大規模言語モデル対話クライアントのことで、通常はローカルで動作するアプリケーション(ウェブページにはファイルIOの権限がないため)です。その製品形態は現在ほぼチャットボット形式で、chat.deepseek.comやchat.openai.comのようなウェブサイトで使用するものと類似しています。

:::

-首先,打开你的 VLE,在 [[acquire-openmcp|获取 OpenMCP]] 中完成 OpenMCP 的安装后,我们先用 python 创建一个最简单的 mcp 服务器,来测试 mcp 客户端的连接。

+まず、VLEを開き、[[acquire-openmcp|OpenMCPの取得]]でOpenMCPのインストールを完了した後、pythonで最も簡単なmcpサーバーを作成し、mcpクライアントの接続をテストします。

+## OpenMCPでワンクリック接続

-## 使用 OpenMCP 一键连接

-

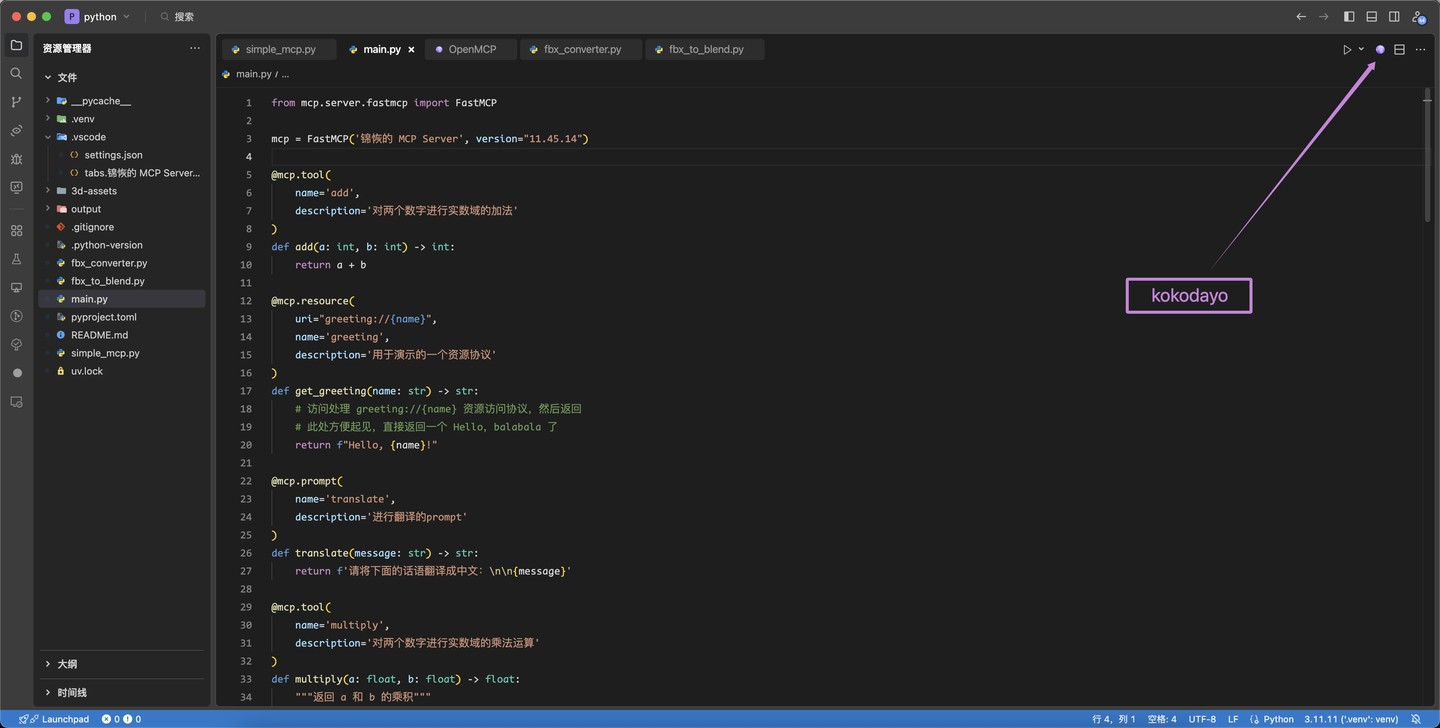

-在 [[first-mcp|你的第一个 MCP]] 这个例子中,我们申明了三个函数,用作 mcp 的 tool,resource 和 prompt。在 OpenMCP 中启动它们非常简单,点击右上角的 OpenMCP 图标即可连接:

+[[first-mcp|最初のMCP]]の例では、mcpのtool、resource、promptとして3つの関数を宣言しました。OpenMCPでこれらを起動するのは非常に簡単で、右上のOpenMCPアイコンをクリックするだけで接続できます:

-

-如果登录完成后,如图显示连接成功,则代表当前已经成功启动并连接 mcp 服务器。

+ログインが完了し、図のように接続成功が表示されれば、現在mcpサーバーが正常に起動・接続されたことを意味します。

-## STDIO 连接的启动

+## STDIO接続の起動

-对于 STDIO 为连接选项的开发方案,我们提供了一键式的快速启动,您不需要额外启动 mcp 的进程。OpenMCP 会自动连接和销毁。

+STDIOを接続オプションとする開発方案では、ワンクリックでの迅速な起動を提供しており、mcpプロセスを追加で起動する必要はありません。OpenMCPが自動的に接続と破棄を行います。

-目前支持的编程语言和它们对应的启动参数为:

+現在サポートされているプログラミング言語とそれに対応する起動パラメータは以下の通りです:

-|语言|连接参数|启动目录|

+|言語|接続パラメータ|起動ディレクトリ|

|:-|:-|:-|

-|python|uv run mcp run $\{file\} | 往上追溯,第一个找到的 pyproject.toml 的目录|

-|nodejs|node $\{file\}| 往上追溯,第一个找到的 package.json 的目录|

-|go|go run $\{file\}| 往上追溯,第一个找到的 go.mod 的目录|

+|python|uv run mcp run $\{file\} | 遡って最初に見つかったpyproject.tomlのディレクトリ|

+|nodejs|node $\{file\}| 遡って最初に見つかったpackage.jsonのディレクトリ|

+|go|go run $\{file\}| 遡って最初に見つかったgo.modのディレクトリ|

-## SSE & Streamable HTTP 连接的启动

+## SSE & Streamable HTTP接続の起動

-对于 SSE 和 Streamable HTTP 这两种远程连接的方式,由于我们并不知道您到底在哪个端口启动的服务器(因为你有可能把启动的 host 和 port 写在不可见的配置文件里或者写在环境变量里),因此,对于远程连接的情况,我们不支持自动创建服务器,您需要手动配置启动选项。

+SSEとStreamable HTTPという2つのリモート接続方式については、どのポートでサーバーが起動されているか分からない(起動hostとportが見えない設定ファイルや環境変数に書かれている可能性があるため)ため、リモート接続の場合、自動サーバー作成はサポートしておらず、手動で起動オプションを設定する必要があります。

-点击 VLE 左侧插件栏目的 OpenMCP,在 「MCP 连接(工作区)」 视图中,点击 + ,就可以创建一个新的连接。

+VLE左側のプラグインメニューにあるOpenMCPをクリックし、「MCP接続(ワークスペース)」ビューで+をクリックすると、新しい接続を作成できます。

-

-

-选择你需要的通信方式。

+必要な通信方式を選択します。

-输入MCP Server的地址。

+MCP Serverのアドレスを入力します。

:::info

-需要注意的是,不同的通信方式一般使用不同endpoint,目前的MCP server大多遵循下面的原则:

+注意が必要なのは、異なる通信方式は一般的に異なるendpointを使用することです。現在のMCP serverの多くは以下の原則に従っています:

-如果是以 SSE 启动,那么默认使用 /sse 作为endpoint,比如 http://localhost:8001/sse

+SSEで起動する場合、デフォルトで/sseをendpointとして使用します。例:http://localhost:8001/sse

-如果是以 Streamable Http 启动,那么默认使用 /mcp 作为endpoint,比如 http://localhost:8001/mcp

+Streamable Httpで起動する場合、デフォルトで/mcpをendpointとして使用します。例:http://localhost:8001/mcp

-当然,允许MCP Server使用两个不同的endpoint同时支持两种连接方式,这对于想要迁移到Streamable Http但短时间又不能放弃SSE的情况特别有效

+もちろん、MCP Serverが2つの異なるendpointを使用して両接続方式を同時にサポートすることも可能で、Streamable Httpに移行したいが短期的にSSEを放棄できない状況に特に有効です

:::

-## openmcp 插件的控制面板

+## openmcpプラグインのコントロールパネル

-在 VLE 的左侧可以找到 openmcp 的图标,点击后就是 openmcp 的控制面板。

+VLEの左側にopenmcpのアイコンがあり、クリックするとopenmcpのコントロールパネルが表示されます。

-当前工作区曾经连接过的 mcp 服务器会出现在这里,这是因为 openmcp 默认将工作区启动的 mcp 的连接信息存储在了 `.openmcp/tabs.{server-name}.json` 中,其中 `{server-name}` 就是 mcp 服务器连接成功的服务器名称。

+現在のワークスペースで以前接続したmcpサーバーはここに表示されます。これは、openmcpがデフォルトでワークスペース起動時のmcp接続情報を`.openmcp/tabs.{server-name}.json`に保存しているためで、`{server-name}`はmcpサーバー接続成功時のサーバー名です。

:::warning

-注意,同一个项目中,你不应该有两个名字完全相同的 mcp 服务器,这会导致 `.openmcp/tabs.{server-name}.json` 连接信息存储冲突,发生未知错误。

+注意:同じプロジェクト内で、名前が完全に同じmcpサーバーを2つ持つべきではありません。これにより`.openmcp/tabs.{server-name}.json`の接続情報保存が衝突し、未知のエラーが発生する可能性があります。

:::

-如果你想要在任意工作区都能使用同一个 mcp 服务器,可以考虑在「安装的 MCP 服务器」中添加成熟耐用的 mcp 服务器,这个位置添加的 mcp 服务器全局可用。

+任意のワークスペースで同じmcpサーバーを使用したい場合は、「インストール済みMCPサーバー」に成熟した耐久性のあるmcpサーバーを追加することを検討してください。この場所に追加されたmcpサーバーはグローバルに使用可能です。

-在「入门与帮助」中,我们准备了一些可供入门的参考资料,还请阁下善加利用。

+「入門とヘルプ」では、入門用の参考資料をいくつか準備しています。ぜひご活用ください。

\ No newline at end of file

diff --git a/ja/plugin-tutorial/usage/debug.md b/ja/plugin-tutorial/usage/debug.md

index c38fd98..5bd2a5e 100644

--- a/ja/plugin-tutorial/usage/debug.md

+++ b/ja/plugin-tutorial/usage/debug.md

@@ -1,44 +1,44 @@

-# 调试 tools, resources 和 prompts

+# デバッグ tools、resources、prompts

-## 标签页

+## タブ

-openmcp 以标签页作为调试项目的最小单元,点击栏目中的 + 可以创建新的标签页。OpenMCP 的 tools, resources 和 prompts 的基本使用与 Inspector 差不多,但是 OpenMCP 会自动帮您完成左侧资源列表的初始化,Inspector 中这一步需要手动完成。

+openmcpはタブをデバッグ項目の最小単位としており、ナビゲーションバーの+をクリックすると新しいタブを作成できます。OpenMCPのtools、resources、promptsの基本的な使用方法はInspectorとほぼ同じですが、OpenMCPは自動的に左側のリソースリストの初期化を行います。Inspectorではこの手順を手動で行う必要があります。

-## 调试内容的自动保存

+## デバッグ内容の自動保存

-openmcp 具备自动保存测试结果的功能。如下的行为会触发 openmcp 对标签页及其内容进行保存:

+openmcpにはテスト結果を自動保存する機能があります。以下の動作が発生すると、openmcpはタブとその内容を保存します:

-- 创建标签页,并选择一个有效的调试项目

-- 在调试页进行调试行为(选择工具,执行工具,询问大模型等)

+- タブを作成し、有効なデバッグ項目を選択した場合

+- デバッグページでデバッグ操作(ツールの選択、ツールの実行、大規模モデルへの質問など)を行った場合

-当前 mcp 项目的测试数据会被保存在 `.openmcp/tabs.{server-name}.json` 中,其中 `{server-name}` 就是 mcp 服务器连接成功的服务器名称。

+現在のmcpプロジェクトのテストデータは`.openmcp/tabs.{server-name}.json`に保存されます。ここで`{server-name}`はmcpサーバーが正常に接続されたサーバー名です。

:::warning

-注意,同一个项目中,你不应该有两个名字完全相同的 mcp 服务器,这会导致 `.openmcp/tabs.{server-name}.json` 连接信息存储冲突,发生未知错误。

+注意:同じプロジェクト内で名前が完全に同じmcpサーバーを2つ持つべきではありません。これにより`.openmcp/tabs.{server-name}.json`の接続情報保存に競合が発生し、未知のエラーが発生する可能性があります。

:::

-## 快速调试

+## クイックデバッグ

-在我们调试的过程中,难免会出现大模型回答得不好,而且这是因为某个工具出错导致的,为了快速定位是不是工具的问题,可以点击下方的小飞机图标

+デバッグプロセス中に、大規模モデルの回答が不十分で、これが特定のツールのエラーによるものである場合、問題がツールにあるかどうかを迅速に特定するために、下部の小さな飛行機アイコンをクリックできます。

-点击后,OpenMCP 会一个新的测试 tool 的项目,并自动把当时大模型使用的参数自动填充到右侧的表单中:

+クリックすると、OpenMCPは新しいテストツールプロジェクトを作成し、大規模モデルが使用したパラメータを自動的に右側のフォームに入力します:

-你要做的,只是点击运行来确定或者排除一个错误选项。

+あなたがするべきことは、実行をクリックしてエラーオプションを確認または除外することだけです。

-## pydantic 支持

+## pydanticサポート

-使用 python 的 fastmcp 进行 tool 的创建时,你有两种方法来申明接口的类型,一种是通过 python 默认的 typing 库来申明复杂数据结构,或者通过 pydantic 来申明一个复杂的变量,下面是一个例子:

+Pythonのfastmcpを使用してtoolを作成する際、インターフェースのタイプを宣言する方法は2つあります。1つはPythonのデフォルトのtypingライブラリを使用して複雑なデータ構造を宣言する方法、もう1つはpydanticを使用して複雑な変数を宣言する方法です。以下は例です:

```python

from mcp.server.fastmcp import FastMCP

from pydantic import BaseModel, Field

from typing import Optional, Union, List, NamedTuple

-mcp = FastMCP('锦恢的 MCP Server', version="11.45.14")

+mcp = FastMCP('錦恢の MCP Server', version="11.45.14")

class PathParams(BaseModel):

start: str

@@ -54,15 +54,14 @@ def test(

return [test1, test2, test3, params]

```

-由于我们对这两种类型的申明方式实现了内部的转换,所以 openmcp 都是支持的。值得一提的是,如果你申明的变量是一个对象,比如上面的 `PathParams`,那么 openmcp 的 tool 调试窗口会生成一个「对象输入框」,这个输入框支持基本的格式检查和自动补全:

+これら2種類の宣言方法に対して内部変換を実装しているため、openmcpはどちらもサポートしています。特に、宣言した変数がオブジェクト(上記の`PathParams`など)の場合、openmcpのtoolデバッグウィンドウは「オブジェクト入力ボックス」を生成します。この入力ボックスは基本的な形式チェックとオートコンプリートをサポートします:

-:::info 什么是对象?

-这里的「对象」是 javascript 中的概念,它指的是可被序列化的数据类型中,除去基本数据类型后,剩下的那部分。比如 { "name": "helloworld" } 就是一个对象。对象在 python 中更加类似于一个 dict 或者 namedTuple。

+:::info オブジェクトとは?

+ここでの「オブジェクト」はJavaScriptの概念で、シリアライズ可能なデータ型の中で基本データ型を除いた部分を指します。例えば{ "name": "helloworld" }はオブジェクトです。Pythonでは、オブジェクトはdictやnamedTupleに似ています。

:::

:::warning

-虽然 openmcp 已经做到了尽可能多情况的支持,但是生产场景中,我们仍然不建议您将 mcp tool 的参数定义成对象,尽可能定义成简单数据类型也能更好提高大模型进行工具调用时的稳定性。

-:::

-

+openmcpは可能な限り多くのケースをサポートしていますが、生産環境ではmcp toolのパラメータをオブジェクトとして定義することは推奨しません。シンプルなデータ型として定義することで、大規模モデルがツールを呼び出す際の安定性を向上させることができます。

+:::

\ No newline at end of file

diff --git a/ja/plugin-tutorial/usage/distribute-result.md b/ja/plugin-tutorial/usage/distribute-result.md

index 2ea20c1..9c50b6d 100644

--- a/ja/plugin-tutorial/usage/distribute-result.md

+++ b/ja/plugin-tutorial/usage/distribute-result.md

@@ -1,14 +1,14 @@

-# 分发您的实验结果

+# 実験結果の配布

-## 标签页恢复

+## タブの復元

-openmcp 默认会实时保存您的实验结果,每一个在工作区开启的服务器默认会将结果存储在 `.openmcp/tabs.{server-name}.json` 中,其中 `{server-name}` 就是 mcp 服务器连接成功的服务器名称。

+openmcpはデフォルトで実験結果をリアルタイムに保存します。ワークスペースで開かれた各サーバーは、結果を`.openmcp/tabs.{server-name}.json`に保存します。ここで`{server-name}`はmcpサーバー接続が成功したサーバー名です。

-请确保您的 `.gitignore` 文件中没有包含匹配到 .openmcp 文件夹的规则。这样,当您通过 git 提交你的代码,对 agent 的代码进行管理时,当你在别的电脑上 clone 或者他人 clone 你的项目时,就能快速恢复你上一次的实验内容,继续进行实验或者开发调试。

+.gitignoreファイルに.openmcpフォルダに一致するルールが含まれていないことを確認してください。これにより、gitでコードをコミットしたり、agentのコードを管理したりする際に、他のコンピュータでcloneしたり、他の人があなたのプロジェクトをcloneした場合に、前回の実験内容を迅速に復元し、実験や開発デバッグを継続できます。

-## 连接恢复

+## 接続の復元

-每一个 mcp 服务器的连接信息会被保存在 `.openmcp/connection.json` 中,下面是一个例子:

+各mcpサーバーの接続情報は`.openmcp/connection.json`に保存されます。以下は例です:

```json

{

@@ -28,11 +28,11 @@ openmcp 默认会实时保存您的实验结果,每一个在工作区开启的

"clientVersion": "0.0.1",

"env": {},

"serverInfo": {

- "name": "锦恢的 MCP Server",

+ "name": "錦恢の MCP Server",

"version": "1.9.2"

},

"filePath": "{workspace}/simple-mcp/main.py",

- "name": "锦恢的 MCP Server",

+ "name": "錦恢の MCP Server",

"version": "1.9.2"

}

]

@@ -40,5 +40,4 @@ openmcp 默认会实时保存您的实验结果,每一个在工作区开启的

}

```

-

-当您打开左侧的控制面板或者打开一个过去打开过的 mcp 服务器时, mcp 默认会根据上面的信息来获取工作区的服务器列表或者尝试进行自动连接。如果 openmcp 在连接 mcp 时发生了初始化错误或者保存错误,除了向 openmcp 官方求助外,您还可以尝试手动管理 `.openmcp/connection.json` 文件。

\ No newline at end of file

+左側のコントロールパネルを開くか、過去に開いたmcpサーバーを開くと、mcpはデフォルトで上記の情報に基づいてワークスペースのサーバーリストを取得したり、自動接続を試みたりします。openmcpがmcpに接続する際に初期化エラーや保存エラーが発生した場合、openmcp公式に助けを求める以外に、`.openmcp/connection.json`ファイルを手動で管理することもできます。

\ No newline at end of file

diff --git a/ja/plugin-tutorial/usage/multi-server.md b/ja/plugin-tutorial/usage/multi-server.md

index d12bb56..d17238c 100644

--- a/ja/plugin-tutorial/usage/multi-server.md

+++ b/ja/plugin-tutorial/usage/multi-server.md

@@ -1,35 +1,34 @@

-# 连接多个 MCP 服务器

+# 複数のMCPサーバーに接続する

-openmcp 支持连接多个 MCP 服务器。

+openmcpは複数のMCPサーバーへの接続をサポートしています。

-假设你现在想要实现一个可以自动查阅资料并且整理成 word 文档的 agent,你可以这样做:

+例えば、資料を自動的に検索しWord文書にまとめるagentを実装したい場合、以下のようにできます:

-1. 找到能进行网络搜索的 mcp:[crawl4ai mcp](https://github.com/LSTM-Kirigaya/openmcp-tutorial/tree/main/crawl4ai-mcp)

-2. 找到能进行 word 操作的 mcp:[Office-Word-MCP-Server](https://github.com/GongRzhe/Office-Word-MCP-Server)

-3. 在 openmcp 中把它们组合起来。

-4. 自动完成你的任务!

+1. ウェブ検索可能なmcpを探す:[crawl4ai mcp](https://github.com/LSTM-Kirigaya/openmcp-tutorial/tree/main/crawl4ai-mcp)

+2. Word操作可能なmcpを探す:[Office-Word-MCP-Server](https://github.com/GongRzhe/Office-Word-MCP-Server)

+3. openmcpでこれらを組み合わせる

+4. タスクを自動完了!

-假设,我们已经连接了第一个 mcp,也就是 crawl4ai mcp,我们可以添加额外的 mcp 服务器:

+最初のmcp(crawl4ai mcp)に既に接続している場合、追加のmcpサーバーを接続できます:

-## 添加方法一:拖拽

+## 追加方法1:ドラッグ&ドロップ

-直接把需要加入的 mcp 服务器的文件,按住 shift 点击拖拽进入 openmcp 界面就能自动完成参数的填充。

+接続したいmcpサーバーファイルをShiftキーを押しながらopenmcpインターフェースにドラッグすると、パラメータが自動入力されます。

:::warning

-自动填充的命令不一定总是准确的,在 [STDIO 连接的启动](http://localhost:5173/openmcp/plugin-tutorial/usage/connect-mcp.html#stdio-%E8%BF%9E%E6%8E%A5%E7%9A%84%E5%90%AF%E5%8A%A8) 中我们说过这一点。具体的连接方法请阅读 [附录:关于 uv 启动 mcp 你必须知道的](http://localhost:5173/openmcp/plugin-tutorial/quick-start/first-mcp.html#%E9%99%84%E5%BD%95-%E5%85%B3%E4%BA%8E-uv-%E5%90%AF%E5%8A%A8-mcp-%E4%BD%A0%E5%BF%85%E9%A1%BB%E7%9F%A5%E9%81%93%E7%9A%84) 后自行判断。

+自動入力されたコマンドが常に正確とは限りません。[STDIO接続の起動](http://localhost:5173/openmcp/plugin-tutorial/usage/connect-mcp.html#stdio-%E8%BF%9E%E6%8E%A5%E7%9A%84%E5%90%AF%E5%8A%A8)で説明した通りです。具体的な接続方法は[付録:uvによるmcp起動の必須知識](http://localhost:5173/openmcp/plugin-tutorial/quick-start/first-mcp.html#%E9%99%84%E5%BD%95-%E5%85%B3%E4%BA%8E-uv-%E5%90%AF%E5%8A%A8-mcp-%E4%BD%A0%E5%BF%85%E9%A1%BB%E7%9F%A5%E9%81%93%E7%9A%84)を読んで判断してください。

:::

-## 添加方法二:手动填写参数

+## 追加方法2:手動パラメータ入力

-手动填写参数,没啥好说的。

+手動でパラメータを入力します。特に説明はありません。

+## 複数サーバーの使用

-## 使用多服务器

+複数サーバー接続後の使用方法は単一サーバーと大きく変わりません。openmcpが内部でツールのスケジューリングと選択を自動的に行います。唯一の注意点は、複数サーバー間でtool名が重複しないようにすることです。重複すると競合が発生します。

-多服务器连接后的使用和单服务器没有太大的区别,openmcp 内部会自动完成工具的调度和选择。唯一需要注意的是,多服务器的 tool name 一定不要重名,否则会出现冲突。

-

-如果您认为 tool 重名有存在的必要性,请通过 [issue](https://github.com/LSTM-Kirigaya/openmcp-client/issues) 让我们知道您的场景和想法,根据讨论,我们会支持。

\ No newline at end of file

+tool名の重複が必要なシナリオがある場合は、[issue](https://github.com/LSTM-Kirigaya/openmcp-client/issues)で使用ケースとアイデアを教えてください。議論を経て対応を検討します。

\ No newline at end of file

diff --git a/ja/plugin-tutorial/usage/sse-oauth2.md b/ja/plugin-tutorial/usage/sse-oauth2.md

index b717357..9b91620 100644

--- a/ja/plugin-tutorial/usage/sse-oauth2.md

+++ b/ja/plugin-tutorial/usage/sse-oauth2.md

@@ -1,28 +1,22 @@

-# MCP Server的OAuth鉴权实现

+# MCPサーバーのOAuth認証実装

-在使用 **SSE** 或 **Streamable HTTP** 进行连接时,为增强安全性可为接口设计鉴权机制,MCP 官方推荐采用 OAuth 协议。下面以获取 GitHub 用户信息为例,演示如何通过 openmcp-client 完成带 OAuth 认证的接口调试。

+**SSE**または**Streamable HTTP**を使用して接続する際、セキュリティを強化するためにインターフェースに認証メカニズムを設計できます。MCP公式ではOAuthプロトコルの採用を推奨しています。以下ではGitHubユーザー情報の取得を例に、openmcp-clientを使用してOAuth認証付きのインターフェースデバッグを完了する方法を説明します。

+## 1. Github OAuth認証IDとsecretの取得

+GitHubユーザー情報関連APIを使用するため、まずGitHub OAuthアプリのClient IDとClient secretを取得する必要があります。

-## 1. 获取Github OAuth认证ID和secret

-

-由于我们使用了Github用户信息相关API,需要先获取Github OAuth应用的Client ID和Client secret。

-

-先进入[Github Developers](https://github.com/settings/developers),点击`New OAuth App`新建一个OAuth APP,应用名称随便填,`Homepage URL`填写`http://localhost:8000`,`Authorization callback URL`填写`http://localhost:8000/github/callback`。然后点击`Register application`按钮,即可成功注册一个应用。

-

+[Github Developers](https://github.com/settings/developers)にアクセスし、`New OAuth App`をクリックして新しいOAuth APPを作成します。アプリケーション名は任意で入力し、`Homepage URL`には`http://localhost:8000`、`Authorization callback URL`には`http://localhost:8000/github/callback`を入力します。その後、`Register application`ボタンをクリックすると、アプリケーションが正常に登録されます。

+登録が成功したら、`Client ID`を記録し、`Generate a new client secret`をクリックして`secret`を生成します。secretは生成時にのみ表示されるので注意してください。

-注册成功后,请记录`Client ID`,然后点击`Generate a new client secret`生成一个`secret`,注意secret仅在生成的时候可见。

+## 2. 環境変数の設定

-## 2. 设置环境变量

+`Client ID`と`secret`を取得した後、それらを環境変数として設定する必要があります:

-在获取`Client ID`和`secret`之后,需要将其设置为环境变量:

-

-

-

-::: code-group

+::: code-group

```bash [bash]

export MCP_GITHUB_GITHUB_CLIENT_ID={{Client ID}}

export MCP_GITHUB_GITHUB_CLIENT_SECRET={{secret}}

@@ -39,39 +33,33 @@ set MCP_GITHUB_GITHUB_CLIENT_SECRET={{secret}}

```

:::

-注意:cmd里面设置环境变量请不要加引号。

+注意:cmdで環境変数を設定する際は引用符を付けないでください。

-## 3. 克隆源码

+## 3. ソースコードのクローン

-接下来,我们需要部署带有OAuth认证的MCP服务器。可以参照[官方python案例](https://github.com/modelcontextprotocol/python-sdk/tree/main/examples/servers/simple-auth)进行。

+次に、OAuth認証付きのMCPサーバーをデプロイします。[公式python案例](https://github.com/modelcontextprotocol/python-sdk/tree/main/examples/servers/simple-auth)を参照してください。

-需要先克隆官方python-sdk源码:

+まず公式python-sdkのソースコードをクローンします:

```bash

-git clone https://github.com/modelcontextprotocol/python-sdk/ # 克隆源码

-cd examples/servers/simple-auth # 进入对应的目录

+git clone https://github.com/modelcontextprotocol/python-sdk/ # ソースコードをクローン

+cd examples/servers/simple-auth # 対応するディレクトリに移動

```

-## 4. 启动MCP Server

+## 4. MCP Serverの起動

-先根据需要创建虚拟环境安装依赖,然后可以使用`uv`运行或者直接运行`python main.py`即可,注意需要先设置环境变量,不然启动会报错`2 validation errors for ServerSettings`。

+必要に応じて仮想環境を作成し依存関係をインストールした後、`uv`を使用して実行するか、直接`python main.py`を実行します。環境変数を設定していないと、起動時に`2 validation errors for ServerSettings`エラーが発生するので注意してください。

-## 5. 启动openmcp-client

+## 5. openmcp-clientの起動

-接下来,你就可以使用openmcp-client连接刚刚启动的server了,不管是使用网页端还是VSCode均可。

+これで、起動したばかりのserverにopenmcp-clientを使用して接続できます。ウェブ版でもVSCodeでも可能です。

-点击加号添加连接,根据server代码中的`--transport`参数决定是SSE还是Streamable HTTP。如果是SSE,则URL填写`http://localhost:8000/sse`;如果是Streamable HTTP,则URL填写`http://localhost:8000/mcp`。认证签名无需填写。

+プラス記号をクリックして接続を追加し、serverコードの`--transport`パラメータに基づいてSSEかStreamable HTTPかを決定します。SSEの場合、URLは`http://localhost:8000/sse`を入力します。Streamable HTTPの場合、URLは`http://localhost:8000/mcp`を入力します。認証署名は入力不要です。

-接下来连接到当前server,此时会自动打开一个网页进行认证,首次打开需要点击认证,认证成功后该网页会自动关闭。

+次に現在のserverに接続すると、自動的にウェブページが開き認証が行われます。初回アクセス時は認証をクリックする必要があり、認証が成功するとウェブページは自動的に閉じます。

-认证成功后,进入工具页面,应该能看到一个`get_user_profile`工具,点击使用就可以获取到你的Github个人信息了。

-

-

-

-

-

-

-

+認証が成功すると、ツールページに移動し、`get_user_profile`ツールが表示されるはずです。クリックして使用すると、GitHubの個人情報を取得できます。

+

\ No newline at end of file

diff --git a/ja/plugin-tutorial/usage/test-with-llm.md b/ja/plugin-tutorial/usage/test-with-llm.md

index 2108ec3..449f0af 100644

--- a/ja/plugin-tutorial/usage/test-with-llm.md

+++ b/ja/plugin-tutorial/usage/test-with-llm.md

@@ -1,72 +1,67 @@

-# 用大模型测试您的 mcp

+# 大モデルでMCPをテストする

-如果您完成了 [[connect-llm|连接 mcp 服务器]] 这一步,那么您就可以开始测试您的 mcp 了。

+[[connect-llm|MCPサーバーへの接続]]が完了している場合、MCPのテストを開始できます。

-在 [[put-into-llm|扔进大模型里面测测好坏!]] 中,我们已经通过一个简单的例子来展示来如何使用大模型测试您的 mcp。因此,这篇文章更多是讲解不便在「快速开始」中赘述的细节。

+[[put-into-llm|大モデルでテストしてみよう!]]では、MCPをテストする簡単な例を紹介しました。この記事では、「クイックスタート」では詳しく説明できなかった詳細について解説します。

+大モデルと対話する際に調整可能なパラメータ(入力欄の下にあるボタン群)について簡単に説明します。

-和大模型交互时,有一些参数可以选择,也就是输入框下面那一排按钮,我来简单介绍一下。

+## モデル選択

-## 选择模型

+名前の通り、使用するモデルを切り替えます。openmcpは会話ごとに使用されたモデルを記録します。この特性を活用して複数モデルの混合テストが可能です。

-顾名思义,你可以在这里切换你的模型。值得一提的是,openmcp 会以单条对话为粒度来记录每一条对话使用的模型。您可以利用这一特性来进行混合模型测试。

+目的のモデルが見つからない場合や追加したい場合は、[[connect-llm|MCPサーバーへの接続]]を参照してください。

-如果你没有找到你想要的模型,或是想要添加额外的模型,请移步 [[connect-llm|连接 mcp 服务器]] 来了解如何添加模型。

+## システムプロンプト

-## 系统提示词

-

-您可以在这里选择和添加系统提示词。

+システムプロンプトを選択または追加できます。

-openmcp 默认将您的系统提示词保存在 `~/.openmcp/nedb/systemPrompt.db` 中。您可以通过 nedb 来进行反序列化和拷贝。

+openmcpはデフォルトでシステムプロンプトを`~/.openmcp/nedb/systemPrompt.db`に保存します。nedbを使用してデシリアライズやコピーが可能です。

+## プロンプト

-## 提词

-

-您可以利用该模块来调用 mcp 服务器提供的 prompt 功能,生成的 prompt 字段会作为富文本被插入您的对话中。

+このモジュールでMCPサーバーが提供するprompt機能を呼び出せます。生成されたpromptフィールドはリッチテキストとして会話に挿入されます。

-## 资源

+## リソース

-您可以利用该模块来调用 mcp 服务器提供的 resource 功能,生成的 resource 字段会作为富文本被插入您的对话中。

+このモジュールでMCPサーバーが提供するresource機能を呼び出せます。生成されたresourceフィールドはリッチテキストとして会話に挿入されます。

-:::warning openmcp 不负责 resource 的数据持久化!

-请注意!每次对话完成后 resource 是否会被保存到磁盘完全由 mcp server 作者决定,openmcp 不负责 resource 的数据持久化!如果您发现关闭 openmcp 再打开,resource 彩蛋为空,这不是 openmcp 的 bug,而是 mcp server 作者没有支持数据持久化!

+:::warning openmcpはresourceの永続化を管理しません!

+注意!各会話終了後、resourceがディスクに保存されるかはMCPサーバー作者が決定します。openmcpを再起動後、resourceが空になってもopenmcpのバグではありません。MCPサーバー作者が永続化をサポートしていないためです!

:::

+## 単一応答での複数ツール呼び出しを許可

-## 允许模型在单轮回复中调用多个工具

-

-大模型在进行工具调用时,有时候会将在一次回复中要求调用多次工具,比如你想要同时获取三个网页的内容翻译,大模型可能会同时调用三次「网络搜索」工具(如果你提供了的话)。多次工具使用时,openmcp 会如此渲染调用执行过程:

+大モデルがツールを呼び出す際、1回の応答で複数ツールを呼び出す場合があります(例:3つのウェブページの翻訳を同時に取得する場合)。openmcpは並列ツール呼び出しを次のようにレンダリングします:

-openmcp 输入框的按钮中的「允许模型在单轮回复中调用多个工具」默认是点亮的。也就是允许大模型可以在一次回复中调用多次工具。

+「単一応答での複数ツール呼び出しを許可」オプションはデフォルトで有効です。

-有的时候,我们希望命令一条条执行,就可以选择把这个按钮熄灭。

+ツールを1つずつ実行したい場合は、このオプションを無効にします。

-:::warning 协议兼容性警告

-有的厂商(比如 gemini)不一定严格支持了 openai 协议,对于不支持 「允许模型在单轮回复中调用多个工具」的厂商,openmcp 的后端会自动将该选项关闭。

+:::warning プロトコル互換性に関する注意

+Geminiなど、OpenAIプロトコルの「単一応答での複数ツール呼び出し」を完全にサポートしていないベンダーもあります。その場合、openmcpバックエンドは自動的にこのオプションを無効にします。

:::

+## 温度パラメータ

-## 温度参数

+値が高いほど生成内容のランダム性が増します。汎用大モデルでは0.6~0.7が一般的なタスクに適しています。OpenMCPのデフォルト値は0.6です。

-温度参数越高,生成内容的随机性越强,对于通用大模型,个人建议参数为 0.6 ~ 0.7,会是一个适用于通用型任务的数值。OpenMCP 提供的默认值为 0.6。

+## コンテキスト長

-## 上下文长度

+大モデルが保持する最大対話数を指定します(デフォルト20)。合計40対話ある場合、openmcpは最後の20対話のみを送信します。

-上下文长度代表了大模型的最大上下文轮数,默认值为 20。举个例子,如果你和大模型对话产生了 40 轮数据(工具调用条数+你的问题数量+大模型回答的次数总共 40 个),那么下一次对话 openmcp 只会发送最后 20 条数据给大模型。

-

-:::warning 上下文长度不要太小!

-我们强烈不推荐你将这个数值设置低于 20,因为大模型接受工具调用的结果需要和之前的调用请求一一对应。如果不对应,大模型会返回注入 400 这样的错误。遇到这样的错误,请从最初一句话重启或者新开一个「交互测试」。

+:::warning コンテキスト長を小さくしすぎないで!

+20未満に設定するのは強く非推奨です。ツール呼び出し結果は以前のリクエストと正確に対応する必要があります。対応しない場合、400エラーが発生する可能性があります。この場合、新しい「対話テスト」を開始してください。

:::

-## MCP 服务器超时

-

-MCP 服务器默认超时时间为 30 秒,如果您的 mcp 服务器需要更长的时间才能完成任务,您可以通过「设置」「通用」来设置超时时间,单位为秒,该设置全局生效。

+## MCPサーバータイムアウト

+デフォルトのタイムアウトは30秒です。「設定」>「一般」で単位秒でグローバルに設定可能です。

\ No newline at end of file

diff --git a/ja/plugin-tutorial/usage/ui-color.md b/ja/plugin-tutorial/usage/ui-color.md

index cf53207..52164a6 100644

--- a/ja/plugin-tutorial/usage/ui-color.md

+++ b/ja/plugin-tutorial/usage/ui-color.md

@@ -1,25 +1,23 @@

# UI 配色

-## openmcp 的主题色随跟 vscode

+## openmcp のテーマカラーは vscode に連動

-openmcp 的主题颜色完全跟随 vscode,如果你想要更换 openmcp 的主题颜色,你只需要更换 vscode 的主题颜色即可。

+openmcp のテーマカラーは完全に vscode に連動しています。openmcp のテーマカラーを変更したい場合、vscode のテーマカラーを変更するだけでOKです。

-比如当你把颜色切换为社区知名主题 One Dark Pro 时,openmcp 的表现:

+例えば、コミュニティで有名なテーマ「One Dark Pro」に切り替えた時の openmcp の表示:

+## テーマカラーの切り替え

-## 切换主题色

-

-这里可以切换 openmcp 的主题色(默认是粉色)

+ここで openmcp のテーマカラーを切り替えられます(デフォルトはピンク)

+## Trae への特別サポート

-## Trae 的特殊支持

+openmcp は trae のデフォルトテーマカラーに対して追加サポートを提供しています。私たちはユーザーに、最適な操作性を得るために vscode、cursor、trae などの様々な VLE を試すことを推奨しています。

-openmcp 对 trae 的默认主题色都有额外的支持。我们也鼓励我们的用户尝试 vscode,cursor,trae 等不同的 VLE 来获得最佳手感。

-

-openmcp 官方文档大部分演示的例子都是基于 trae 的「深蓝」默认主题。

+openmcp 公式ドキュメントのデモ例の多くは、trae の「深藍」デフォルトテーマをベースにしています。

\ No newline at end of file

diff --git a/ja/plugin-tutorial/what-is-mcp.md b/ja/plugin-tutorial/what-is-mcp.md

index 8afe97d..775a040 100644

--- a/ja/plugin-tutorial/what-is-mcp.md

+++ b/ja/plugin-tutorial/what-is-mcp.md

@@ -1,18 +1,18 @@

-# 什么是 MCP?

+# MCPとは?

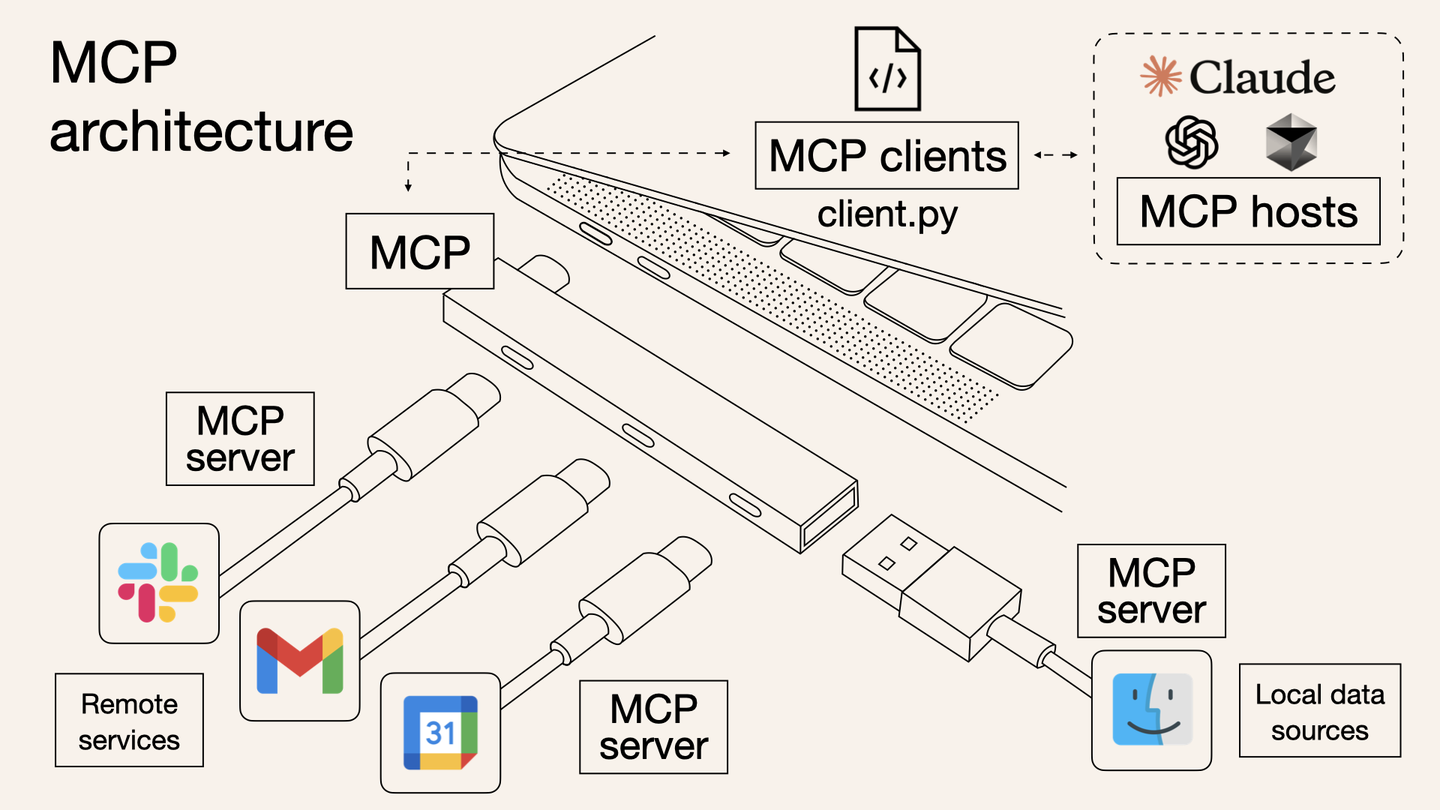

-MCP (Model Context Protocol)是一种开放协议,用于标准化应用程序如何向大型语言模型(LLMs)提供上下文。可以将 MCP 想象为 AI 应用的 typec 接口。正如 typec 提供了一种标准化的方式将您的设备连接到各种外设和配件,MCP 也提供了一种标准化的方式,将 AI 模型连接到不同的数据源和工具。

+MCP(Model Context Protocol)は、アプリケーションが大規模言語モデル(LLMs)にコンテキストを提供する方法を標準化するためのオープンプロトコルです。MCPをAIアプリケーションのType-Cインターフェースと想像してください。Type-Cがデバイスを様々な周辺機器やアクセサリに接続する標準化された方法を提供するように、MCPはAIモデルを異なるデータソースやツールに接続する標準化された方法を提供します。

-MCP 协议由 Anthropic 在 2024 年 11 月底推出:

+MCPプロトコルはAnthropicによって2024年11月末にリリースされました:

-- 官方文档:[Introduction](https://modelcontextprotocol.io/introduction)

-- GitHub 仓库:[github.com/modelcontextprotocol](https://github.com/modelcontextprotocol)

+- 公式ドキュメント:[Introduction](https://modelcontextprotocol.io/introduction)

+- GitHubリポジトリ:[github.com/modelcontextprotocol](https://github.com/modelcontextprotocol)

-## 为什么需要 MCP?

+## なぜMCPが必要なのか?

-我们都知道,从最初的 chatgpt,到后来的 cursor,copilot chatroom,再到现在耳熟能详的 agent,实际上,从用户交互的角度去观察,你会发现目前的大模型产品经历了如下的变化:

+私たちは皆、最初のchatgptから、後のcursor、copilot chatroom、そして現在よく知られているagentまで、実際にはユーザーインタラクションの観点から観察すると、現在の大規模モデル製品は以下のような変化を経てきたことがわかります:

``` mermaid

graph LR

@@ -21,161 +21,14 @@ a(chatbot > deepseek, chatgpt) --> b(composer > cursor, copilot) --> c(agent > A

```

- chatbot

- - 只会聊天的程序。

- - 工作流程:你输入问题,它给你这个问题的解决方案,但是具体执行还需要你自己去。

- - 代表工作:deepseek,chatgpt

+ - ただチャットするだけのプログラム。

+ - ワークフロー:あなたが質問を入力し、それがその質問の解決策を提供しますが、具体的な実行は自分で行う必要があります。

+ - 代表的な仕事:deepseek、chatgpt

- composer

- - 稍微会帮你干活的实习生,仅限于写代码。

- - 工作流程:你输入问题,它会给你帮你生成解决问题的代码,并且自动填入代码编辑器的编译区,你只需要审核确认即可。

- - 代表工作:cursor,copilot

+ - 少し手伝ってくれるインターン、コードを書くことに限られます。

+ - ワークフロー:あなたが質問を入力し、それが問題を解決するコードを生成し、自動的にコードエディタのコンパイル領域に入力します、あなたは確認するだけです。

+ - 代表的な仕事:cursor、copilot

- agent

- - 私人秘书。

- - 工作流程:你输入问题,它生成这个问题的解决方案,并在征询了你的同意后全自动执行。

- - 代表工作:AutoGPT,Manus,Open Manus

-

-

-

-为了实现 agent,也就需要让 LLM 可以自如灵活地操作所有软件甚至物理世界的机器人,于是需要定义统一的上下文协议与之上统一工作流。MCP(model context protocol) 就是解决这套方案的应运而生的基础协议。一个感性认识如下:

-

-```mermaid

-graph TB

-

-user(用户)

-ai(AI软件)

-llm(大模型)

-computer(本地环境)

-

-user --帮我整理两会报告中有\n关AI的咨询到word文件--> agent

-

-subgraph agent

-

-ai <--MCP--> llm

-computer <--MCP--> ai

-

-end

-

-agent --> word(D:/会议总结/两会报告AI专题.docx)

-

-```

-

-

-:::info

-

-Anthropic 对于 MCP 的必要性给出的解释:MCP 帮助您在 LLMs 之上构建 agent 和复杂的工作流程。LLMs 经常需要与数据和工具集成,而 MCP 提供了以下支持:

-

-- 一系列不断增长的预构建集成,您的 LLM 可以直接接入这些集成。

-- 在 LLM 提供商和供应商之间灵活切换。

-- 在基础设施内保护数据的最佳实践。

-

-:::

-

-

-

-

-

-## 总体架构

-

-MCP 的核心采用客户端-服务器架构,其中 host 可以连接到多个服务器:

-

-```mermaid

-graph LR

-

-host[Host MCP 客户端\n 浏览器, 代码编辑器, 其他工具]

-

-server_a[MCP 服务器 A]

-server_b[MCP 服务器 B]

-server_c[MCP 服务器 C]

-

-db_a[(本地\n数据源 A)]

-db_b[(本地\n数据源 B)]

-

-remote[(远程服务 C)]

-

-subgraph 你的电脑

-direction LR

-host <--MCP 协议--> server_a

-host <--MCP 协议--> server_b

-host <--MCP 协议--> server_c

-server_a <--> db_a

-server_b <--> db_b

-end

-

-

-subgraph 互联网

-server_c <--Web APIs--> remote

-end

-```

-

-

-

-- MCP 主机(MCP Hosts) :MCP 主机是指希望通过 MCP 访问数据的程序,例如 Claude Desktop、集成开发环境(IDEs)或其他 AI 工具。

-- MCP 客户端(MCP Clients):MCP 客户端是与服务器保持 1:1 连接的协议客户端,负责与 MCP 服务器通信。

-- MCP 服务器(MCP Servers):MCP 服务器是轻量级程序,每个服务器通过标准化的 Model Context Protocol 暴露特定的功能。

-- 本地数据源(Local Data Sources):本地数据源是指 MCP 服务器可以安全访问的计算机文件、数据库和服务。

-- 远程服务(Remote Services):远程服务是指 MCP 服务器可以通过互联网连接的外部系统(例如通过 API 访问的服务)。

-

-

-

-## MCP 的工作流程

-

-从工作流程上,MCP 和 LSP 非常非常像,事实上,目前的 MCP 和 LSP 一样,也是基于 [JSON-RPC 2.0](https://link.zhihu.com/?target=https%3A//www.jsonrpc.org/specification) 进行数据传输的(基于Stdio 或者 基于SSE)。如果开发过 LSP 的朋友对于 MCP 应该会感到非常的理所当然。我将用若干个简单明了的泳道图尽可能让大家看懂这玩意儿是如何执行的。

-

-### 初始化

-

-假设我们的软件已经支持了 MCP 客户端,那么当我们的软件启动时,它会经历如下的步骤:

-

-```mermaid

-graph TB

- subgraph MCP 客户端

- A1[初始化]

- A2[获取 MCP 服务端提供的工具集合 \n1. 创建文件 -> createFile\n2. 删除文件 -> deleteFile\n3. 使用搜索引擎 -> useBrowser\n 4. ...]

- end

-

- subgraph MCP 服务端

- B1[初始化]

- end

-

-A1 --startMCPServer--> B1

-B1 --ListToolsRequestSchema--> A2

-```

-

-

-

-### 工作流程

-

- 假设,你是一位 C语言工程师,你现在想要让 agent 自动完成一个项目的编译,那么执行流程如下:

-

-```mermaid

-graph TB

- subgraph MCP 客户端

- A1[用户询问 请帮我删除 build\n下的所有编译的中间结果] --> A2[将用户询问, 资源, MCP服务端的工具集合发送给大模型]

-

- A3[大模型返回操作流\n1. deleteFile build/a.o\n2. deleteFile build/b.o]

- A4[整理操作结果给大模型]

- A5[最终响应展示给用户]

- end

-

- subgraph MCP 服务端

- B1[解析大模型操作流] --征询用户同意--> B2[执行操作流]

- end

-

- subgraph 大模型

- C1[大模型基于上下文生成操作方案]

-

- C2[大模型基于所有信息生\n成自然语言响应]

- end

-

-A3 --> B1

-B2 --> A4

-A2 --> C1

-C1 --> A3

-A4 --> C2

-C2 --> A5

-```

-

-

-## 开源生态

-

-和 LSP 一样,LSP 在开源社区有非常多的客户端和服务端框架,MCP 也是一样的,目前 Anthropic 开源了一套 MCP 的服务端框架:https://github.com/modelcontextprotocol/servers ,想要探索大模型效用的朋友可以尽情去使用这个框架。这个仓库还收录了很多的官方认可的 MCP 服务器,可以作为学习的参考。

-

-除此之外,pulsemcp 上也有很多开源社区开发的 MCP 客户端和服务端:https://www.pulsemcp.com/clients

\ No newline at end of file

+ - プライベート秘書。

+ - ワークフロー:あなたが質問を入力し、それがその問題の解決策を生成し、あなたの同意を得た後、完全に自動的に実行します。

+ - 代表的な仕事:AutoGPT、Manus、Open Manus

\ No newline at end of file

diff --git a/ja/preview/changelog.md b/ja/preview/changelog.md

index 1d664bf..06ac7f5 100644

--- a/ja/preview/changelog.md

+++ b/ja/preview/changelog.md

@@ -1,86 +1,79 @@

----

-

----

-

-# Change Log

+# 変更履歴

## [main] 0.1.1

-- 修复 SSH 连接 Ubuntu 的情况下的部分 bug

-- 修复 python 项目点击 openmcp 进行连接时,初始化参数错误的问题

-- 取消 service 底层的 mcp 连接复用技术,防止无法刷新

-- 修复连接后,可能无法在欢迎界面选择调试选项的 bug

+- UbuntuへのSSH接続時のバグを修正

+- Pythonプロジェクトでopenmcpをクリックして接続する際の初期化パラメータエラーを修正

+- service層のmcp接続再利用技術を廃止し、リフレッシュ不能問題を防止

+- 接続後、ウェルカム画面でデバッグオプションが選択できないバグを修正

## [main] 0.1.0

-- 新特性:支持同时连入多个 mcp server

-- 新特性:更新协议内容,支持 streamable http 协议,未来将逐步取代 SSE 的连接方式

-- impl issue#16:对于 uv 创建的 py 项目进行特殊支持,自动初始化项目,并将 mcp 定向到 .venv/bin/mcp 中,不再需要用户全局安装 mcp

-- 对于 npm 创建的 js/ts 项目进行特殊支持:自动初始化项目

-- 去除了 websearch 的设置,增加了 parallel_tool_calls 的设置,parallel_tool_calls 默认为 true,代表 允许模型在单轮回复中调用多个工具

-- 重构了 openmcp 连接模块的基础设施,基于新的技术设施实现了更加详细的连接模块的日志系统.

-- impl issue#15:无法复制

-- impl issue#14:增加日志清除按钮

+- 新機能: 複数mcpサーバーへの同時接続をサポート

+- 新機能: プロトコル内容を更新し、streamable httpプロトコルをサポート(今後SSE接続方式を段階的に置換)

+- issue#16実装: uv作成のpyプロジェクト向け特別サポート(自動初期化、mcpを.venv/bin/mcpに自動設定)

+- npm作成のjs/tsプロジェクト向け特別サポート: 自動プロジェクト初期化

+- websearch設定を削除、parallel_tool_calls設定を追加(デフォルトtrue: 単一応答内での複数ツール呼び出し許可)

+- openmcp接続モジュールインフラをリファクタリング、詳細なログシステムを実装

+- issue#15実装: コピー不能問題

+- issue#14実装: ログ消去ボタン追加

## [main] 0.0.9

-- 修复 0.0.8 引入的bug:system prompt 返回的是索引而非真实内容

-- 测试新的发布管线

+- 0.0.8で導入されたバグ修正: system promptがインデックスではなく実際の内容を返すように

+- 新しいリリースパイプラインをテスト

## [main] 0.0.8

-- 大模型 API 测试时更加完整的报错

-- 修复 0.0.7 引入的bug:修改对话无法发出

-- 修复 bug:富文本编辑器粘贴文本会带样式

-- 修复 bug:富文本编辑器发送前缀为空的字符会全部为空

-- 修复 bug:流式传输进行 function calling 时,多工具的索引串流导致的 JSON Schema 反序列化失败

-- 修复 bug:大模型返回大量重复错误信息

-- 新特性:支持一次对话同时调用多个工具

-- UI:优化代码高亮的滚动条

-- 新特性:resources/list 协议的内容点击就会直接渲染,无需二次发送

-- 新特性:resources prompts tools 的结果的 json 模式支持高亮

+- 大規模モデルAPIテスト時のエラーレポートを強化

+- 0.0.7で導入されたバグ修正: 会話編集が送信できない問題

+- リッチテキストエディタの貼り付けスタイル問題を修正

+- リッチテキストエディタの空文字送信問題を修正

+- ストリーミング中のfunction calling時、マルチツールインデックスによるJSON Schemaデシリアライズ失敗を修正

+- 大規模モデルの重複エラーメッセージ問題を修正

+- 新機能: 単一会話での複数ツール同時呼び出しをサポート

+- UI: コードハイライトのスクロールバーを最適化

+- 新機能: resources/listプロトコルコンテンツのクリック直接レンダリングを実装

+- 新機能: resources/prompts/toolsのJSON結果表示にハイライトをサポート

## [main] 0.0.7

-- 优化页面布局,使得调试窗口可以显示更多内容

-- 扩大默认的上下文长度 10 -> 20

-- 增加「通用选项」 -> 「MCP工具最长调用时间 (sec)」

-- 支持富文本输入框,现在可以将 prompt 和 resource 嵌入到输入框中 进行 大规模 prompt engineering 调试工作了

+- ページレイアウトを最適化し、デバッグウィンドウの表示領域を拡大

+- デフォルトコンテキスト長を10→20に拡張

+- 「一般オプション」に「MCPツール最大呼び出し時間(秒)」を追加

+- リッチテキスト入力欄をサポート、大規模prompt engineeringデバッグ作業が可能に

## [main] 0.0.6

-- 修复部分因为服务器名称特殊字符而导致的保存实效的错误

-- 插件模式下,左侧管理面板中的「MCP连接(工作区)」视图可以进行增删改查了

-- 新增「安装的 MCP 服务器」,用于安装全局范围的 mcp server

-- 增加引导页面

-- 修复无法进行离线 OCR 的问题

-- 修复全局安装的 mcp 服务器 name 更新的问题

+- サーバー名特殊文字による保存不具合を修正

+- プラグインモードで左パネルの「MCP接続(ワークスペース)」ビューのCRUD操作を実現

+- 「インストール済みMCPサーバー」を追加(グローバル範囲mcp server管理)

+- ガイドページを追加

+- オフラインOCR不能問題を修正

+- グローバルインストールmcpサーバーのname更新問題を修正

## [main] 0.0.5

-- 支持对已经打开过的文件项目进行管理

-- 支持对用户对应服务器的调试工作内容进行保存

-- 支持连续工具调用和错误警告的显示

-- 实现小型本地对象数据库,用于对对话产生的多媒体进行数据持久化

-- 支持对于调用结果进行一键复现

-- 支持对中间结果进行修改

-- 支持 system prompt 的保存和修改

+- 開いたことのあるファイルプロジェクトの管理をサポート

+- ユーザー別サーバーデバッグ作業内容の保存をサポート

+- 連続ツール呼び出しとエラー警告表示を実装

+- 小型ローカルオブジェクトデータベースを実装(会話生成マルチメディアの永続化)

+- 呼び出し結果のワンクリック再現をサポート

+- 中間結果の編集をサポート

+- system promptの保存・編集をサポート

## [main] 0.0.4

-- 修复选择模型后点击确认跳转回 deepseek 的 bug

-- 修复 mcp 项目初始化点击工具全部都是空的 bug

-- 修复无法重新连接的 bug

-- 支持自定义第三方 openai 兼容的模型服务

+- モデル選択後確認クリックでdeepseekに戻るバグを修正

+- mcpプロジェクト初期化時ツールが空になるバグを修正

+- 再接続不能問題を修正

+- サードパーティOpenAI互換モデルサービスのカスタマイズをサポート

## [main] 0.0.3

-

-- 增加每一条信息的成本统计信息

-- 修复初始化页面路由不为 debug 导致页面空白的 bug

+- メッセージごとのコスト統計情報を追加

+- 初期化ページルートがdebugでない場合の白画面バグを修正

## [main] 0.0.2

-

-- 优化页面布局

-- 解决更新标签页后打开无法显示的 bug

-- 解决不如输入组件按下回车直接黑屏的 bug

-- 更加完整方便的开发脚本

+- ページレイアウトを最適化

+- タブ更新後の表示不能バグを解決

+- 入力コンポーネントでEnter押下時の黒画面バグを解決

+- より完全で便利な開発スクリプトを実装

## [main] 0.0.1

-

-- 完成 openmcp 的基础 inspector 功能

-- 完成配置加载,保存,大模型设置

-- 完成标签页自动保存

-- 完成大模型对话窗口和工具调用

-- 完成对 vscode 和 trae 的支持

+- openmcp基本inspector機能を完成

+- 設定読み込み/保存、大規模モデル設定を実装